Cosa sono i video ‘deepfakes’. Tra porno, politica e notizie false

8 min letturaNel 2018 abbiamo visto nascere i cosiddetti “deepfakes”: video contraffatti creati con l’aiuto dell’intelligenza artificiale, nei quali il viso di una celebrità viene sostituito a quello di un’attrice porno.

Oggi sono migliorati i programmi che permettono di effettuare la sostituzione di un viso ("face-swapping") in un video e questa pratica può essere usata anche come arma di propaganda. In questo articolo raccontiamo come nasce, come funziona e quali sono i principali rischi legati a questa tecnologia.

Porno con attrici o cantanti famose

Tutto ha avuto origine da una discussione su Reddit iniziata nel dicembre 2017 da una persona di cui non si conosce l’identità, chiamato appunto “Deepfakes”, che metteva a disposizione degli utenti alcuni software open-source di machine learning creati da lui, così come indicazioni dettagliate e consigli in tempo reale per poter realizzare video porno contraffatti.

Uno dei primissimi video creati utilizzando questi programmi è un porno che ha come protagonista l’attrice di Wonder Woman, Gal Gadot. Il video non è perfetto, ci sono alcuni momenti in cui si capisce chiaramente che qualcosa non va, ma complessivamente la qualità della falsificazione è veramente sorprendente, soprattutto se consideriamo che si tratta di una falsificazione fatta in casa.

L'aspetto più preoccupante, infatti, non è tanto il fatto che sia possibile realizzare un video falso di questo tipo alle porte del 2020. Hollywood ci ha educato da tempo all’utilizzo di effetti speciali, abbiamo visto rivivere Carrie Fisher nei panni della giovane Principessa Leila, in occasione di un prequel della saga Star Wars.

Ciò che realmente sorprende è, piuttosto, che grazie al programma creato da Deepfakes questa tecnologia, che un tempo richiedeva milioni di dollari di investimento e uno studio cinematografico alle spalle, è per la prima volta alla portata di (quasi) tutti.

Altri video simili sono stati realizzati utilizzando i volti delle attrici Daisy Ridley (sopra), Maise Williams, Scarlett Johansson ed Emma Watson e della cantante Taylor Swift. Questo elenco si è allargato nell'ultimo anno e ora è possibile trovare interi siti dedicati esclusivamente ai video deepfakes.

Ma non di solo porno vive la rete. C'è chi ha pensato bene di utilizzare questa tecnologia per inserire Nicholas Cage in decine di film famosi. Grazie.

Come funzionano i deepfakes e perché (per ora) le vittime sono solo celebrità

Per giornate intere, su Reddit, l’autore ha aiutato altri utenti a realizzare video porno falsi (la maggior parte con scarsi risultati) risolvendo i dubbi e dando consigli su come realizzare un montaggio convincente, prima di essere bannato a febbraio, presumibilmente per violazione della policy dal social network (che tra le altre cose vieta "impersonare l'identità di altre persone per creare un contenuto ingannevole", il "porno involontario" e i "contenuti presuntamente illegali").

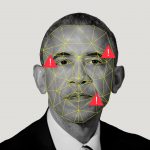

La prima cosa da tenere in considerazione è che la tecnologia dei deepfakes si basa sul machine learning, ossia sull’apprendimento automatizzato. Bisogna essere in grado di offrire al programma una grande quantità di video della persona che si vuole inserire, affinché l'intelligenza artificiale “apprenda” le espressioni facciali e sia in grado di realizzare una mappatura dei movimenti del viso. Più video vengono inseriti in questo “data set”, migliore sarà il risultato finale. Questa è una delle ragioni per cui i personaggi famosi (e i politici) sono le prime vittime potenziali di questa tecnologia.

Dopo aver caricato tutto il materiale multimediale a disposizione sulla vittima è necessario cercare un video che abbia come protagonista una persona somigliante. Una volta selezionato il video, il programma lavorerà per sostituire il viso del protagonista. È un processo piuttosto lungo e non sempre il risultato è buono. È indispensabile un computer molto potente, con una scheda video di ultima generazione, per poter effettuare i calcoli richiesti dal programma. Detto in altro modo, i tempi di realizzazione e la qualità del risultato finale dipendono dalla potenza della macchina.

Come avrete capito dopo questa spiegazione, si tratta di una tecnologia ancora agli albori che dipende principalmente da tre fattori: la potenza di calcolo del computer utilizzato, la disponibilità di una grandissima quantità di video della vittima, e la dimestichezza del realizzatore nell’uso di questo tipo di programma (la cui usabilità lascia molto a desiderare).

La buona notizia, quindi, è che almeno per ora questa tecnologia può essere usata come arma solamente nei confronti di chi ha una discreta visibilità mediatica. La cattiva notizia è che tutti noi possiamo essere micro-celebrità oggigiorno.

I porno falsi come arma: un nuovo tipo di molestia sessuale

In un'intervista pubblicata da VICE l'anno scorso, "Deepfakes" ha raccontato che la sua «speranza» è che programmi come questo siano presto alla portata di chiunque, anche di chi non ha grandi capacità informatiche, in modo che tutti possano «avere la possibilità di esplorare in prima persona la manipolazione tecnologica, oggi monopolio delle grandi compagnie». Lui prevede che questo accadrà in pochissimi anni.

Non è chiaro quali siano secondo il suo creatore le conseguenze positive di questa "democratizzazione tecnologica", ma è facile prevederne le esternalità negative: a partire dal "revenge porn" contraffatto.

Sì, è vero che il programma ha bisogno di una grande quantità di video ad alta qualità della vittima e, come abbiamo detto prima, è necessario un computer molto potente, ma dobbiamo ricordare due cose che potrebbero capovolgere la situazione di apparente sicurezza in cui ci troviamo. Il primo aspetto che non possiamo trascurare è che i giovanissimi hanno un rapporto diverso con la tecnologia rispetto alle generazioni che li hanno preceduti, soprattutto se parliamo di video e fotografie. Rubare la loro immagine è molto più facile, perché nell'era del web 2.0 siamo tutti micro-celebrità all'interno dei nostri circoli e delle nostre reti. Il secondo aspetto da considerare è il progresso tecnologico dei computer: inarrestabile ed esponenziale.

Semplificando con un esempio molto concreto: fra qualche anno sarà molto facile procurarsi i video di una compagna di classe per poter creare un porno falso. Nel futuro tutti potranno essere protagonisti, loro malgrado, di un video porno.

Scarlett Johansson, una delle prime vittime dei deepfakes, condivide gli stessi timori in un'intervista per il Washington Post, in cui ha dichiarato che presto chiunque potrebbe essere vittima di questo nuovo tipo di molestia sessuale. «Naturalmente, anche se è una cosa degradante, nel mio caso questi video non mi preoccupano eccessivamente, perché so che la maggior parte delle persone dà per scontato che quella non sono veramente io», spiega l'attrice.

Johansson ha anche ammesso con rassegnazione che secondo lei è inutile lottare contro questo fenomeno: «Nulla può impedire a qualcuno di ritagliare e incollare la mia immagine o quella di qualcun altro in un corpo differente e renderla realistica. La verità è che cercare di proteggere se stessi da questo tipo di depravazione è fondamentalmente una causa persa».

I deepfakes politici: la nuova frontiera della disinformazione?

In questo breve documentario del Wall Street Journal sono presi in esame diversi esempi di come questo tipo di tecnologia (non solo il pacchetto di programmi diffuso originalmente da "Deepfakes", ma anche altri programmi simili, tra cui quelli che permettono la sincronizzazione del labiale) può essere utilizzata per manipolare dichiarazioni di politici, informazioni giornalistiche, eventi storici o, perché no, con scopi satirici.

Un video in particolare ha risvegliato l'interesse della comunità giornalistica americana ed è quello che ritrae l'ex presidente Barack Obama mentre fa delle dichiarazioni inaspettate su alcuni dei sui avversari politici tra cui: «Il presidente Trump è un totale e completo stupido».

Si tratta chiaramente di un video falso creato per esemplificare le potenzialità dei deepfakes (termine ormai adottato per descrivere qualsiasi video contraffatto creato con software di intelligenza artificiale).

Il giornalista esperto di tecnologia e notizie false Craig Silverman ha provato a elencare in un articolo su BuzzFeed una serie di raccomandazioni per non farsi ingannare da quella che lui definisce "il futuro della propaganda": non saltare a conclusioni affrettate, controllare la fonte, contrastare le informazioni con altre fonti, controllare con attenzione il labiale, rallentare la velocità del video.

È probabile che questi consigli non ci siano del tutto nuovi. In fondo sono tutti accorgimenti dettati dal buonsenso e, in certa misura, sono le stesse pratiche che dovremmo seguire ogni volta che ci troviamo davanti a una notizia sospetta.

Cosa possono fare i media per arginare i deepfakes

L'esperto Nicholas Diakopoulos, assistant professor alla Northwestern University School of Communication, e autore del libro "Automating the News: How Algorithms are Rewriting the Media", sostiene che i deepfakes potrebbero offrire ai media mainstream la grande opportunità di riappropriarsi del loro ruolo di intermediari.

Naturalmente (e questo non `è assolutamente scontato) i media devono attrezzarsi di personale qualificato specializzato nella verifica multimediale e nell'uso di di strumenti tecnologici che rendono possibile creare e smascherare le falsificazioni video. Soprattutto tenendo in considerazione che i giornalisti sono il primo obiettivo di chi si dedica a creare e diffondere informazioni false: quante volte abbiamo visto un quotidiano nazionale amplificare una bufala senza averla verificata? Nella maggior parte dei casi questa negligenza è frutto dell'assenza di regole editoriali chiare riguardo le prassi da seguire durante processo di verifica dei fatti (prima di pubblicare una notizia), così come dell'impreparazione professionale.

Diakopoulos precisa che insegnare a utilizzare strumenti e tecniche di verifica è talmente importante che dovrebbe essere prioritario anche per le scuole e le università.

Se vogliamo arginare l'impatto dei deepfakes nella società non `è sufficiente che i media svolgano il loro ruolo naturale di intermediari nella verifica dei fatti, ma sono chiamati a fare uno sforzo ulteriore (ancora una volta) per educare la propria audience.

Come scrive Rubina Madan Fillion, digital engagement editor di Intercept e professoressa aggiunta alla Columbia Journalism School, "formare i giornalisti è un passo importante soprattutto se combinato con l'educazione del loro pubblico. Le organizzazioni giornalistiche dovrebbero rafforzare il rapporto di fiducia con i lettori e la diffusione di questi video diminuirà se saranno trasparenti su come la redazione controlla le immagini e i video prima di pubblicarli o scartarli". L'alfabetizzazione mediatica, come nel caso delle notizie false, gioca un ruolo fondamentale.

Per fortuna alcune redazioni hanno iniziato a occuparsi seriamente del fenomeno. Il Wall Street Journal non vuole essere colto impreparato dall'invasione di deepfakes che ci aspetta nei prossimi anni.

La redazione del quotidiano americano ha già iniziato a specializzarsi nel riconoscimento di questo nuovo e sofisticato genere di falsificazione.

"Qui al Wall Street Journal stiamo prendendo molto sul serio questa nuova minaccia, per questo abbiamo lanciato una task force interna dedicata ai deepfakes, guidata dal team di Etica & Standard e da quello di Ricerca & Sviluppo. Questo gruppo, il WSJ Media Forensic Committee, è composto da esperti di video, foto, investigazione, social network e notizie che sono stati preparati nel riconoscimento dei deepfakes. Oltre a questa iniziativa specifica, stiamo tenendo corsi e seminari con i giornalisti, stiamo preparando nuove linee guida per la redazione e stiamo collaborando con istituzioni accademiche per identificare e sviluppare strumenti tecnologici che ci aiutino a contrastare questo problema".

Un altro esempio di come i giornalisti possono "educare" il proprio pubblico è questo servizio della BBC che mostra come è facile contraffare un video per far credere che il giornalista televisivo Matthew Amroliwala (che parla solo inglese) sia capace di parlare diverse lingue. Il risultato è soprendente anche per lo stesso Amroliwala, che commenta il risultato finale.

Real or deepfake? See how many languages BBC presenter @AmroliwalaBBC can really speak! See how technology could impact what you see and hear. #BeyondFakeNews pic.twitter.com/JV94diOU0F

— BBC Click (@BBCClick) November 14, 2018

Video come quello della BBC servono come campanello d'allarme per ricordarci che ormai non possiamo fidarci neanche di quello che vediamo con i nostri stessi occhi. E forse il punto di partenza è semplicemente questo: accettare di dover estendere il nostro scetticismo anche ai video.

Foto in anteprima via Wired