Contenuti terroristici online: limiti e rischi del regolamento europeo #TERREG

12 min letturaIl 29 aprile 2021 (qui il comunicato stampa) il Parlamento europeo ha approvato il regolamento per affrontare la diffusione dei contenuti terroristici online (hashtag #TERREG, qui la proposta della Commissione, qui una prima analisi del 2018) senza votazione finale. I triloghi, incontri a tre (Consiglio, Parlamento e Commissione) a porte chiuse, iniziati il 17 ottobre 2019, si sono conclusi a dicembre 2020, con la stesura del testo condiviso da sottoporre al Parlamento.

Il regolamento nasce sull’onda di forti pressioni da parte della Germania (lettera al vicepresidente della Commissione) e della Francia (lettera al vicepresidente della Commissione), anche in vista delle elezioni europee del 2019. I rispettivi ministri degli Interni avevano chiesto che le aziende del web sviluppassero gli strumenti necessari per identificare e rimuovere i contenuti terroristici (e in genere illeciti), e che si scambiassero i valori di “hash” per consentire il filtraggio globale di tali contenuti. Si tratta delle tecniche di filtraggio algoritmico dei contenuti (upload filter del tipo di quelli utilizzati per le violazioni del copyright). Per quanto riguarda i valori di hash, il riferimento è al GIFCT (Global Internet Forum to Counter Terrorism) una piattaforma realizzata da Microsoft, Youtube, Facebook e Twitter nel 2016 , in modo da condividere gli hash di contenuti terroristici o di “glorificazione” del terrorismo, tra di loro e con altre aziende (Dropbox, Amazon, LinkedIn, WhatsApp, ecc...). È importante tenere presente che i contenuti (video, immagini) presenti in formato hash nel database (in base al quale vengono rimossi, quindi) non necessariamente violano norme nazionali (quanto piuttosto i TOS delle piattaforme).

Il governo francese, a seguito della decapitazione di un insegnante, si è detto pronto a inasprire le misure europee se ritenute insufficienti. E questo nonostante misure simili a quelle approvate siano state cancellate dal Consiglio Costituzionale francese.

Il regolamento segue la direttiva (Directive 2017/541 on Combatting Terrorism) che da settembre 2018 è attuabile, e che definisce un contenuto “terroristico” in maniera forse troppo ampia, e regolamenta la materia del contrasto e della repressione del terrorismo (in generale, non solo online) introducendo (art. 21) anche misure per contrastare i contenuti terroristici online.

Art. 21 - Direttiva Terrorismo

Misure per contrastare i contenuti online riconducibili alla pubblica provocazione

1. Gli Stati membri adottano le misure necessarie per assicurare la tempestiva rimozione dei contenuti online ospitati nel loro territorio che costituiscono una pubblica provocazione per commettere un reato di terrorismo come indicato all’articolo 5. Si adoperano inoltre per ottenere la rimozione di tali contenuti ospitati al di fuori del loro territorio.

2. Gli Stati membri possono, qualora non fosse possibile rimuoverei alla fonte i contenuti di cui al paragrafo 1, adottare misure per bloccare l’accesso a tali contenuti agli utenti di Internet sul loro territorio.

3. Le misure relative alla rimozione e al blocco devono essere stabilite secondo procedure trasparenti e fornire idonee garanzie, in particolare al fine di assicurare che tali misure siano limitate allo stretto necessario e proporzionate e che gli utenti siano informati del motivo di tali misure. Le garanzie connesse alla rimozione o al blocco includono anche la possibilità di ricorrere per via giudiziaria.

Il regolamento, invece, si occupa specificamente dei contenuti terroristici online, andando oltre la cooperazione volontaria, che è alla base delle precedenti iniziative, estendendo le misure della direttiva anche al materiale di reclutamento o di formazione di terroristi. Si inquadra nell’ambito delle iniziative della Commissione per affrontare i contenuti controversi online (Codice di condotta per affrontare i discorsi di odio online del 2016; Raccomandazione sulle misure per affrontare efficacemente contenuti illegali online del 2018; Codice di condotta per far fronte alla diffusione di disinformazione online e notizie false del 2018).

Le nuove regole, secondo il comunicato stampa, prevedono:

- Rimozione dei contenuti entro 1 ora;

- Opere educative, artistiche, giornalistiche e di ricerca sono protette;

- Nessun obbligo generale di utilizzo di sistemi di filtraggio.

Purtroppo, come accade sempre più spesso ultimamente, quanto sostenuto nei comunicati non sempre corrisponde alla realtà. Vediamo i punti salienti.

Applicabilità

La Commissione e il Consiglio hanno proposto che il regolamento si dovesse applicare a qualunque piattaforma che renda disponibili online informazioni a richiesta di un utente all’interno del territorio dell’Unione europea, compresi i servizi di messaggistica. Il Parlamento, invece, ha ritenuto che devono essere esentati i gruppi chiusi di utenti, costituiti da un numero finito di persone predeterminate (es. gruppi Whatsapp e in genere i servizi di messaggistica) e i fornitori di servizi cloud.

Il testo approvato riprende le proposte del Parlamento, ma anche così molti servizi online che consentono la pubblicazione di contenuti da parte degli utenti (un blog con commenti) sarebbero soggetti al regolamento. Questo è un problema, perché i tempi ristretti obbligheranno i gestori di blog a utilizzare forme di moderazione preventiva dei commenti per non subire sanzioni, rimuovendo tutto ciò che è dubbio per non doverne rispondere.

Rimozioni

La proposta della Commissione e del Consiglio era di introdurre obblighi di rimozione dei contenuti terroristici entro un’ora dalla ricezione di un ordine di rimozione. Il Parlamento ha proposto un’espressa eccezione per i casi di impossibilità di fatto non imputabile al fornitore di servizi di hosting, anche per motivi tecnici, introducendo un preavviso di 12 ore per il primo ordine di rimozione.

Il testo approvato (art. 3) prevede rimozioni nel più breve termine possibile, e in ogni caso entro 1 ora dall’ordine di rimozione. Ma per il primo ordine vige un preavviso di 12 ore, tranne i casi di urgenza. Le piattaforme più piccole o senza scopo di lucro possono giustificare il mancato rispetto del termine per “ragioni tecniche e operative” (ad esempio, il personale non lavora nei fine settimana). L’ordine di rimozione dell’autorità deve contenere l’indicazione precisa della url del contenuto da rimuovere, le ragione in base alle quali si ritiene “terroristico” il contenuto, e l’indicazione della possibilità di impugnare l’ordine dinanzi all’autorità o dinanzi a un tribunale. I contenuti non dovrebbero essere realmente rimossi, ma saranno oscurati e conservati per un termine minimo di 6 mesi, nel caso occorresse visionarli per finalità amministrative o giudiziarie.

I gestori di servizi di dimensioni minime (es. un blog gestito personalmente) si ritroveranno, quindi, a dover essere in grado di rimuovere contenuti in tempi brevissimi, e dovrebbero essere attivi 24 ore su 24, 7 giorni su 7, per non essere sanzionati. La proposta appare sproporzionata e eccessiva per le piccole aziende e le realtà non a scopo di lucro, in quanto raramente prese di mira dalla propaganda terroristica. Dovrebbero, quindi, predisporre un servizio per rispondere ad ordini di rimozione che sarebbe quasi certamente inutile (ma aumenterebbe i costi).

Il Consiglio Costituzionale francese ha già cancellato le norme (legge Avia) che prevedevano la cancellazione di contenuti online illeciti entro un ora per incompatibilità con la libertà di espressione. Ciò comporta che il testo attuale del Regolamento potrebbe già essere incostituzionale in Francia.

Il Regolamento prevede anche obblighi di trasparenza da parte dei provider, con riferimento alle rimozioni, sia attraverso la chiara indicazione nei termini di servizio della previsione di rimozioni di contenuti “terroristici”, anche eventualmente a mezzo di tool automatizzati, sia tramite la pubblicazione di report periodici sull’attività svolta a seguito degli obblighi previsti dal Regolamento. Anche le autorità nazionali competenti sono obbligate alla pubblicazione di report periodici.

Impugnazione delle rimozioni

Gli utenti che hanno caricato il contenuto oscurato devono essere avvertiti dell’oscuramento e del motivo di tale rimozione, e hanno il diritto di impugnare la rimozione del contenuto rivolgendosi direttamente al provider di hosting che ha eseguito l’ordine. Tale comunicazione non si ha solo se l’autorità competente ritiene che potrebbe danneggiare eventuali indagini in corso.

Il provider dovrà valutare l’eventuale reclamo nel termine di 15 giorni, fornendo una spiegazione alla sua decisione, in caso di rigetto. In ogni caso deve essere prevista sempre la possibilità di rivolgersi ad un’autorità amministrativa o giudiziaria.

Autorità e loro poteri

Secondo la normativa gli Stati membri possono stabilire liberamente a quali autorità assegnare il compito di ordinare le rimozioni, prevedendo però che l’autorità scelta non deve ricevere istruzioni da altre autorità nello svolgere i compiti previsti dal Regolamento. Il rischio è che un’autorità possa abusare delle norme per ordinare la rimozione di contenuti (senza controllo giudiziario) per motivi politici, così sanzionando anche il mero dissenso politico. Laddove non sia previsto uno stringente requisito di indipendenza la norma non impedirebbe a uno Stato di designare un Ministero appositamente per tale compito, piuttosto che un’autorità indipendente, e quindi sarebbe possibile assegnare al ministro degli Interni il potere di censurare contenuti online.

A questo proposito il Consiglio Costituzionale francese ha dichiarato che l’ampliamento della definizione di autorità (quindi consentire alle forze dell’ordine di emettere ordini di rimozione) risulta in violazione della Costituzione perché non coinvolge le autorità giudiziarie, che sono le naturali autorità demandate a stabilire cosa è lecito e cosa non lo è.

Fini educativi, artistici, giornalistici o di sensibilizzazione

Secondo la proposta della Commissione e il testo del Consiglio la rimozione dei contenuti avrebbe potuto essere ordinata anche in caso di contenuti divulgati a fini educativi, artistici, giornalistici o di ricerca o per scopi di sensibilizzazione contro l’attività terroristica. La proposta della Commissione prevedeva la possibilità di rimuovere contenuti indipendentemente dalla finalità di diffusione, per cui gli archivi che documentano crimini di guerra (es. Siria) avrebbero potrebbero essere rimossi, con cancellazione di prove e conseguente maggiore difficoltà nel provare i crimini di guerra. Il Parlamento, invece, ha ritenuto di dover preservare la divulgazione di materiali a fini educativi, giornalistici, artistici o di ricerca.

Quest’ultimo è il testo che è stato approvato. Ma rimane il problema che la decisione potrebbe spettare a un’autorità non giudiziaria, che quindi stabilirebbe cosa è “giornalismo”, o “educazione”, o “arte”, insieme al provider. Il problema è stato già sollevato in relazione ai whistleblower (vedi il video in fondo).

Competenza territoriale

La Commissione proponeva di dare il potere alle autorità nazionali di ordinare la rimozione di contenuti in qualsiasi altro Stato UE. Il Parlamento, invece, ha proposto che le autorità debbano avere il potere di ordinare la rimozione solo nei confronti degli hosting situati nel loro paese, mentre possono solo chiedere agli hosting di altri paesi la cancellazione dei contenuti.

Anche qui il problema è di eventuali abusi da parte di governi autoritari che potrebbero ordinare la rimozione di contenuti per tutta l’Europa. Ad esempio in Spagna le leggi antiterrorismo sono usate contro il movimento indipendentista catalano, e l’Ungheria ha trascorsi di questo genere contro gli attivisti ambientali, definiti “ecoterroristi”.

Il testo approvato prevede la possibilità di ordinare le rimozioni anche ai provider di altri Stati UE, ma nel contempo obbliga ad avvisare l’autorità del paese nel quale risiede l’azienda, la quale ha la possibilità di impugnare il provvedimento dell’autorità emittente. Ovviamente il provider potrebbe, in tal caso, rimuovere ugualmente il contenuto in base ai propri termini di servizio. Del resto se quel contenuto è ritenuto illecito da un’autorità dell’Europa, perché rischiare?

Diligenza e filtraggio dei contenuti

Il Regolamento include “doveri di diligenza” per le piattaforme, in base ai quali le aziende devono intraprendere azioni ragionevoli e proporzionate in conformità con il Regolamento, e dovrebbero includere e applicare, nei loro termini di servizio, specifiche disposizioni per impedire la diffusione di contenuti terroristici. Inoltre la proposta della Commissione è che i fornitori di hosting debbano usare “misure specifiche” per impedire il nuovo caricamento dei contenuti precedentemente eliminati e per identificare e rimuovere contenuti terroristici.

Anche se il Regolamento non impone sistemi automatizzati di filtraggio dei contenuti, molte piattaforme già fanno ricorso volontariamente a tali sistemi, laddove è notorio (qui uno studio di EFF che evidenzia come le aziende commettano regolarmente errori di moderazione dei contenuti, e rimuovono parodie o contenuti che documentano le violazioni dei diritti umani in paesi che vivono in guerra, come la Siria) che non sono in grado di comprendere il contesto per cui mai potrebbero capire se un contenuto terroristico è pubblicato per propaganda o per ragioni differenti (es. denunciare un crimine di guerra). La conseguenza è che numerosi contenuti del tutto leciti verrebbero rimossi, con pesanti ricadute sulla libertà di espressione. Non ha senso sostenere che il regolamento non impone i filtri quando alla fine, a causa della quantità enorme di contenuti immessi sulle piattaforme, l’unico modo per moderare tali contenuti è tramite i filtri.

In rete si trovano vari esempi di rimozioni per errore (Techdirt ne parla spesso), come i 550 contenuti rimossi su richiesta dell’autorità francese (French national Internet Referral Unit) per mezzo dell’Europol, visionabili su Internet Archive (tra cui un commentario sul Corano, libri di arte orientale – musulmana -, brani dei Grateful Dead e cosi via…). Anche l’operato del GIFCT è stato criticato per la rimozione di contenuti che si oppongono al terrorismo, contenuti di satira, resoconti di media, articoli giornalistici. Non dimentichiamo che una definizione riconosciuta di “materiale terroristico” non esiste, e sono qui le aziende private che decidono a loro discrezione cosa inserire nel GIFCT.

Conclusioni

Anche se alcuni dei problemi del testo originale sono stati arginati, rimangono delle questioni sospese:

- Incentiva strumenti di moderazione dei contenuti automatizzati (upload filters) anche nel settore pubblico;

- Non esiste un effettivo controllo giudiziario;

- Gli Stati membri emetteranno ordini di rimozione transfrontalieri.

Il regolamento, fortemente voluto da Germania e Francia, incentiva l’uso di filtri automatizzati per la gestione di contenuti online, sulla scia dell’idea che l’unico modo di controllare l'ecosistema digitale sia attraverso tali sistemi di filtraggio, già introdotti con la direttiva copyright riformata. La Commissione europea, quindi, continua a perseguire la strada della delega alle aziende private di funzioni statali (come sostanzialmente stabilito nella Raccomandazione del 2018) ma questa volta anche nel settore dell’ordine pubblico.

Le misure intraprese appaiono sproporzionate con riferimento alle piccole aziende e alle organizzazioni non a scopo di lucro, le quali potrebbero non riuscire a far fronte agli oneri impostigli. Di contro le grandi piattaforme del web sono perfettamente in grado di rispondere a tali misure, anzi nella maggior parte dei casi già hanno sistemi già collaudati e conformi alle regole. Facebook, Microsoft, Twitter e YouTube dal 2016 hanno un codice di condotta per la rimozione di contenuti terroristici (e non solo) in base al quale hanno creato un database di hash per contenuti di questo tipo, che condividono tra loro, così semplificando e massimizzando le operazioni di rimozione. Una delle tante alleanze di convenienza della grandi piattaforme del web per non dover sottostare a più pressanti regolamentazioni. E tutto questo finirebbe per essere un fortissimo disincentivo all’innovazione e alla concorrenza nell’ambiente digitale.

Il problema principale sta nell’impatto sui diritti fondamentali dei cittadini. Le Convenzioni internazionali e le leggi in materia di diritti fondamentali sono vincolanti per gli Stati ma non per le aziende private (anche se su questo punto , per fortuna, ultimamente i tribunali nazionali stanno modificando la loro prospettiva). Una delega alle aziende private, quindi, può avere un impatto negativo sui diritti fondamentali. Il regolamento in oggetto arriva fino al punto di imporre delle modifiche ai termini di servizio delle aziende, ma in tal modo si spostano le misure legislative al di fuori del campo delle leggi. Questo è estremamente pericoloso, appunto perché i termini di servizio delle aziende non devono rispettare i diritti fondamentali. Tutto ciò sarebbe ammissibile solo nel momento in cui fosse lo Stato a stabilire il quadro nel quale si possono muovere le aziende private, e quindi i confini oltre i quali non possono andare i loro poteri (cosa rimuovere e anche cosa non rimuovere).

Infine, al momento non c’è una dimostrazione chiara che tali misure di rimozione abbiano un reale impatto sul terrorismo e sulla propaganda del terrorismo. Uno studio del 2016 mostra che 15 terroristi identificati erano già ben noti alle autorità prima di aver compiuto gli attentati. Quindi il monitoraggio generalizzato dell’intera popolazione non appare realmente utile.

Tutti i 15 aggressori identificati erano su elenchi di allerta terrorismo o elenchi di "istigatori islamici" in almeno un paese europeo. Inoltre, la maggior parte era su altri elenchi, come gli elenchi di divieto di volo. Tutti e 15 erano stati classificati come inclini alla violenza. 14 avevano avuto contatti con altri islamisti radicali (uno di loro è stato apparentemente radicalizzato solo tramite Internet). Dodici avevano compiuto viaggi nello "Stato islamico", in Siria, o ad al-Qaeda in Iraq o nello Yemen. Dieci avevano precedenti penali, la maggior parte dei quali per crimini violenti.

Il problema un tempo si è riscontrato in Reddit, poi in Telegram, poi in Twitch ecc… In sostanza la rimozione dei contenuti porta per lo più alla migrazione della propaganda verso altre piattaforme, laddove al contempo si introducono misure drastiche di selezione dei contenuti con impatti rilevanti sulla libertà di espressione. Ciò porterà alla creazione di veri e propri “cartelli di contenuto”, cioè accordi tra le grandi piattaforme per la selezione dei contenuti online (stile televisione per capirci) e barriere rilevanti all’ingresso del settore delle piattaforme. Saranno i “cartelli” a stabilire gli standard per l’intera sfera pubblica di discussione. In questo modo si lascia l’intero controllo alle sole grandi piattaforme del web.

Per prevenire la radicalizzazione e il reclutamento dei terroristi sarebbe molto più utile affrontare seriamente la discriminazione contro le minoranze e le violazioni dei diritti umani. Inoltre servirebbe una migliore cooperazione internazionale, laddove oggi le misure antiterrorismo sono per lo più strumenti adottati al di fuori delle procedure democratiche e applicati alla generalità delle persone prima che sia commesso un reato, con violazione del principio di innocenza e gravi limitazioni alla libertà di corrispondenza e di espressione, senza alcune evidenza di loro efficacia. Per dirla in breve appare sempre più evidente un abbandono dei governi del campo della regolamentazione di determinati settori, anche pubblici, con delega alle aziende private che, quali sviluppatori e fonti della tecnologia, vengono viste come le uniche che possono qualcosa in materia.

Oltre 60 organizzazioni giornalistiche e per i diritti umani avevano pubblicato una lettera aperta al Parlamento per evidenziare i rischi del regolamento. Anche un gruppo di relatori speciali dell’ONU si era aggiunto alle critiche al regolamento.

Adesso il Regolamento dovrà essere pubblicato nella Gazzetta Ufficiale, e 20 giorni dopo entrerà in vigore. L’applicazione partirà 12 mesi dopo tale termine.

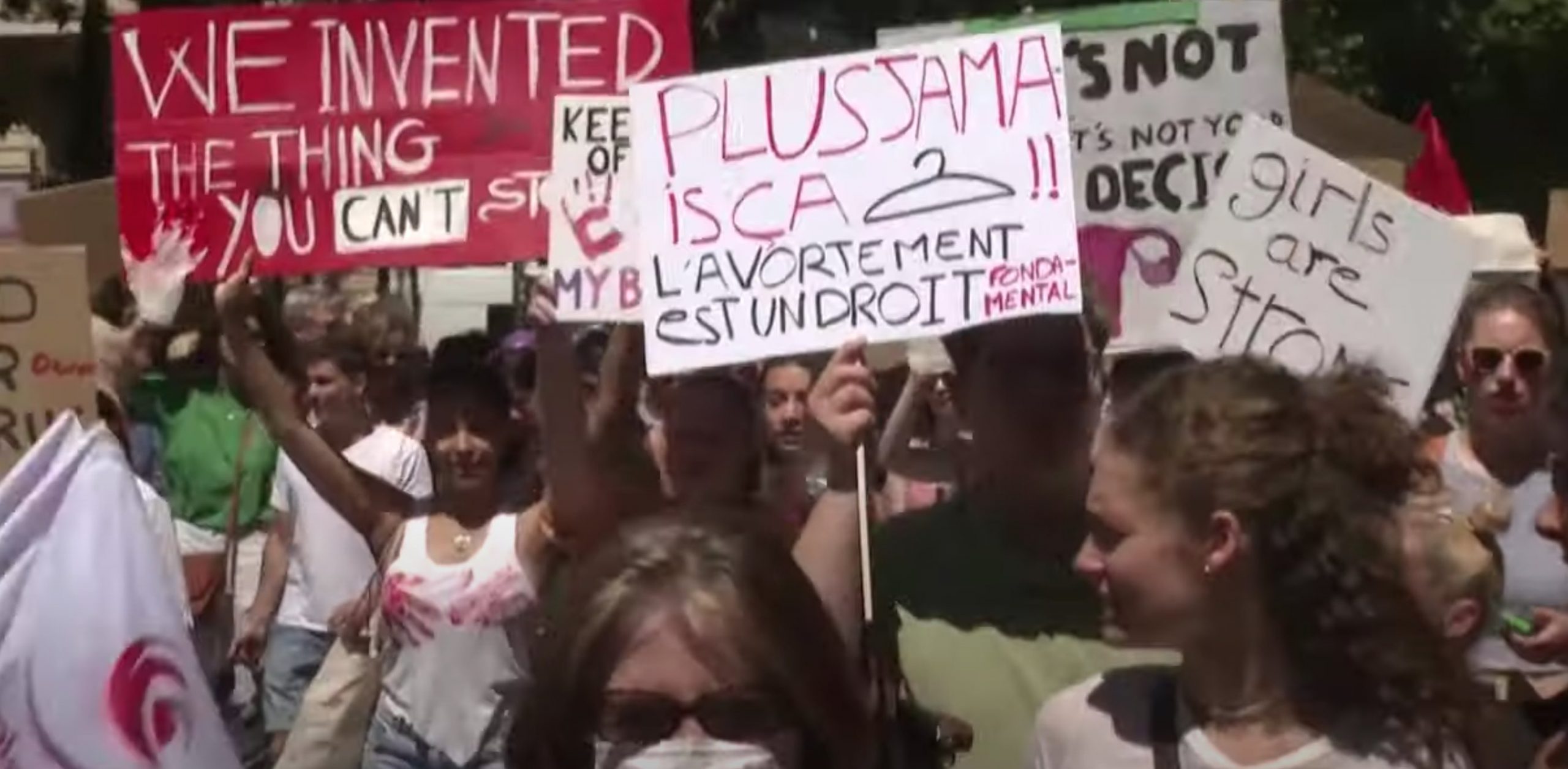

Immagine in anteprima via European Council