ChatGPT, i rischi per l’umanità e la sindrome SkyNet

|

|

Questo articolo è stato scritto con la collaborazione di ChatGPT (ver. March 23).

ChatGPT come Frankenstein?

Il risultato più probabile della realizzazione di un’intelligenza artificiale avanzata è che letteralmente sulla Terra tutti moriranno. Questa la certezza di Eliezer Yudkowsky che scrive sulla rivista Time. Ma che le AI siano un rischio per la civiltà umana è opinione ormai piuttosto diffusa. Lo sostiene Elon Musk, ma lo dice anche Sam Altman, il CEO di chatGPT. Quindi, sarà vero? In realtà, da buon “venditore”, Altman non fa altro che stuzzicare le ataviche paure occidentali dell’ignoto, un novello Frankenstein che costruisce il “mostro” che poi immancabilmente si ribella al suo padrone. Nella società occidentale è presente il terrore verso l’ignoto, la diversità, verso tutto ciò che non è umano e che in quanto tale minaccia l’integrità e l’individualità dell’essere umano come la tecnologia che mira a modificarci. Si tratta di retaggi religiosi che riguardano l’anima universale e incorruttibile che deve essere preservata nella sua interezza e nella sua essenza.

L’intelligenza artificiale generativa è qui. Siamo pronti? – Conversazione con Fabio Chiusi [podcast]

Ma Altman sa bene che per “vendere” il suo prodotto, cioè ChatGPT, deve magnificarne le potenzialità, anche distruttive, il che spiega le sue uscite sul rischio che le AI possano diventare pericolose per la civiltà umana. E qui trova facilmente la sponda dei mass media. Niente di nuovo. Anche con Cambridge Analytica si parlò di enormi rischi per la società in quanto evidenziarono le infinite possibilità di manipolazione della mente umana con rischi di alterarne il funzionamento, modificarne le scelte, fino a distruggere la democrazia. Considerato tutt’oggi uno dei più grandi scandali riguardanti la tecnologia, in realtà Cambridge Analytica non ha mai dimostrato di poter fare quello che sosteneva. Anzi, in un’inchiesta su Channel 4 si vede il CEO di Cambridge Analytica che, ripreso di nascosto, illustra il “piano” a un potenziale cliente. E il piano consiste nell’iniettare (cioè diffondere, ma “iniettare” appare più “sinistro”) internet di video di corruzione del candidato politico da sconfiggere e di suoi incontri con prostitute. Se davvero Cambridge Analytica avesse potuto fare ciò che prometteva avrebbe fatto ricorso alle prostitute?

Ed ecco che, forse, il problema si inquadra meglio, in una dimensione pubblicitaria. Ma anche concorrenziale. Con Elon Musk che, dopo aver cercato di mettere le mani su ChatGPT (Altman rifiutò) senza riuscirci (lui sostiene che lo ha fatto per poterla controllare), oggi avverte che le AI sono pericolose (la volpe e l’uva?) e quindi dovremmo fermarle. E poi? E poi c’è il suo di progetto, inscritto a pieno titolo nella nuova ideologia nascente, il "lungotermismo" (vedi anche Fabio Chiusi, "L'uomo che vuole risolvere il futuro"), in base alla quale più che pensare agli esseri umani di oggi dovremmo concentrarci sul garantire il potenziale a lungo termine dell’umanità. Perché preoccuparsi dei poveri e dei migranti se quello che importa è il potenziale a lungo termine? E soprattutto è l’Occidente, in particolare gli USA, che hanno contribuito a realizzare i progressi tecnologici e che quindi presumibilmente contribuiranno a favorire questo fantomatico potenziale umano. Perché, quindi, preoccuparci degli altri? E in questa prospettiva Musk propone di colonizzare altri pianeti, abbandonando il nostro al suo destino. Ecco perché anni fa lanciò SpaceX. Evidentemente il costo oggi è importante anche per un riccone come lui, e i finanziamenti che ottengono le AI (circa 92 miliardi di dollari nel 2022 secondo l'ultimo rapporto dello Stanford Institute for Human-Centered AI) gli farebbero proprio comodo. Insomma niente altro che un tentativo di distrarre i finanziamenti dalle AI verso il suo piano, il suo progetto, il suo prodotto.

Quindi, Altman fa pubblicità superlativa del suo stesso prodotto, Musk fa pubblicità comparativa tra il suo e il prodotto concorrente. A chi dobbiamo credere? Le AI sono davvero pericolose come dicono? E se lo sono, perché?

Ma andiamo per ordine.

Cosa è chatGPT?

ChatGPT (GPT sta per generative pre-trained transformer), rilasciato nel dicembre 2022 da OpenAI (nel marzo 2023 è stato lanciato GPT-4) – come viene precisato sul sito – è un modello linguistico addestrato per produrre testo e ottimizzato per il dialogo con gli esseri umani. Riferendosi a chatGPT spesso si parla di LLM, ovvero large language model, una tecnologia che è in grado di generare testo su una gamma apparentemente infinita di argomenti. Tra di essi abbiamo i Foundation Models, cioè Modelli di base, e i modelli di trasformazione del linguaggio (BERT) che utilizzano tecniche di apprendimento non supervisionato per la comprensione del linguaggio. Un LLM non è altro che una rete neurale di enormi dimensioni, laddove rete neurale indica un modello di apprendimento automatico basato su una serie di piccole funzioni matematiche (definite “neuroni” in analogia col cervello umano) che costituiscono il livello più basso di calcolo. Un “neurone” calcola un output in base a un input ricevuto, ma è il complesso della rete neuronale che è importante. Questa può essere costituita da poche connessioni, tuttavia, gli LLM ne hanno miliardi. Se la rete ha molti livelli di connessione, viene definita “profonda” (deep learning).

Un LLM utilizza una particolare architettura di rete neurale chiamata trasformatore (sviluppato nel 2017 dai ricercatori di Google per migliorare la traduzione automatica) che è specificamente progettata per generare dati in sequenza, come il testo. In un “trasformatore” alcuni neuroni sono connessi più fortemente ad altri neuroni (in gergo tecnico si dice che “prestano più attenzione”). Questo perché un testo viene letto in sequenza, parola dopo parola, per questo l’architettura è stata progettata per funzionare in questo modo.

Come per tutti i modelli di machine learning, anche per gli LLM i programmatori non scrivono l'algoritmo in modo esplicito, cioè le istruzioni da fornire al computer che elabora, bensì definiscono l’architettura del modello e le regole in base alle quali verrà costruito. Non creano i “neuroni” né definiscono il “peso” degli stessi. Questo avviene nel processo definito “addestramento”, realizzato con poche centinaia di miliardi di parole di testo (i dati di addestramento sono estratti da siti pubblici e selezionati, da articoli, libri, ecc...), durante il quale il modello definisce da sé le variabili (self-supervised). Si tratta di un processo lungo e costoso.

Il risultato della fase di addestramento è proprio la rete neurale costituita da centinaia di miliardi di connessioni tra i “neuroni”. Il peso di ogni neurone è una formula matematica che viene calcolata per ogni parola o parte di parola (definiti token) fornita al modello come input, e per ogni parola che genera come output. Le reti neurali sono impostate per avere una rete essenzialmente fissa di neuroni, ciò che viene modificato è il peso delle connessioni tra di loro.

Poiché l’attività di base di ChatGPT è capire come continuare una parte di testo che gli è stato fornito in input, tutto ciò che si fa nell’addestramento è mascherare la fine di un testo e fornirlo in input di allenamento. Poi è possibile dare un feedback a ChatGPT utilizzando il testo completo. Ovviamente diverse frasi simili generano statistiche che poi possono consentire a ChatGPT di variare le risposte (compreso le risposte errate). Un vantaggio di questi sistemi è che non è necessario taggare i dati per l’addestramento. Ad esempio, per i sistemi di riconoscimento delle immagini vengono fornite immagini con etichette (tag), tipo “questo è un cane”, “questo è un gatto”. Per ChatGPT non serve, il modello può imparare direttamente da qualsiasi testo fornito. Il modello, quindi, impara a “produrre” testo che alla fine diventa intellegibile e sempre più indistinguibile dal testo scritto da un umano.

ChatGPT incorpora anche un sistema di “ricompensa”, cioè gli utenti possono fornire feedback (pollice su o pollice giù) così precisando se il testo “generato” è leggibile o no (ha senso). Questo è l’apprendimento basato su rinforzo dal feedback umano (RLHF) che utilizzano sia OpenAI che Google. In questo modo il modello, tenendo conto del feedback, si migliora continuamente. Questa fase è stata un'idea chiave nella costruzione di ChatGPT, una messa a punto che sembra avere un grande effetto sul successo del sistema nel produrre un output simile all'uomo. Inoltre l’impressione è che se gli si dice qualcosa di bizzarro e inaspettato che non si adatta completamente alla struttura che conosce, non sembra che sarà in grado di "integrarlo" con successo.

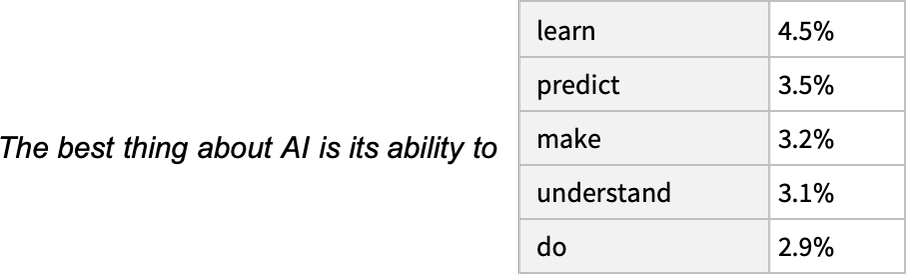

L’utente di ChatGPT o in generale di un LLM fornisce un input sotto forma di testo. Il modello dietro ChatGPT suddivide l’input (prompt) in token e calcola le relazioni tra le parole. Quindi comincia a generare una risposta in base ai suoi calcoli (miliardi). Il modello non ha una “memoria” dove cercare le singole parole dell’input, il testo di addestramento non viene archiviato direttamente, tutto ciò che fa è semplicemente generare un token in base ai “pesi” stabiliti per i token nella fase di addestramento, in modo che abbia la più alta probabilità di “suonare bene”. Cioè “genera” al volo una sequenza di parole che sono coerenti con il contesto e in genere col linguaggio umano.

L’abilità di un LLM non sta nel ricordare i fatti (per quello ci sono i database), il modello non capisce realmente quello che dice l’utente, non ha una comprensione effettiva delle parole, bensì utilizza modelli statistici e algoritmi di apprendimento automatico per produrre una “continuazione ragionevole” di qualunque testo abbia ottenuto finora, cioè quello che ci si potrebbe aspettare che qualcuno scriva dopo aver visto ciò che le persone hanno scritto su miliardi di altri testi. Ciò che fa ChatGPT è semplicemente chiedersi, dato il testo di input, quale dovrebbe essere la parola successiva. E continuando parola per parola, genera l’intera risposta. Il modello sottostante ChatGPT ha 175 miliardi di parametri per calcolare le probabilità della parola successiva che suoni abbastanza bene da fornire delle risposte ragionevoli e simili al linguaggio umano.

Per questo un LLM può fornire anche risposte imprecise o errate (anche del tutto inventate) se la risposta appare più coerente col contesto. Ovviamente l’evoluzione di questi chatbot avanza velocemente, e già con GPT-3 abbiamo modelli estremamente complessi e sofisticati che riescono a fornire risposte sorprendentemente precise. Ma è importante avere sempre bene in mente le limitazioni di questi software. La risposta può anche “suonare bene”, ma non è detto che sia sempre giusta.

I rischi degli LLM

Il principale problema degli LLM sta nel fatto che questi sistemi potrebbero essere utilizzati per funzioni per le quali non sono stati pensati e non sono adeguati. In teoria si potrebbe utilizzarlo per fargli riconoscere dei sintomi ed eseguire diagnosi, o per la terapia psicologica. Ma il modello non è stato realizzato per questo. Data la sua tendenza a “inventare” frasi che suonino bene può introdurre nelle risposte delle informazioni che per un non esperto della materia specifica appaiono plausibili e quindi degne di considerazione, ma che in realtà potrebbero essere errate o del tutto inventate. Vi sono stati dei casi nei quali ChatGPT ha inventato delle intere opere compreso citazioni con link (che ovviamente non portavano a nessuna pagina web).

Uno dei problemi principali riguardanti gli LLM e in generale le AI è l’antropomorfizzazione di questi sistemi. Anche la stessa dizione “intelligenza artificiale” è sbagliata, perché evoca ambientazioni fantascientifiche, con robot senzienti in grado di comprendere il linguaggio umano e di agire di conseguenza. Nella realtà una AI (Artificial intelligence) non è altro che un software complesso, programmato per prendere specifiche decisioni sulla base degli input ricevuti, e finora questi sistemi non hanno dimostrato nessuna vera intelligenza, ma per come sono presentati in particolare dai mass media vengono considerati come fossero quasi umani. Da qui il passo ad attribuirgli sentimenti o emozioni è piuttosto breve. Anche ChatGPT sembra generare emozioni in fin dei conti.

Inoltre, sono modelli basati sulla matematica, sui dati, una enorme quantità di dati, e questo porta immancabilmente a considerarli “autorevoli”. È lo stesso problema che riguarda gli algoritmi predittivi utilizzati dalla polizia, oppure in altri campi, il presupposto implicito è che le previsioni di un algoritmo, essendo basate su grandi quantità di dati (Big Data), siano intrinsecamente migliori di quelle umane, ma il problema è che i dati di input sui quali si addestra l’algoritmo sono dati selezionati dai programmatori e quindi possono soffrire di pregiudizi. Un problema analogo si ha con gli algoritmi che si addestrano da soli, come gli LLM. Alla fine la selezione dei dati di addestramento è sempre demandata ai programmatori, ma la quantità è talmente vasta che, si dice, il problema dei bias dei dati di addestramento dovrebbe essere risolto. Ma non è così. Quei dati vengono da libri, articoli, anche dal web, e quindi sono i dati che noi, come società nel suo complesso, produciamo, e che quindi soffrono sempre degli stessi pregiudizi che sono presenti nella nostra società.

L’algoritmo che prevede chi commetterà un crimine, tra poca trasparenza e pregiudizi

E così mentre assegniamo loro un’autorevolezza dovuta alla matematica, in realtà stiamo solo creando un amplificatore dei pregiudizi sociali, su larga scala, le cui risposte vengono prese per buone a prescindere. È il mito dell’efficienza tecnologica che ha portato l’NSA a raccogliere ogni possibile dato giustificandosi che serve a prevenire il terrorismo, anche se poi risulta indimostrata l’utilità dei sistemi di sorveglianza. Anche la profilazione di massa instaurata dalle piattaforme del web si appoggia sull’idea che più dati significa conoscere meglio l’individuo e quindi potergli “vendere” pubblicità personalizzata più utile. Ma in realtà non esiste alcuna effettiva prova che tutto ciò funzioni realmente, è per questo che la pubblicità online costa pochissimo, perché col digitale ci si è resi conto che la sua efficacia è estremamente bassa.

Uno studio del 2013, infatti, analizza l’efficacia del microtargeting di Facebook, evidenziando un tasso di conversione dello 0,05%. Lo scarso tasso di successo della pubblicità personalizzata significa che le piattaforme devono incentivare gli utenti per far generare abbastanza visualizzazioni di pagina per salvaguardare i propri profitti.

Quindi, i rischi più comuni degli LLM sono:

- Bias, possono riprodurre e amplificare i pregiudizi e i bias presenti nei dati utilizzati per addestrarli, portando a risultati imprecisi o discriminatori.

- Disinformazione, possono essere utilizzati per creare e distribuire rapidamente grandi quantità di contenuti dannosi, come la disinformazione, i deepfake e i contenuti inappropriati.

- Sicurezza dei dati, richiedendo quantità enormi di dati per l’addestramento potrebbero essere inclusi dati personali e informazioni sensibili e quindi diffonderli.

- Dipendenza tecnologica, potrebbero portare a una dipendenza eccessiva dalle tecnologie basate sull'IA.

- Controllo, potendo essere utilizzati per creare velocemente contenuti senza supervisione umana, potrebbero portare a situazioni di abuso o di controllo sulle informazioni.

Una problematica emersa con gli LLM è quella delle “allucinazioni”. Definite così in analogia con quelle umane, le allucinazioni artificiali sono le risposte dell’AI fornite quando non trova alcun dato utile e quindi inventa. Ad esempio, quando la AI sostiene di essere “umana”. È un fenomeno noto dal 2018 quando ne iniziarono a discutere i ricercatori di Google. Proprio per questo motivo Google ha sostenuto di avere delle remore ad aprire al pubblico la sua LLM, anche se poi è stata costretta per non perdere terreno rispetto a OpenAI e Microsoft, laddove quest’ultima, che finanzia OpenAI, ha inglobato ChatGPT nel suo motore di ricerca Bing.

Le "allucinazioni" si verificano proprio perché gli LLM non hanno alcuna comprensione della realtà sottostante al linguaggio, generano un testo che suona bene ma ha l'unico scopo di soddisfare la coerenza statistica col prompt (la domanda). La risposta segue costantemente questo principio delle relazioni tra le parole precedenti, per cui più lungo è l'output più c'è la possibilità di ottenere allucinazioni. La conoscenza umana non è solo linguistica, ma è basata su una serie di elementi che i computer non utilizzano. Non avendo un'esperienza diretta del mondo reale, non sono in grado di avere una consapevolezza della realtà, che noi umani otteniamo attraverso un procedimento di tentativi ed errori.

Questo è un serio problema - pensate se la AI fosse utilizzata per fornire una consulenza medica - ma nasce proprio dal fatto che c'è la tendenza a umanizzare le AI e fornire loro una sorta di autorevolezza. A ciò si aggiunge l’efficienza economica, se applicate su larga scala le AI consentirebbero alle aziende di risparmiare sui costi umani (di contro inducendo una dipendenza dalla tecnologia nell’azienda) da cui un forte incentivo a utilizzarle comunque. Si tratta di problemi noti che però non vengono correttamente spiegati al grande pubblico, nel mentre si aprono questi sistemi agli utenti invitandoli a sperimentare con essi.

ChatGPT in particolare in alcune occasioni ha addirittura inventato un curriculum di persone esistenti, producendo un output con articoli mai scritti, libri mai pubblicati e link a pagine web del tutto inesistenti. In questo senso ChatGPT è stata accusata di produrre “dati inesatti” fino a possibili diffamazioni. Ad esempio, il sindaco di Hepburn Shire in Australia, che è stato erroneamente indicato da ChatGPT di essere il colpevole di una corruzione laddove in realtà era colui che ha denunciato la corruzione alla polizia. Ma gli LLM non sono motori di ricerca e non hanno una base fattuale con la quale interagiscono, non hanno una memoria dove ritrovare dati e fatti. Un LLM produce un risultato che sia coerente con l’input, indifferentemente dalla verità fattuale di quel risultato.

In alcuni casi, le "allucinazioni" potrebbero anche dipendere dal fatto che i dati di addestramento sono inesatti. E' un problema che si è presentato in passato anche con Google Autocomplete, inizialmente accusato addirittura di diffamazione nel momento in cui alcune persone notavano suggerimenti di Google come “truffa”, “setta”, abbinati al loro nome. Il tribunale di Milano sentenziò che Autocomplete si limitava a riprodurre statisticamente i risultati delle ricerche più frequenti effettuate dagli utenti, non si trattava di un archivio, di contenuto strutturato o influenzato da Google. l search engine, infatti, non sono in grado di comprendere realmente il significato delle parole nella query, ma sono semplici sistemi probabilistici che restituiscono un risultato basato anche sulle precedenti ricerche di altri utenti. Se un certo risultato, ad esempio, ottiene un feedback positivo (il click), viene registrato e progressivamente può diventare il primo risultato fornito in caso di reiterazione di quella ricerca.

Allo stesso modo ChatGPT non ha un archivio proprio nel quale conserva dati, esatti o inesatti, semplicemente elabora i dati di input per creare la rete neurale che di fatto è una opera trasformativa rispetto ai dati forniti in input. La risposta di ChatGPT è quindi l’elaborazione statistica dei dati, sia la base di addestramento che il prompt fornito dall’utente. E il prompt influenza molto l'output (è importante tenerlo a mente, se ricevete risposte "strane" indagate meglio su cosa gli avete chiesto). ChatGPT produce disinformazione come la producono i motori di ricerca (che però hanno un proprio database di dati conservati) e come la produce un qualsiasi giornale o anche la stessa Wikipedia. Il problema della disinformazione è diffuso e serio ma di sicuro non è il rischio più importante riguardo ChatGPT.

Con la diffusione di ChatGPT molti si affannarono a scrivere che era una minaccia al motore di ricerca di Google perché più facile da utilizzare, e quindi lo avrebbe soppiantato nell’uso da parte degli utenti per le ricerche. Ciò ovviamente non è accaduto (i rischi per Google sono ben altri, tra i quali rimanere indietro nello sviluppo delle AI in conseguenza delle elefantiache proporzioni assunte dall'azienda che rende più difficile una reale innovazione) perché ChatGPT ha prodotto accidentalmente (non intenzionalmente) risultati inesatti e "allucinazioni", per cui come motore di ricerca si è rivelato ben poco affidabile. Ma questo ci fa capire come manchi una effettiva comprensione di come funziona questa tecnologia, e quindi i mass media tendono a “inventare” storie (dati inesatti?!) solo per vendere di più speculando sul timore per le nuove tecnologie. Non è la prima volta, non sarà l’ultima.

I rischi per gli LLM non sono dissimili da quelli per le altre tecnologie. Ad esempio la dipendenza tecnologica che può portare a disturbi dell’attenzione essendo progettate per attirare l’attenzione degli utenti e coinvolgerli (come Facebook), la diminuzione della capacità critica dipendente dall’affidamento alle risposte dell’AI, fino alla vera e propria dipendenza emotiva perché per alcune persone diventano dei sostituti delle interazioni sociali. Ma in questi casi i problemi sono effettivamente dell’AI oppure sono problemi sociali che non trovano una efficace soluzione nella vita reale? Se qualcuno si isola dipende dalle sue difficoltà a integrarsi in una società sempre più competitiva e che lascia sempre meno spazio alle persone, oppure è colpa dell’AI?

Paure finte e paure vere

Alcuni hanno suggerito (lettera firmata da Elon Musk e altri) di fermare le AI per sei mesi al fine di riflettere sui danni derivanti dal loro uso diffuso. L’opinionista di Bloomberg, Tyler Cowen, fa un paragone coi social media. Se nel 2006 avessimo deciso di sospenderli per riflettere sull’impatto sulla società cosa avremmo ottenuto? Anche oggi gli effetti non sono chiari, e ampiamente contestati. E se anche sospendessimo le AI in Europa e Usa, chi ci dice che la Cina lo farà? Nel frattempo la Cina ha annunciato la sua regolamentazione delle AI tipo ChatGPT.

Le “capacità” di ChatGPT appaiono strabilianti: vedendolo all’opera, si è portati a pensare che sia in grado di capire cosa gli diciamo, e che quindi sia dotato di una sorta di pensiero. Questo non è vero, anche se è possibile che in futuro i sistemi evolveranno enormemente. Ad esempio gli LLM saranno integrati con delle basi di conoscenza per fornire risposte sui fatti utilizzando un linguaggio naturale convincente.

Si tratta di una tecnologia che potrebbe impattare sulla nostra società in molti modi, e ovviamente alcuni sono positivi, ma altri negativi. Il problema è che raramente siamo a conoscenza di come si evolvono queste tecnologie. Occorre che i cittadini se ne approprino e che le aziende ci lavorino, ma difficilmente sappiamo in anticipo cosa avrà successo e cosa no. È difficile regolamentare cose che non ci aspettiamo che accadano. Nel frattempo il dibattito è fortemente polarizzato, tra coloro che hanno interessi nello sviluppo della AI e quelli che hanno interessi concorrenti, e nel mezzo ci sono i cittadini che faticano a capire cosa sta accadendo anche perché i media vagano tra la magnificazione dei prodotti e gli allarmi per il rischio che le AI diventino come Skynet. Ma molte delle promesse degli sviluppatori di AI sono ancora distanti nel tempo, stiamo ancora aspettando le famose auto a guida autonoma che fanno tutto da sole, che ci avevano promesso decenni fa. È importante capire esattamente cosa abbiamo realmente tra le mani prima di giudicare, e ChatGPT in fin dei conti non è altro che un potente strumento di predizione della parola successiva che suona meglio in linguaggio umano.

Ovviamente si tratta anche di una tecnologia dalle molteplici applicazioni, che potrebbe portare vantaggi a uno Stato rispetto a un altro. Per cui è sostanzialmente impossibile fermarne lo sviluppo. Ci sarà sempre qualcuno che continuerà a svilupparla. Ecco perché occorre una regolamentazione che non sia tale da bloccarla, ma sia in grado di guidarne lo sviluppo in modo da eliminare o limitare le negatività. Non dobbiamo dimenticare che le AI hanno consentito studi di enorme utilità per l’uomo, ad esempio, AlphaFold di DeepMind ha determinato le strutture di circa 200 milioni di proteine.

È ovvio che alcune cose dovranno cambiare, sarà necessario che le nuove tecnologie si adeguino alle leggi, ma nel contempo dobbiamo anche adeguare i nostri strumenti legali alle nuove tecnologie. Ad esempio gli sviluppatori di AI devono essere in grado di garantire la conformità alle leggi in relazione all’acquisizione dei dati di addestramento per i modelli. Ma ciò comporta che le leggi siano adeguate alle nuove tecnologie. Forse occorrono nuove licenze, molto probabilmente occorrerà adeguare anche il GDPR perché è difficile ritenere al momento che nell’ambito della normativa in materia di protezione dei dati personali lo scraping dei dati dal web sia giustificato sulla base dei legittimi interessi del titolare del trattamento. Il fatto che quei dati siano stati resi pubblici non implica necessariamente che tutti gli usi siano legittimi. Infatti nell’AI Act europeo è previsto che l’azienda deve seguire modelli di gestione adeguati, con riferimento alla raccolta dei dati e l’etichettatura (tagging), nonché esaminare le possibili distorsioni del modello (dati inesatti e allucinazioni). Quindi si allargano le possibilità di riuso dei dati ma nel contempo si aggiungono oneri di trasparenza verso l’utente.

In tema di copyright, invece, lo scraping è considerato legale (uso trasformativo) negli Usa sulla base di una decisione che riguardava Google, ma il problema si può porre con riferimento alle AI che generano immagini, e quindi sono addestrate con immagini prese dal web. È noto che Stable Diffusion e Midjourney hanno creato i loro modelli sulla base del set di dati LAION-5B, che contiene quasi sei miliardi di immagini con tag, raccolte indiscriminatamente dal web.

Occorrono nuove regole per una valutazione etica delle AI, regole per la mitigazione dei bias e regole per un monitoraggio delle AI al fine di individuare prontamente i possibili rischi, le politiche devono essere pro-innovazione senza minare le fiducia di questi strumenti. Ma è altrettanto importante che i politici, i legislatori, si facciano trovare preparati a questa sfida, di comprendere e quindi essere in grado di regolamentare correttamente le nuove tecnologie così da non doverne lasciare la regolamentazione nelle mani delle stesse aziende produttrici (il mercato) o semplicemente scadere nel panico ingiustificato. Occorre consapevolezza, non panico.

Le AI sono una tecnologia ancora agli albori, ma già adesso le capacità computazionali moderne ci stanno dimostrando che dei compiti (es. scrivere un saggio) ritenuti fondamentalmente troppo difficili per i computer in realtà sono più facili di quel che pensavamo, e quindi sono risolvibili dai computer moderni. ChatGPT, infatti, non ha alcuna conoscenza delle regole sintattiche e grammaticali, ma in qualche modo durante il suo addestramento le scopre implicitamente e poi le segue quando genera un output. Non è chiaro come, ma funziona. Un cervello umano ha una rete di 100 miliardi di neuroni, adesso con ChatGPT sappiamo che una rete neurale artificiale con circa 175 miliardi di neuroni artificiali è in grado di fare un lavoro sorprendentemente buono nel generare linguaggio umano. Quello che ci mostra ChatGPT in fin dei conti è anche come funziona un essere umano. Forse è questo che ci fa davvero paura.

Immagine in anteprima realizzata da Bing con tecnologia Dall-E