L’algoritmo che prevede chi commetterà un crimine, tra poca trasparenza e pregiudizi

10 min letturaÈ una giornata fredda quando il sergente Cole inizia il suo turno. Il sistema gli ha assegnato una strada da controllare. È disseminata di spazzatura perché lì ci vivono numerosi senzatetto. All’addiaccio, giorno dopo giorno. Il sergente ispeziona i ripari di fortuna, creati ad arte da uomini che non hanno altro che cartoni e stracci per ripararsi dal freddo. Una lunga fila di capanne di compensato e teloni. Da una di queste esce una donna, sporca e malvestita. È impaurita, ma vede l’agente in divisa, un po’ si rianima.

“Come vanno le cose?”, chiede l’agente con un sorriso.

La donna inizia a raccontarle la sua triste storia, quasi violentata qualche mese prima altrove. La vita per strada di una donna è davvero dura.

Qui non c’è niente, pensa il sergente guardandosi attorno. Riflettendo. Un tempo era una telefonata al 911 a portarli in una zona, oggi è un computer ronzante che macina milioni di dati sulla criminalità per sputare una predizione: quella mattina lì sarebbe avvenuto un furto.

Un algoritmo come giudice

Nel 2013 l’imputato Eric Loomis (Wisconsin v. Loomis) viene accusato e riconosciuto colpevole per aver partecipato a una sparatoria. Loomis è soggetto anche a una valutazione algoritmica del rischio di recidiva, in modo da personalizzare la condanna. Il software Compas (Correctional Offender Management Profiling for Alternative Sanctions) stima un alto rischio di recidiva. Quindi la condanna è di 6 anni di reclusione più 5 di libertà vigilata.

Loomis impugna la condanna sostenendo di non aver avuto la possibilità di valutare il funzionamento dell’algoritmo, e quindi di contestarne la decisione. Essendo un “segreto commerciale” (anche in quanto proprietà intellettuale), infatti, l’algoritmo non è conoscibile. Solo la decisione finale viene comunicata al tribunale. Loomis sostiene che l’utilizzo di un software decisionale algoritmico viola i suoi diritti, in particolare ritenendo che la sua condanna non fosse basata su elementi accurati.

Il tribunale, la corte di appello e la Corte Suprema del Wisconsin rigettano il ricorso. Compas utilizza dati pubblici e informazioni fornite dallo stesso imputato (sulla base di un questionario), quindi i dati sono accurati e comunque contestabili. Per cui vi è un sufficiente livello di trasparenza anche se il software non è conoscibile. Inoltre i giudici possono, a loro discrezione, non conformarsi alla valutazione di Compas, e quindi non utilizzarne i risultati. Nessuna violazione dei diritti di Loomis viene ritenuta sussistente.

Nel provvedimento, però, pur confermando la decisione, la corte evidenzia preoccupazione perché i giudici possono aver difficoltà nel comprendere le valutazioni algoritmiche del rischio di recidiva, in particolare non avendo informazioni sufficienti su come viene calcolato il risultato finale. La Corte Suprema conclude suggerendo di moderare l'entusiasmo per la valutazioni di rischio algoritmico.

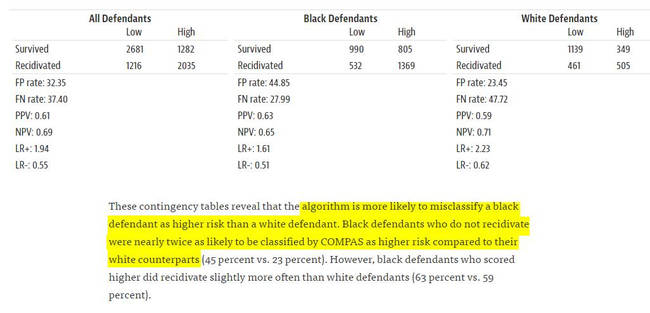

Nonostante i dubbi, i sistemi di intelligenza artificiale che forniscono supporto e valutazioni ai tribunali negli Stati Uniti si stanno moltiplicando. Molte giurisdizioni hanno adottato il software di Northpointe senza nemmeno verificare se funziona. I creatori di Compas sono Tim Brennan, all’epoca professore di statistica all'Università del Colorado, e Dave Wells, che gestiva un programma correzionale per detenuti. La Northpointe (poi acquisita da Equivant) nasce nel 1989 con l’intento di realizzare un software che misuri i tratti della personalità, così ricavandone un punteggio di valutazione del rischio di recidiva. Compas valuta non solo i rischi ma anche molti dei cosiddetti “bisogni criminogeni” derivanti dalle principali teorie della criminalità, tra cui la “personalità criminale”, l’“isolamento sociale”, l’“abuso di sostanze” e la “residenza” intesa come stabilità. Brennan precisa che è difficile costruire un “punteggio” che non includa elementi correlati alla razza, come la povertà, la disoccupazione e l'emarginazione sociale. Se vengono omessi elementi di questo tipo l’accuratezza dei profili diminuisce. Nel 2009 Brennan pubblica uno studio che attribuisce a Compas un grado di accuratezza del 68%, rivelando che il software era meno preciso per le persone di colore (67% rispetto al 69% dei bianchi).

Ma uno studio di ProPublica del 2016, in assenza di un analogo studio istituzionale, conclude che il software appare prevenuto nei confronti delle minoranze. L’indagine analizza diversi casi, come quello di Brisha Borden che, incensurata, ruba oggetti per un valore di 80 dollari, a confronto con quello di Vernon Prater, pluripregiudicato, che ruba oggetti per un valore di 86 dollari. Borden viene valutata ad alto rischio di recidiva, Prater a basso rischio. Due anni dopo Prater è in carcere con una condanna di 8 anni, Borden non ha avuto altri problemi con la giustizia. Borden è una donna di colore, Prater è un maschio bianco. Secondo lo studio di ProPublica, Compas evidenzia significative disparità razziali, commettendo errori a sfavore dei neri, etichettandoli come possibili recidivi nel doppio dei casi rispetto ai bianchi.

Northpointe, ovviamente, contesta lo studio di ProPublica, ma non ha mai rivelato il codice del software. Quello che si sa è l’insieme delle domande utilizzate per fornire informazioni al sistema. Il software utilizza parametri quali la presenza di parenti già condannati, amici o vicini che si drogano, le volte che si litiga a scuola, e così via.

Prevedere i “criminali”

I criminologi da sempre cercano di prevedere quali persone possono diventare criminali, quali criminali sono a rischio di recidiva. Gli strumenti di valutazione del rischio sono considerati essenziali per ridurre la popolazione carceraria. Nel 2010 Bernard Harcourt sostiene, invece, che tali strumenti non fanno altro che aggravare lo squilibrio razziale già presente nella popolazione carceraria. Il problema non si risolve riducendo i tempi di carcerazione (nel caso in cui si stabilisce un basso rischio di recidiva) ma rivedendo i criteri di incarcerazione (chi deve andare dentro).

Ma il mito dell’efficienza tecnologica rimette tutto in gioco. I software di predizione si moltiplicano.

Leggi anche >> Paura, controllo, sorveglianza digitale: benvenuti nell’era della società pre-crimine

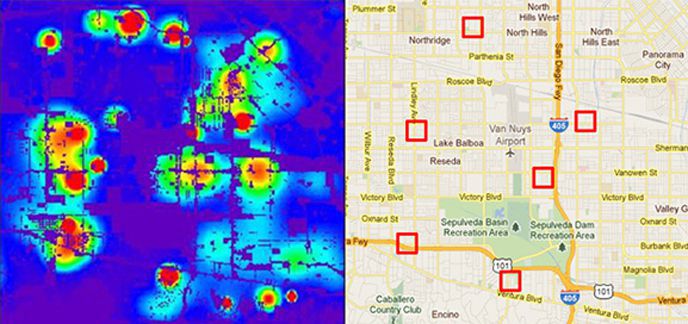

Nel 2009 Daniell Neill e Will Gorr realizzano uno strumento software di previsione del crimine denominato CrimeScan. CrimeScan realizza una heat map del crimine, prevedendo in quali luoghi è più probabile che si realizzino dei reati, così consentendo una migliore allocazione delle risorse di polizia. L’idea alla base è che il crimine violento è come una malattia trasmissibile, che si concentra in determinati luoghi. E che i crimini minori sono “precursori” dei crimini maggiori. Così gli algoritmi di previsione dei reati utilizzano una vasta gamma di indicatori, tra cui le segnalazioni di crimini minori, atti di vandalismo, condotte antisociali, chiamate al numero di emergenza, ecc... L’idea è di tracciare le scintille prima che si appicchino gli incendi.

I software di previsione del crimine sono molti. PredPol, creato dagli scienziati dell’UCLA lavorando a stretto contatto con la polizia di Los Angeles, è usato da oltre 60 dipartimenti di polizia negli USA. Anche qui le dichiarazioni dei programmatori sull’efficienza del software (“due volte più accurato degli analisti umani”) non sono mai state verificate da studi indipendenti. Il crimine, secondo gli estimatori dei software di previsione, funziona come i terremoti, si muove lungo delle faglie, derivano da struttura specifiche, come una scuola, un parcheggio, un centro commerciale, e si spostano, come le scosse di assestamento.

Uno studio della RAND Corporation (Evaluation of the Shreveport Predictive Policing Experiment) conclude che l’uso di tali software non diminuisce significativamente il crimine. Anche se gli agenti percepiscono benefici dall’uso del programma. Il problema è che tali strumenti si prestano ad alimentare i pregiudizi, a influenzare cosa stai per fare. Se il sistema ti dice che in un certo luogo avverrà un furto d’auto, ciò influenza la tua visione della situazione quanto più ritieni il sistema efficace. La tua mente si appresta a “vedere” ciò che il sistema ha “predetto”, giustificando e portando a coerenza elementi che non si adattano alla previsione.

Inoltre, le condotte antisociali, i crimini minori sono radicati negli ambienti più poveri. Distribuire le risorse di polizia per contrastare i comportamenti antisociali determina un ovvio irrigidimento nei confronti dei loro perpetratori. Se la polizia pattuglia costantemente una determinata zona, finirà per incappare in una coppia di ragazzini che si ubriacano per strada, e interverranno. Questo determinerà nuovi dati da inserire nel sistema che porterà nuove pattuglie nelle zona. E così via, in una spirale infinita. L’intervento della polizia giustifica l’invio di altra polizia, nelle zone dove sono segregati i poveri e le minoranze.

È l’idea della “tolleranza zero”, della teoria delle “finestre rotte”. La teoria di George Killin afferma che controllare i quartieri reprimendo anche i più piccoli reati, compreso atti vandalici e deturpazione del territorio, contribuisce a creare un clima di ordine e legalità e riduce il rischio di crimini più gravi.

Si tratta, in realtà, di un mito più volte contestato. La decadenza fisica e sociale, il disordine sociale, non portano a un aumento dei crimini, è il declino economico che lo fa. La riduzione del crimine dipende dal miglioramento delle condizioni economiche (Breaking away from broken windows: Baltimore neighborhoods and the nationwide fight against crime, grime, fear, and decline, Ralph B. Taylor). Insomma, la relazione tra disordine e crimine è piuttosto modesta, ed è in gran parte un artefatto di forze sociali più importanti.

Ma l’utilizzo dei dati sui crimini antisociali è molto appagante. Un ubriaco fa i suoi bisogni ogni giorno sullo stesso muro, un drogato si accascia sempre sulla stessa panchina, mentre un ladro d’auto cambia zona ogni notte, per non essere beccato. Un modello predittivo focalizzato sui crimini maggiori produrrebbe una mappa di punti sparsi, assolutamente inutile, mentre un modello focalizzato sui crimini minori e i comportamenti antisociali produce una fantastica mappa che punta a specifici quartieri. Quelli più poveri. Una mappa del genere non fa altro che “tracciare” la povertà, così consolidando l’idea che il crimine è correlato ai poveri. Una visione che è ben felice di appoggiare la parte più ricca della società che, ovviamente, è quella che ha maggior peso quando si tratta di scegliere le politiche criminali.

E i crimini dei ricchi? I crimini dei colletti bianchi sono quelli che devastano la società sottraendo milioni in risorse e impoverendo l’intero paese. Eppure non sono localizzabili tramite mappe, non sono tracciabili, e spesso sono difficili da perseguire e reprimere. Occorrono forze di polizia specializzate, istruite, molto costose. Molte volte i crimini finanziari sono tollerati se causano danni minimi.

Il modello predittivo non fa altro che automatizzare quello che la polizia fa da sempre, guardare principalmente nella direzione dei poveri. L’utilizzo di processi decisionali algoritmici amplifica l’impatto sulle persone, rendendolo nel contempo un qualcosa di incontestabile, perché, si sa, se una decisione viene dall’analisi di una grande quantità di dati (Big Data) non può che essere giusta.

Leggi anche >> Il capitalismo della sorveglianza

Poco più che un umano

Nel 2018 Julia Dressel e Hany Farid del Dartmouth College dimostrano, in un nuovo studio (The accuracy, fairness, and limits of predicting recidivism), che Compas non è migliore di volontari scelti da Internet nel prevedere il rischio di recidiva di un individuo.

Secondo Dressel il presupposto implicito di questo e di altri sistemi di intelligenza artificiale, cioè che le previsioni di un algoritmo, essendo basate su grandi quantità di dati (Big Data), siano intrinsecamente migliori di quelle umane, semplicemente non è dimostrato. Ma non esiste nessuna ricerca in materia, per cui lei e Farid reclutano 400 volontari online, chiedendo loro, sulla base di solo 7 informazioni, di indovinare se l’imputato avrebbe commesso un nuovo crimine entro due anni. In media i volontari hanno dato la risposta giusta nel 63% dei casi, la precisione aumenta al 67% se le risposte vengono date per gruppi di persone. Compas ha una precisione del 65%.

Quindi Compas ha un’accuratezza di poco superiore a un singolo individuo e inferiore ad un gruppo. E allora, a che serve un software come Compas?

Il punto, sostiene Farid, non è se il software funziona o non funziona, ma che prima di tutto bisogna capirli, bisogna sapere esattamente come funzionano e dimostrare la loro efficacia prima di utilizzarli.

Invece, stiamo consegnando progressivamente la gestione di ampi settori della società a scatole chiuse delle quali non sappiamo assolutamente nulla. Fidandoci ciecamente di quello che ci dicono solo perché crediamo che una decisione basata su un grande quantitativo di dati sia migliore. Il punto è sempre quello lì. Crediamo ciecamente nei Big Data, così come l’NSA.

Dentro la scatola nera

L'intelligenza artificiale gioca un ruolo sempre più importante in un numero sempre maggiore di decisioni che riguardano la vita quotidiana. Gli algoritmi decidono chi deve essere assunto, chi deve ottenere un prestito, chi una forma di assistenza sociale. Gli algoritmi danno un punteggio agli insegnanti così di fatto stabilendo chi va licenziato.

Leggi anche >> Gli algoritmi e i “mostri” della tecnologia

Ma gran parte del software è proprietario, e quindi non c’è che scarsa trasparenza sul loro funzionamento, su quali sono i criteri di programmazione. E man mano che l’apprendimento automatico (machine learning) diverrà più sofisticato, diventerà sempre più difficile spiegare le scelte del software, anche da parte degli stessi ingegneri che l’hanno creato. Come può un avvocato chiamare a deporre il programmatore del software per contestarne la valutazione, se questi non può spiegare il processo decisionale? Come può un giudice valutare la validità della decisione algoritmica se non riesce a capire il processo decisionale? Come può un tribunale sapere quanta parte hanno avuto fattori socioeconomici a stabilire l’elevato rischio di recidiva dell’imputato se il software è segreto?

Un giudice non avrebbe altra scelta che abdicare a parte del suo compito a favore di un software le cui motivazioni sono semplicemente inconoscibili.

Un processo decisionale automatizzato poco trasparente è un processo con scarsa responsabilità. Chi risponde se il software sbaglia? Siamo pronti a mettere in discussione le “decisioni” del software? Oppure siamo sempre più propensi a considerare l’elaborazione del Big Data una forma di “autorità” incontestabile?

L’opinione pubblica non ha la possibilità di controllare l’uso di tali sistemi né di contestarne le decisioni. E i dati e le logiche che governano gli algoritmi spesso sono sconosciuti anche a coloro che li applicano, per non parlare dei cittadini che ne subiscono gli effetti. Possiamo credere che una laurea in ingegneria sia sufficiente per prendere decisioni complesse in ambiti come la giustizia penale?

È comprensibile che Northpointe debba proteggere i suoi assett (il software), ma occorre domandarsi quanto possiamo fidarci di una azienda che opera per profitto nella gestione dei sistemi complessi della società. Gli algoritmi hanno il potenziale per migliorare drasticamente l’efficienza delle decisioni, ma occorre essere guardinghi e approfondire le complesse questioni etiche che il loro uso sollecita.

Credo che le persone cambino

Un operaio edile ruba un tosaerba e altri strumenti, che intendeva rivendere. Viene arrestato e condannato. Nel corso del processo è soggetto alla valutazione di Compas. L’avvocato chiama a testimoniare il creatore dell’algoritmo. Brennan spiega che il suo obiettivo era ridurre il crimine, non la punizione: “Col passare del tempo mi sono reso conto che nei tribunali vengono prese così tante decisioni. Non mi piace l’idea che Compas sia l’unico elemento sul quale basare una condanna”.

Dopo la testimonianza di Brennan, il giudice riduce la condanna da due anni di prigione a 18 mesi: “Se non avessi usato il COMPAS, probabilmente avrei dato un anno e sei mesi", ha chiarito il giudice.

L’imputato ha commentato sostenendo che Compas non aveva tenuto conto di tutti i cambiamenti che stavano avvenendo nella sua vita, la lotta contro la dipendenza dalla droga, la conversione al cristianesimo, l’impegno a essere più disponibile per il figlio: “Non che io sia innocente, ma credo che le persone cambino”.

Immagine via harvardlawreview.org