Regolamentare Internet. Perché le proposte avanzate dalla politica devono farci paura

20 min letturaInternet, liberaci dal male. O meglio: liberateci dal male di Internet

È un grido collettivo, ormai, un coro che si leva da ogni parte del mondo: qualcuno ci salvi dai "lati oscuri" della tecnologia e subito! Dai troll, dai bot e dalle "fake news" che "distruggono la democrazia"; dai social media divenuti megafoni dei terroristi, dei neofascisti, dei cyberbulli, di chi odia le donne, di chi perpetra e diffonde minacce e violenze di ogni genere; dall'automazione che ci polarizza e costringe a litigare (prima di rubarci il lavoro); dalle bolle ideologiche rinforzate a ogni "refresh" del News Feed di Facebook; dalla "dipendenza" da engagement; dalle piattaforme digitali che, "rubando" i contenuti dalle buone vecchie testate tradizionali, uccidono il giornalismo e la cultura.

Tutto il male che combattiamo dall'alba dell'umanità nel mondo fisico, improvvisamente – dopo tre anni passati ad argomentare (senza prove) che Brexit, Trump, il risorgere dei nazionalismi, il trionfo dei "populismi", la fine della fiducia nelle istituzioni e nei media, l'egemonia culturale del complottismo e dell'ignoranza siano dovuti al nostro essere sempre connessi – nel mondo online non dovrebbe esistere più. E dunque dobbiamo "regolamentare Internet", come sostengono ormai indifferentemente Theresa May e Mark Zuckerberg, governi democratici e non e "guru" di Silicon Valley pentiti di avere magnificato le resistibili glorie dell'utopia tecnologica solo per poi accorgersi – una volta intascato il proprio dividendo – che la Rete, proprio come ogni altra tecnologia, è ambivalente e complessa.

Online companies must start taking responsibility for their platforms, and help restore public trust in this technology.

We are putting a legal duty of care on internet companies to keep people safe.#OnlineSafety pic.twitter.com/6EDsaY3Ofr

— Theresa May (@theresa_may) April 8, 2019

L'assunto sembra essere che finora, invece, i media digitali fossero una sorta di far west anarcoide in cui chiunque è costretto a farsi giustizia da sé, le forze dell'ordine brancolano nel buio come sceriffi a caccia di banditi tra un saloon e l'altro, e c'è sempre – per citare un classico del genere, Lucky Luke – un Dalton capace di farla franca perché lì, nell'attività criminosa a cui si è dedicato proprio grazie alle nuove tecnologie, le maglie dello stato di diritto non arriverebbero.

"L'era dell'autoregolamentazione dei social media è finita", riassume la premier britannica May, presentando il progetto più ambizioso finora mai proposto per dare un diverso quadro di regole a qualunque maleficio prodotto dalla Rete. Cioè tutto quanto rientri nel generico ombrello degli online harms di cui si occupa il White Paper presentato al Parlamento UK nei giorni scorsi dal Segretario di Stato per il Digitale, la Cultura, i Media e lo Sport, Jeremy Wright, e dal Ministro dell'Interno, Sajid Javid.

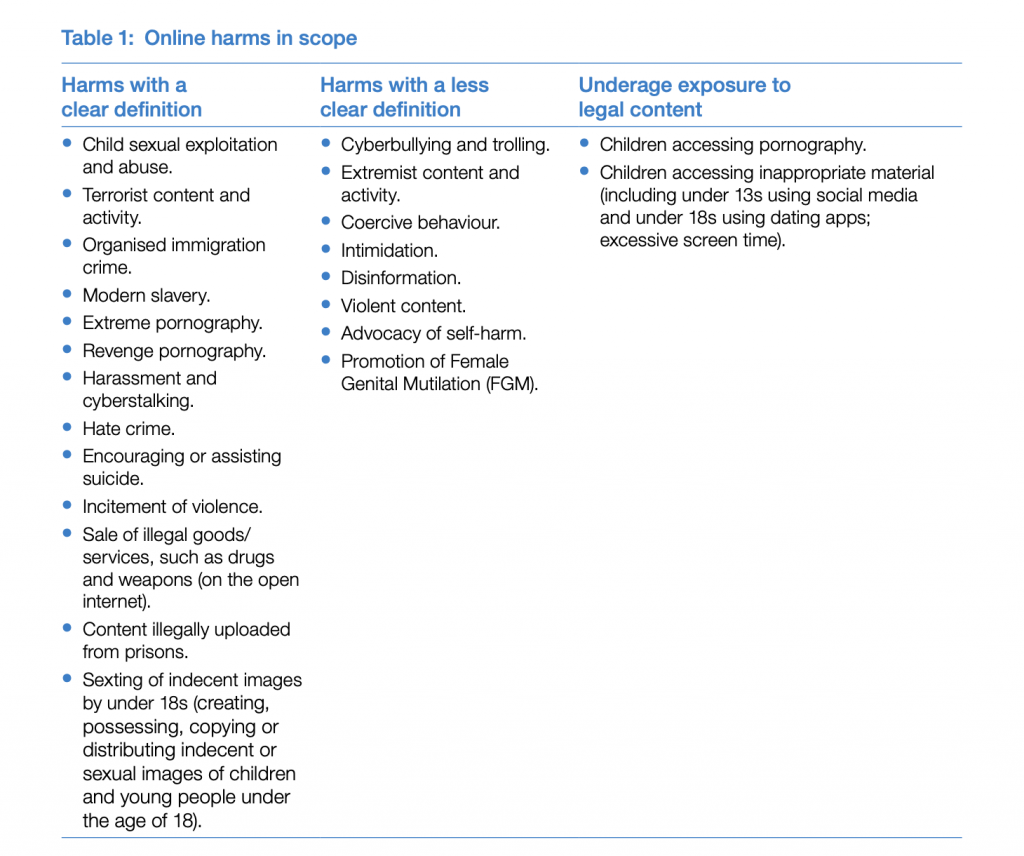

Centodue pagine densissime, in cui si propone un framework per affrontare in modo sistematico un ventaglio ampissimo di problemi: uso dei social media per promuovere la cultura delle gang criminali, sfidarsi e provocare violenze; diffusione, anche in live streaming, di contenuti terroristici; sfruttamento sessuale dei minori; vendita di eroina, morfina e altre droghe online; molestie da utenti anonimi; autolesionismo e istigazione al suicidio online; condivisione di immagini a sfondo sessuale di minori; cyberbullismo; disinformazione e manipolazione online; abusi a personaggi pubblici online (ma non di personaggi pubblici); online addiction by design.

Insomma, tutto. E la lista è solo "iniziale", e "né fissa né esaustiva".

È un passaggio epocale, che va raccontato con attenzione e massima cura dei dettagli. Perché è lì che si cela il diavolo che costringe a guardare con preoccupazione a una svolta nel rapporto tra tecnologia e politica che, peraltro, i legislatori e i media a ogni latitudine propongono con un'insistenza sorda a ogni critica, e nutrita dal fuoco dell'indignazione e dei panici morali, molto più che da dati e studi che delimitino precisamente entità e impatto dei fenomeni che si vogliono combattere.

Una svolta, poi, che non parte certo dagli UK, e di certo non si fermerà ai confini della Gran Bretagna. Da un lato, perché è obiettivo dichiarato del governo May porsi “a guida degli sforzi internazionali, attraverso un approccio coerente, proporzionato ed efficace" che riflette un "impegno per una Rete Internet libera, aperta e sicura”, su cui, come vedremo, c'è molto da dubitare.

Dall'altro, perché ai quattro angoli del globo la ratio adottata per affrontare tutti questi temi, scottanti e difficili, di tech-policy, è la stessa: dall'Australia al Canada, dall'Unione Europea a suoi singoli stati membri (Francia e Germania in testa), passando per stati meno e per nulla democratici (Singapore, Russia, Cina), l'idea è reprimere ed eliminare non solo gli illeciti, ma anche contenuti leciti di cui però vogliamo eliminare traccia dal mondo. Almeno da quello digitale. E di farlo soprattutto attraverso strumenti tecnologici, in particolare attraverso algoritmi, gli unici che consentirebbero – secondo questa visione, consentiranno – di estirpare le erbacce prodotte dalle libertà in Rete abbastanza rapidamente da estinguere il fuoco purificatore che arde nelle redazioni e nelle stanze governative.

Regolamentare Internet per proteggere i diritti dei cittadini, dunque, è un obiettivo nobile, molto probabilmente per tanti versi necessario. Farlo secondo il modello che stiamo per descrivere, invece, lo è molto meno. Vediamo perché, partendo proprio dal White Paper del governo britannico.

Il posto più sicuro al mondo da cui connettersi a Internet

Cosa si dice? Per prima cosa, che l'obiettivo di fondo è rendere gli UK "il posto più sicuro al mondo per andare online", creando un “ambizioso piano per un nuovo sistema di responsabilità (accountability) e controllo (oversight) per le compagnie tecnologiche, andando molto oltre l’autoregolamentazione”.

Si tratta insomma di "tenere al sicuro i nostri figli", dice la premier May, e di farlo introducendo un nuovo duty of care per le piattaforme digitali: ovvero, appunto, il dovere di curarsi davvero della sicurezza dei propri utenti – e da tutti i punti di vista.

L'intenzione del governo è di smetterla a giocare a guardie e ladri con i colossi privati del digitale inseguendoli scandalo per scandalo, e instaurare con loro un rapporto tutto nuovo, più virtuoso e che promuova una logica di auto-miglioramento trasparente e cooperazione costante nelle piattaforme, spronandole (e costringendole) a dotarsi di strumenti sempre all’avanguardia all’evolvere di qualunque maleficio la Rete presenti alla società.

Da questo punto di vista, la centralità del duty of care nell'impianto del White Paper è significativa. Nell'annoso dibattito tra chi sostiene che le piattaforme digitali siano media companies (e dunque editori a tutto tondo) e chi invece le reputa technology companies (cioè soggetti tecnologici neutri rispetto ai valori e ai contenuti che veicolano), il governo britannico cerca una faticosa via mediana.

Equiparare le piattaforme a editori tradizionali, si legge infatti, "non sarebbe proporzionato": "Un approccio simile costringerebbe le aziende a controllare ogni singolo contenuto prima dell’upload per verificare sia legale, con implicazioni per la libertà di espressione, e sarebbe difficile riconciliarlo con piattaforme che ospitano grandi quantità di contenuti".

È il problema dell'incentivo, potentissimo, ad adottare sistemi di filtraggio automatico e preventivo dei contenuti che si discute da tempo in merito, per esempio, alla Direttiva Copyright appena approvata anche dal Consiglio dell'Unione Europea e alla normativa sul contrasto del terrorismo in Rete sempre a livello UE e comune, come vedremo, alla gran parte dei propositi di riforma delle regole in Rete più "ambiziosi".

Nemmeno restare all'estremo opposto tuttavia è una soluzione, dice il governo UK. Sotto il regime di responsabilità corrente (dovuto alla direttiva UE sull'e-commerce) infatti le piattaforme non sono ritenute responsabili legalmente dei contenuti illeciti postati dagli utenti finché non vengano, tramite segnalazioni, a reale conoscenza che esistono, oppure si dimostri che le aziende erano a conoscenza di fatti che rendevano manifesto fossero illeciti, e non hanno agito “rapidamente” per rimuoverli o impedirvi l’accesso. È questo schema, sostiene May, a non avere funzionato.

E allora ecco il duty of care, che dovrebbe segnare il passaggio da un approccio reattivo alla gestione dei contenuti online (si rimuovono previa segnalazione) a un approccio proattivo in cui sono le piattaforme ad assumersi alcune responsabilità circa i contenuti dei propri utenti, cercando di prevenire di trovarsi nella situazione di ricevere notifiche per la presenza di illeciti.

Idealmente, per contenuti di natura terroristica e per abusi su minori ciò significa sistemi automatici e umani di riconoscimento che impediscano qualunque circolazione, o addirittura la pubblicazione, di ogni contenuto illecito o che possa arrecare un danno all’utente. Misure precise, non specificate ma coerenti con l’impianto, devono anche essere prese in tema di livestreaming di contenuti terroristici. Infine, anche i motori di ricerca non dovranno restituire contenuti che conducano ad attività terroristica – che non potranno nemmeno figurare tra i suggerimenti algoritmici delle piattaforme.

Per tutti gli altri mali da Internet, invece, dovrà intervenire un'autorità apposita indipendente – nuova di zecca oppure riadattata da quelle esistenti – a stabilire precisi obblighi per le compagnie tecnologiche attraverso una serie di "codici" che definiscano le prassi richieste per soddisfare il "duty of care" nei confronti dei propri utenti.

A grandi linee, parliamo di

— Safety by design (qualunque cosa significhi) dei propri prodotti e servizi.

— Termini di utilizzo molto più chiari e a comprensione guidata.

— Processi di moderazione e segnalazione dei contenuti più efficaci e trasparenti.

— Misure per contrastare i danni online “rapidamente”.

— Supporto adeguato agli utenti vittima di quei danni.

Ma la questione appare subito più sfumata e problematica: nel White Paper si parla di “identificazione proattiva” anche dei contenuti “non necessariamente illegali, ma che possono direttamente o indirettamente causare danno agli utenti — per esempio, in caso di bullismo o di materiale offensivo”: significa che servono filtri anche contro il cyberbullismo?

Ancora, le aziende interessate dal nuovo approccio regolamentare dovranno assicurarsi che gli utenti non ricevano mai suggerimenti verso contenuti “di odio o inappropriati”. Anche qui, naturalmente, ci si chiede come sia possibile, anche implementando strumenti di rimozione automatica, e pericolosamente vaghi.

Che il tutto sia terribilmente rischioso è confermato dal fatto che vengano chieste misure “proporzionate e proattive” per minimizzare la diffusione di disinformazione e informazione “dannosa” (harmful disinformation), per promuovere “fonti autorevoli” (e chi decide quali sono?) e diversificare le notizie in modo che provengano algoritmicamente dall’intero spettro ideologico (assumendo, contro sempre più evidenze scientifiche, che le camere dell'eco online diminuiscano il pluralismo informativo).

Certo, il White Paper precisa da subito che "il focus è proteggere gli utenti dai danni, non giudicare ciò che è vero o meno", ma quando si arriva a ipotizzare un "obbligo di qualità per le news" sui social si ha l'impressione che sia mero wishful thinking o, nella fortunata espressione di Meredith Whittaker di AI Now, ethics theater.

Proprio come quando, per tutto il documento, si sostiene di avere come prima preoccupazione il rispetto di privacy e libertà di espressione in Rete, senza mai dettagliare in alcun singolo aspetto come si dovrebbero proteggere davvero, questi fondamentali diritti, dalle conseguenze logiche dell'approccio usato.

Per esempio, l'autorità deputata a tradurre in regole vere e proprie l'impianto del White Paper potrà comminare “ingenti multe”, anche intervenendo sul modello di business delle aziende in violazione. Potrà perfino imporre il blocco a livello di ISP di un sito o servizio in ripetuta e plateale violazione, anche se solo come ultima ratio. Anche qui, gli estensori si affannano a precisare che eventuali blocchi dovranno avvenire nel rispetto della Convenzione Europea sui diritti umani, ma non si capisce quale sarebbe la garanzia che ciò poi accada davvero.

Ancora, l'autorità potrà anche “imporre la responsabilità dei singoli membri del senior management” delle piattaforme, sia a livello civile che penale, per non avere agito per rimuovere il danno. Il White Paper dice di ispirarsi ai principi di proporzionalità e valutazione del rischio (maggiori le dimensioni e il fatturato, maggiori i rischi a cui sono esposti gli utenti, più severa l'applicazione), secondo il criterio del "ragionevolmente fattibile" (reasonably practicable), ma intanto si prevede espressamente che l'ambito riguardi indistintamente social network, motori di ricerca, servizi di messaggistica, forum di discussione, app di dating, siti di recensioni: tutto.

Meno controversi altri poteri in capo all'autorità: richiedere alle aziende un rapporto sulla trasparenza su base annuale, dettagliando le iniziative prese, la diffusione esatta dei contenuti harmful (qualunque cosa significhi esattamente) sulla sua piattaforma e potenzialmente anche l’impatto degli algoritmi di selezione dei contenuti; e chiedere alle piattaforme di “dare ai ricercatori maggiore accessi ai loro dati”. Una questione cruciale su cui le piattaforme hanno finora dato risposte davvero insoddisfacenti.

Ma è l'ampiezza dello scopo a comportare, forse necessariamente, semplificazioni e banalizzazioni irresponsabili. Per esempio, il "trolling" viene in un passaggio considerato all'interno del cyberbullismo – criminalizzando così una prassi fastidiosa, certo, ma di per sé innocua come provocare per il gusto di farlo. O quando si scrive, nero su bianco, che “il governo lavorerà con le forze dell’ordine per accertarsi che i poteri di cui dispongono siano adatti ad affrontare gli abusi coperti da anonimato online” – proseguendo nella lunga tradizione dei governi britannici di attaccare anonimato e crittografia.

"7.43 Cyberbullying, including trolling, is unacceptable." Anyone have an accepted definition of trolling? For sure, the White Paper doesn't attempt one. #OnlineSafety

— Graham Smith (@cyberleagle) April 8, 2019

Le regole contro i danni online rischiano di causare ulteriori danni online

Non è un caso, dunque, che l'ambizioso piano del governo May sia stato bocciato dalla quasi totalità della community che si occupa di diritti digitali.

Secondo gli studiosi del Carnegie UK Trust, Lorna Woods e William Perrin, per esempio, il White Paper sta travisando il concetto di duty of care così come inteso dalla tradizione legislativa britannica. Questo "fornisce a un individuo al diritto a una ricompensa" nel caso di un torto subito per negligenza, ma "i torti in generale non sono fatti per essere punitivi o imporre standard di regolamentazione", si legge. L'esatto opposto del progetto May, che infatti dice chiaro e tondo che si tratta proprio di uno schema di regole la cui violazione comporterebbe "severe punizioni" alle compagnie tecnologiche inadempienti.

Open Rights Group invece punta la sua attenzione sul fatto che molto dipenderà dall'implementazione pratica di quei principi, che fortunatamente avverrà solo dopo 12 settimane di consultazione pubblica. Le regole, insomma, potrebbero rivelarsi talmente vaghe da risultare inapplicabili o sostanzialmente inutili a cambiare le cose (nell'applicazione più stringente), oppure al contrario (in caso di interpretazione più estensiva) "cominciare a servire come giustificazione per vaste operazioni di censura su Internet". Lo stesso argomentano, con parole anche più forti, Index on Censorship e Big Brother Watch.

This is an unprecedented attack on freedom of speech that will see internet giants monitoring the communications of billions and censoring lawful speech.

— Big Brother Watch (@bbw1984) April 8, 2019

Critiche simili sono giunte dal Guardian ("troppi passaggi di questo White Paper sembrano un tentativo di trovare soluzioni semplici e riduttive a problemi davvero complessi") e da giornalisti esperti della materia del calibro di Casey Newton ("i nuovi requisiti di moderazione dei contenuti potrebbero rivelarsi inattuabili per tutti fuorché per le piattaforme più grandi, aumentandone ulteriormente il potere e rendendo più difficile alle startup sfidarle") e Jamie Bartlett, filosofo del think tank Demos che ricorda i dati, disperanti, circa le competenze tecnologiche dei legislatori inglesi:

Tech policy is a huge issue, but they don't have time or expertise:

1) 43% of MPs feel they do not personally have the expertise to make sound judgments on tech policy

2) 46% see dealing with the ramifications of new technologies as big of a challenge as dealing with Brexit

— Jamie Bartlett (@JamieJBartlett) April 9, 2019

Molto dipenderà da come si proverà a risolvere una della questioni centrali, ma aperte, che aleggiano su tutto il lavoro del governo UK: come relazionarsi al gap, enorme e trasversale, di evidenze scientifiche sui molteplici temi trattati nel documento. L'idea è promuovere la ricerca contestualmente all'instaurazione del nuovo regime di regole per la Rete, ma buonsenso imporrebbe di disporre di una base di dati ben più solida prima di legiferare, non durante il processo legislativo o addirittura dopo. Di nuovo, un problema che accomuna l'approccio britannico con quello di svariate altre istituzioni in tutto il mondo. Le politiche tecnologiche, per qualche ragione, sembrano potersi sottrarre al vaglio della realtà, e accontentarsi di quello dello scandalismo mediatico.

Altri aspetti critici di fondamentale importanza sono stati sollevati da Privacy International, che ha sottolineato come sarebbe importante prevedere che a dire l'ultima parola sulla liceità di un contenuto sia il potere giudiziario, non quello esecutivo, e che tra i motivi per procedere con cautela su un tema così delicato c'è anche la preoccupazione di rendere i sistemi di moderazione automatica a mezzo algoritmi compatibili con il rispetto dei diritti umani.

Resta il principio di fondo, che lascia perplessi a prescindere dalle interpretazioni: ciò che si chiede a Internet è di essere un luogo più ordinato, sicuro e sano – in Cina si direbbe "armonioso" – della realtà fisica, dando condizioni all'online perfino più stringenti dell'offline, anche quando sono le stesse autorità britanniche ad avere chiesto che i due modi di darsi della realtà fossero regolati dalle stesse norme.

Di nuovo, come è possibile creare e mantenere un ambiente in cui comunicano istantaneamente miliardi di esseri umani al riparo dal male che a quegli esseri umani è connaturato?

La repressione automatica come modello

Ciò che più di tutto spaventa è la fretta con cui legislatori in tutto il mondo, senza troppe distinzioni tra paesi democratici e non, si sono gettati sul cadavere morente della Rete "senza regole" per dare forma al suo erede. Secondo questo progetto, un ambiente regolato in ogni sua parte e che prevede, appunto, l'eliminazione immediata (o quasi) di qualunque contenuto non solo illecito, ma anche semplicemente ritenuto dannoso.

Il White Paper britannico cita come modello la norma tedesca chiamata "NetzDG", che impone a qualunque piattaforma online con più di due milioni di utenti registrati in Germania di rimuovere contenuti “manifestamente illeciti” – per esempio, negazionismo dell’Olocausto o hate speech – entro 24 ore, e gli altri contenuti “illeciti” entro 7 giorni dalla notifica, pena una multa fino a 50 milioni di euro per contenuto non rimosso.

Dimenticandone i limiti già evidenziati dalla cronaca, dice poi esplicitamente che è bene incentivare partnership pubblico-privato per sviluppare strumenti tecnologici per la moderazione automatica di moli ingenti e sempre crescenti di contenuti - quando sappiamo benissimo che gli algoritmi, almeno allo stato attuale, non sono ancora abbastanza artificialmente intelligenti da essere affidabili nel distinguere insulto e satira, o comprendere il contesto in cui è usato un termine potenzialmente da moderare.

Ma la ratio è la stessa in tutto il mondo, sui problemi più svariati. L'idea di responsabilizzare le piattaforme, in un modo o nell'altro, è presente in diversi progetti di legge e testi normativi già approvati negli ultimi mesi – e sempre si accompagna a un potente incentivo, spesso implicito per evitare polemiche in termini di restrizione dei diritti online, all'adozione di "upload filters", cioè di sistemi di filtraggio automatico dei contenuti illeciti o dannosi che ne impediscano non solo la diffusione, ma anche la stessa pubblicazione.

Caso di scuola è la direttiva UE sul copyright, i cui proponenti hanno per mesi e mesi giurato non riguardasse sistemi di filtering, solo per poi ammettere che sarà possibile evitarli solo "finché possibile" (la Germania), o che anzi saranno obbligatori (Francia). Nelle parole del Commissario UE, Gunther Oettiger: «Per come stanno le cose, gli upload filters non possono essere completamente evitati».

Stessa logica anche per le nuove norme UE in materia di contrasto al terrorismo, che – nonostante l'opposizione congiunta di tre Special Rapporteur ONU e dell'Agenzia UE per i diritti fondamentali – prevedono l'obbligo di rimozione dei contenuti entro un'ora dalla ricezione della segnalazione.

Difficile giustificare questa foga censoria quando, come ricorda sempre l'ONU,

"il diritto alla libertà di espressione si estende "non solo a "informazioni" e "idee" con cui siamo d'accordo, o riteniamo inoffensive o meritevoli di indifferenza, ma anche a quelle che offendono, scioccano e disturbano lo Stato o qualunque fascia della popolazione".

Inoltre, come dichiarato da Damian Tambini della LSE al Festival Internazionale del Giornalismo di Perugia da poco conclusosi, i governi non dovrebbero solo proteggere la libertà di espressione: dovrebbero promuoverla, incentivarla - anche e soprattutto nei colossi privati che oramai la monopolizzano.

Questi soggetti, invece, secondo il modello che li costringe alla "repressione automatica" dei contenuti "dannosi" vengono mutati, a forza, in volenterosi carnefici di ogni illecito, e insieme (questo è il problema) di qualunque contenuto possa anche solo lontanamente causare loro sanzioni pecuniarie a ripetizione, quando non addirittura questioni di rilevanza penale con la giustizia per il proprio senior management.

“Governments not only don’t have to censor speech, they also have to take measures to promote freedom of speech and ensure that private companies promote freedom of speech." @damiantambini #ijf19

🎥 Live & On-Demand: https://t.co/s2XKqVChgo pic.twitter.com/f3zsF8IX99

— journalism festival (@journalismfest) April 5, 2019

A Perugia del resto si è più volte detto che, se l'obiettivo è rimuovere senza censurare, la moderazione automatica non è la risposta. Anzi, è la soluzione perfetta per rimuovere anche il materiale che sarebbe invece utile a documentare violazioni dei diritti umani in scenari di guerra.

“Everything is getting lost: through machine learning used to detect terrorism content, without a single human review, social media are destroying a huge amount of the Syrian history and evidence collected by citizen journalists.” @Hadi_alkhatib #ijf19 pic.twitter.com/QoZfHmekKv

— journalism festival (@journalismfest) April 6, 2019

E sta già accadendo ripetutamente, con il sito Archive.org bersagliato solo nelle ultime settimane da centinaia di richieste a livello UE di rimozione di materiale ritenuto falsamente di natura terroristica. Quando si rischierà, come secondo la proposta in esame, una multa fino al 4% del proprio fatturato per non aver comunque rimosso i contenuti segnalati entro un'ora, casi di questo tipo si moltiplicheranno, con ogni probabilità, senza fine.

Le buone ragioni per procedere con estrema prudenza, insomma, ci sarebbero tutte. Ma non paiono interessare a chi legifera.

Il livestream del massacro islamofobo di Christchurch in Nuova Zelanda ha portato per esempio il governo australiano a proporre e approvare – tutto entro pochi giorni e senza adeguato dibattito nelle sedi parlamentari – una norma che introduce il reato di ospitare e non rimuovere "rapidamente" materiale definito "violento ripugnante". E non serve promuoverne la diffusione: basta essere "irresponsabili" (reckless) nell'identificare e fornire accesso a quei contenuti.

Certo, il materiale dovrà essere oggetto di segnalazione da una commissione apposita, ma il problema è che si assume che l'azienda si trovi accusata di essere "irresponsabile" fin dal momento in cui viene spiccata la segnalazione – o addirittura, potrà essere accusabile anche in assenza di notifica. Quando arriva l'avviso di un illecito, è già tardi.

A dire: l'unico modo che hanno le piattaforme e i provider per evitare guai è, secondo quanto riporta il Nieman Lab, adoperare sistemi di deep packet inspection, che consentono di analizzare tutto il traffico da loro gestito, così da non lasciarsi sfuggire (idealmente) nulla. O almeno, a questo sembra alludere l'Attorney General australiano quando scrive che si immagina "il tracciamento di eventi che si stanno svolgendo in tempo reale", così da "minimizzare" il danno prodotto da situazioni come quella di Christchurch.

Per le sanzioni, si parla di multe milionarie (fino al 10% del fatturato) e pene fino a tre anni di carcere per i responsabili coinvolti.

Anche le critiche hanno lo stesso segno di quelle rivolte al progetto UK, sia dall'ONU che dal GNI, senza tuttavia sortire alcun effetto.

E mentre negli USA e in Canada si parla di regolamentare i social media, cambiare il regime di responsabilità legale a cui sono sottoposti e dunque, di nuovo, di fine dell'era dell'autoregolamentazione (Nancy Pelosi), è in altri paesi europei che si sta percorrendo la stessa pericolosa china repressiva.

In Francia, il presidente Emmanuel Macron ha chiesto e ottenuto, lo scorso novembre, l'approvazione di una norma "anti-fake news" per rimuovere notizie false e perfino bloccare i siti che le ospitano, pena una sanzione fino a 75 mila euro e un anno di carcere per chiunque la violi.

Gli aspetti problematici sono sempre gli stessi: rapidità e arbitrarietà delle decisioni. Qui un giudice sarà costretto a esprimersi su un contenuto segnalato entro 48 ore. Ma, si chiede Alexandre Alaphilippe dell'EU DisinfoLab, è normale sia lui da solo, senza l'aiuto di alcun professionista dell'informazione, a stabilire se una notizia è vera o falsa?

In France according to anti-fake news law, says @AAlaphilippe, judges bear the responsibility of telling true from false by themselves. Instead, they should be judging content previously scrutinized by journalists — and then deliberate.

Good intentions, wrong process. #Ijf19

— Fabio Chiusi (@fabiochiusi) April 5, 2019

Che poi la norma abbia esiti paradossali è dimostrato dal fatto che il primo a patirne le conseguenze è stato il governo dello stesso Macron, che si è visto rigettare una campagna politica per portare gli elettori al voto alle prossime Europee su Twitter proprio sulla base della legge da lui voluta. Non sapendo come obbedirvi alla lettera, l'azienda ha infatti preferito evitare possibili problemi, e rifiutare qualunque campagna di natura politica fino a nuovo ordine.

L'ennesima dimostrazione, se mai ce ne fosse bisogno, che per le aziende private il profitto viene (legittimamente, peraltro) prima di qualunque raffinata considerazione sui diritti e la democrazia. E che se le leggi sono pensate male, sono questi ultimi – non le grandi aziende e il loro profitto – a rimetterci.

L'aspetto più problematico di questa impostazione di fondo alla regolamentazione di Internet resta però l'assottigliarsi continuo e implacabile del confine tra ciò che è considerato lecito reprimere in paesi democratici e regimi molto meno democratici.

Il modello più puro ed estremo di questa visione, naturalmente, è quello cinese: una società il cui principale desiderio propagandistico è l'"armonia", e in cui quella promessa di beatitudine si garantisce algoritmicamente, tecnologicamente. Rendendo ogni contenuto di ogni cittadino sempre soggetto a controllo e censura. Computando e penalizzando comportamenti dannosi (fumare, attraversare col rosso, mangiare troppo al fast food), ma leciti. E, ogni volta i conti non tornino, sfoderando la parola magica: "Intelligenza artificiale". La buzzword invocata ogni volta il potere si trovi di fronte alla necessità di giustificare interventi dalle conseguenze repressive, benefici (forse) per far quadrare qualche piano pluriennale, ma sempre al prezzo di una diminuzione dei diritti individuali.

Qui, in contesti non democratici, appare evidente come questi impianti normativi siano poco più di una scusa per identificare dissenso e crimine, reprimere la libera espressione, controllare e indirizzare l'opinione pubblica, e incarcerare e punire con sanzioni pecuniarie chiunque osi alzare una voce contraria. È avvenuto a vario titolo in Russia, in Malesia, a Singapore. Sempre sotto l'egida (ipocrita) della "lotta alle fake news". Che per il Cremlino sono equiparabili a mancanza di rispetto verso lo Stato o chi lo rappresenta, a Singapore si estendono fino all'arrecare pregiudizio alle relazioni internazionali del governo, e in Malesia sono già state utilizzate per ridurre al silenzio l'opposizione politica.

Trovare le differenze, di sostanza e non di forma, con quanto proposto dal governo di destra in Austria solo pochi giorni fa è impresa da giuristi: qui lo strumento scelto è obbligare le piattaforme a identificare gli utenti, così che ci sia sempre un responsabile per eventuali manifestazioni di hate speech - sempre secondo la logica (fallace) per cui l'anonimato sarebbe un nemico onnipresente da combattere. Ma gli effetti vanno nella stessa direzione.

Questo è quanto sta accadendo, sotto la maschera della retorica delle "regole" che tuttavia rispettano i diritti fondamentali: un avvicinamento progressivo, perfino gioioso, al modello cinese di regolamentazione di Internet. Ovvero, l'esatto opposto di uno sviluppo in armonia con i diritti umani. Sarebbe bene le opinioni pubbliche dei paesi democratici ne fossero consapevoli, e chiedessero di fermarci tutti. Per ragionare di approcci alternativi (Jeff Jarvis ne propone uno, per esempio), raccogliere dati ed evidenze empiriche sui fenomeni che si vogliono regolamentare (conoscere per deliberare, giusto?), formare e informare i decisori politici su tutte queste materie, discuterne in modo realmente democratico con la società civile e nei parlamenti.

E allora, solo allora, mettere mano all'equilibrio delicatissimo che chiamiamo "Rete". Un equilibrio sicuramente imperfetto, come quello attuale, ma che riguarda il presente e il futuro dei diritti essenziali di miliardi di individui nel globo.

Se, come il governo britannico, vogliamo parlare di big picture, questo è quanto c'è in gioco.

Altrimenti continueremo a perderci nei dettagli, senza comprendere lo sfondo. A leggere articoli su articoli sul "fallimento" delle piattaforme digitali a ogni teoria del complotto o bufala all'algoritmico sen sfuggite, senza tuttavia mai capire quale sarebbe il metro per parlare di successo.

Question: what would the threshold be for success? Zero conspiracies/disinformation? Or what % (out of what, exactly)? https://t.co/xyOkR0RMmb

— Fabio Chiusi (@fabiochiusi) April 16, 2019

A tollerare lo Sri Lanka che spegne i social media in concomitanza con la serie coordinata di attentati che ha causato la morte di oltre 250 persone il giorno di Pasqua, prima ancora che contenuti di disinformazione cominciassero a circolare: le piattaforme vengono ritenute responsabili, e punite, per la mera possibilità che vi circolino.

The fake news hysteria lead to the shutdown of social media for the mere possibility of disinformation, making platforms liable for content that doesn’t even exist yet - but it’s ok because social media are evil and kill democracies!

Well done, liberals. https://t.co/dJh9Y7TKzb

— Fabio Chiusi (@fabiochiusi) April 22, 2019

A pensare sia normale ciò accada anche in contesti non emergenziali, come in India per il blocco subito dalla app TikTok, anche qui, per danni (in questo caso, bambini potenzialmente esposti a contenuti pornografici e adescamento sessuale) del tutto ipotetici.

In India, TikTok is also preemptively banned, based on the mere hypothesis of harm (the possibility of children getting exposed to porn and sexual predators).

This is a worrying trend.https://t.co/Bq92AGXf8r

— Fabio Chiusi (@fabiochiusi) April 23, 2019

A sospirare, come la influente opinionista Kara Swisher del New York Times, che se si chiudono i social media perché, solamente esistendo, avrebbero commesso una qualche sorta di pre-crimine, tutto sommato, è comunque un "bene", anche se non si risolvono i problemi di fondo, e anche se è pericoloso e non c'è prova serva davvero nemmeno per soddisfare gli obiettivi immediati che dovrebbero giustificare il blocco.

Del resto, se "distruggono la democrazia" e uccidono le persone – due grandi, indimostrati cavalli di battaglia degli allarmisti – perché non chiuderli?

Particularly striking part of the Swisher column is the line at the end "Shutting social media down in times of crisis isn’t going to work." So we now have numerous commentators cheering governments on for doing things that (a) probably don't work and (2) infringe on human rights

— Rasmus Kleis Nielsen (@rasmus_kleis) April 23, 2019

Di nuovo, e alla luce di tutti questi accadimenti, viene da chiedere: quanto pulita deve essere, Internet, per essere finalmente "regolata"? Quanto male vogliamo decidere sia fisiologico, al suo interno?

L'impressione è che l'unica quota ritenuta accettabile sarebbe quota zero.

Fosse questo il reale obiettivo di chi cerca più o meno nobilmente di regolamentare il web, dovremmo rammentare, prima di procedere, che l'impossibile ricerca della perfezione in un ambiente di discussione democratico è quanto di meno democratico ci possa essere.

Foto in anteprima via Pixabay