Entra in vigore il Digital Services Act, la principale normativa europea che regolamenta il mondo digitale

|

|

Una norma generale per gli attori digitali

Il Digital Services Act (DSA) è la normativa principale che si occuperà di regolamentare l’ambiente digitale, una sorta di costituzione di internet. Si occupa di regolamentare le attività di tutti i soggetti online, in particolare delle grandi piattaforme, adottando obblighi asimmetrici, per cui a soggetti con maggiore “peso” vengono assegnati maggiori oneri. Un aspetto sul quale si concentra è cercare di coniugare le attività online con i diritti fondamentali dei cittadini.

Leggi anche >> Per una regolamentazione delle piattaforme digitali

La proposta della Commissione europea risale al dicembre 2020, anche se occorre dire che la norma si inserisce in un più ampio progetto per la ridefinizione delle regole dell’ambiente digitale, quindi a studi e proposte antecedenti, ad esempio le linee guida presentate dalla Commissione nel gennaio del 2020.

Leggi anche >> Digital Service Act: l’Europa prepara le nuove regole per le piattaforme online

Il 23 aprile 2022 si è raggiunto l’accordo politico sul DSA, a cui ha fatto seguito l’approvazione da parte delle istituzioni europee. Il 27 ottobre il testo è stato pubblicato nella Gazzetta Ufficiale europea, ed è entrato in vigore il 16 novembre 2022. Entro il 17 febbraio 2023 le piattaforme dovranno comunicare alla Commissione i dati dei loro servizi digitali, nello specifico il numero di utenti mensili in base al quale saranno designate le grandi piattaforme (VLOP e VLOSE che saranno soggette ad oneri ulteriori rispetto alle altre piattaforme). Entro il 17 febbraio 2024 l’Unione Europea individuerà i Coordinatori per i Servizi Digitali che hanno funzioni di raccordo e di reclamo. La normativa sarà applicabile 15 mesi dopo l’entrata in vigore, tranne per i VLOP e VLOSE per le quali sarà applicabile 4 mesi dopo la loro designazione.

Il regolamento, che è direttamente applicabile negli Stati, ha lo scopo di contribuire al corretto funzionamento del mercato interno (art. 1), e quindi si parte sempre da una prospettiva economica, con l’idea di una armonizzazione tra i singoli Stati. In questo quadro, il DSA va a ridefinire le regole delle piattaforme online in particolare modificando la direttiva eCommerce (31/2000), principale riferimento per la responsabilità dei fornitori di servizi digitali. Il DSA, però, va oltre la normativa precedente che lasciava troppo spazio all’autoregolamentazione delle piattaforme, imponendo un quadro generale di obblighi la cui attuazione è delegata alle aziende, ma legando tali obblighi a un meccanismo di monitoraggio da parte delle autorità. L’approccio è dato dalla consapevolezza che la concorrenza tra aziende non è sufficiente, ma occorre che i governi stabiliscano un quadro dettagliato nel quale inscrivere le attività commerciali. In questo modo si cerca di ovviare alle difficoltà attuative (spesso solo le aziende sanno realmente come funzionano certe cose) senza lasciare eccessiva discrezionalità. Si presenta con una serie di strumenti di regolamentazione delle procedure insieme a misure di limitazione del rischio sistemico delle piattaforme del web (es. impatto della moderazione dei contenuti, dei sistemi di raccomandazione, della pubblicità programmata, e così via).

Andiamo ad analizzare gli aspetti rilevanti.

Categorie di piattaforme e obblighi

Il DSA si applica (art. 2) ai fornitori di servizi intermediari quindi ai soggetti che offrono servizi della società dell’informazione a richiesta di un destinatario (recipient) il cui luogo di stabilimento si trova nel territorio dell’Unione europea o che è ubicato nell’Unione. È indifferente il luogo di stabilimento del fornitore del servizio (come per il GDPR), per cui si applica sostanzialmente a tutte le aziende che si rivolgono a destinatari presenti nell’Unione.

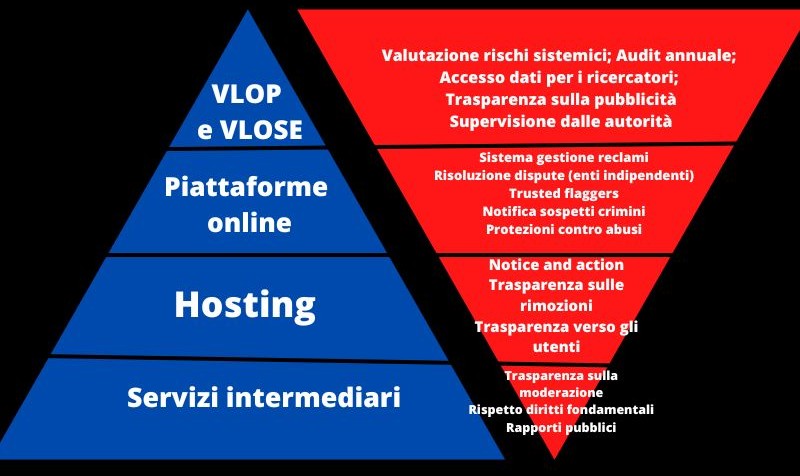

La normativa distingue varie categorie di intermediari in base al tipo, alle dimensioni e alla natura dei loro servizi:

- Servizi di intermediazione (intermediary services)

- Hosting (es. cloud)

- Piattaforme online (es. social media)

- Very large online platform (VLOP) e very large online search engine (VLOSE)

Le grandi piattaforme sono quelle che raggiungono un numero medio di destinatari attivi mensili (utenti/mese) del servizio nell'Unione pari o superiore a 45 milioni. Ad esempio Facebook, Google Search, Amazon, Twitter... Sono i VLOSE e VLOP verso i quali si rivolgono i principali oneri del DSA. Una volta designati sono chiamati ad agire come regolatori del rischio ma soggetti alla vigilanza e al controllo delle autorità, in un dialogo continuo coi regolatori che hanno anche poteri esecutivi.

A queste categorie si applicano differenti oneri:

Obblighi di trasparenza e informazione:

- rapporti sulla trasparenza e termini del servizio che includono i diritti fondamentali (tutte le categorie);

- obbligo di notifica e informazioni agli utenti (cat. 2, 3, 4);

- trasparenza sulla pubblicità (cat. 3 e 4);

- trasparenza dei sistemi di raccomandazione (cat, 4);

- condivisione dei dati con autorità e ricercatori (cat. 4).

Obblighi di cooperazione:

- cooperazione con le autorità nazionali a seguito di ordini e punti di contatto e, se necessario, rappresentante legale (tutte le categorie);

- meccanismo di reclamo e risoluzione extragiudiziale delle controversie (cat. 3 e 4);

- revisione contabile esterna, conformità interna e cooperazione in risposta alle crisi (cat. 4).

Obblighi di contrasto a beni, servizi o contenuti illegali:

- trusted flaggers, misure contro le notifiche e le contro-notifiche abusive o ripetitive, obblighi speciali per i marketplace (es. verifica delle credenziali dei fornitori terzi), compliance by design, controlli casuali, segnalazione di reati, obblighi di gestione del rischio (cat. 3 e 4);

- codici di condotta (cat. 4).

In questo quadro si è di recente posto all’attenzione come nuovo attore Mastodon. Mastodon è un protocollo aperto, per cui chiunque può creare un’istanza, e di conseguenza non dovrebbe essere considerato nel suo complesso (anche se le varie istanze si “parlano”) ma ogni istanza sarebbe una piattaforma (hosting per la precisione) a sé. Quindi avrebbe obblighi limitati in base al DSA, a meno che le singole istanze non abbiano ricavi superiori ai 10 milioni o almeno 50 dipendenti, nel qual caso scattano ulteriori obblighi (ma non quelli dei VLOP).

Responsabilità dei fornitori e moderazione dei contenuti

L’impianto della direttiva eCommerce viene mantenuto, con l’introduzione di obblighi in materia di trasparenza. Quindi rimane (artt. 4, 5 e 6) l’esenzione di responsabilità per i fornitori di servizi online (hosting, caching e mere conduit) e l’assenza di un generale obbligo di sorveglianza da parte della piattaforma sui contenuti immessi dagli utenti dei suoi servizi (art. 8). Possono, invece, essere soggetti (Considerando 25) a obblighi di monitoraggio o rimozione di specifici contenuti (come ad esempio l’obbligo previsto dall’art. 17 della Direttiva Copyright).

Il DSA introduce (considerando 26 e art. 7) la clausola del “buon samaritano” che prevede che l’indagine volontaria sui contenuti immessi dagli utenti al fine di stabilire se siano leciti o illeciti, non necessariamente determini una “consapevolezza” del contenuti ai sensi della normativa vigente, purché tali attività siano svolte in buona fede e in modo diligente. In base alla normativa vigente, infatti, la piattaforma rimane esente da responsabilità fin quando non è consapevole dell’illiceità del contenuto (secondo la CGUE il prestatore non è responsabile quando svolge un ruolo di natura meramente tecnica, automatica e passiva, vedi sentenza Youtube, 105-106), per cui un controllo sui contenuti avrebbe potuto far venire meno l’esenzione da responsabilità. I termini vaghi, mai realmente chiariti dalla Corte di giustizia europea nelle varie sentenze in materia, hanno sempre favorito un approccio hands-off, evitando una effettiva moderazione per non dover rispondere dei contenuti immessi dagli utenti. Tale approccio, però, favorisce la moltiplicazione dei contenuti illeciti o discutibili e ovviamente scontenta gli utenti che preferiscono un ambiente più “pulito”.

Per questo motivo il DSA, dopo aver ribadito le norme della direttiva eCommerce in materia di esenzione, aggiunge un ulteriore livello normativo includendo una sorta di clausola del Buon Samaritano che ha lo scopo di incentivare la moderazione effettiva dei contenuti online. Questo è un aspetto molto importante per i tanti utenti (influencer, artisti, blogger) che creano contenuti (e che vivono di questa attività), i quali fino ad oggi erano esposti alla mercé di altri utenti (o delle stesse aziende) che volevano appropriarsi dei loro contenuti. Inoltre (considerando 18) il DSA non menziona il controverso requisito della “passività” della piattaforma (così seguendo la sentenza L’Oreal – 112-113 - e non quella Youtube) e presuppone (considerando 21) che la piattaforma di hosting possa essere coinvolta nella gestione dei contenuti in una certa misura senza perdere l’esenzione da responsabilità (sena diventare hosting “attivo”). In tal modo sposa la tesi che il prestatore di servizio può essere coinvolto e quindi svolgere un ruolo attivo, senza perdere l’esenzione, purché tale ruolo non sia tale da dargli consapevolezza o controllo sul contenuto illecito. La passività, in conclusione, non è più richiesta.

In realtà la clausola per come è prevista non garantisce l’immunità ai prestatori di servizi, per i termini piuttosto vaghi (buona fede, diligenza) la cui interpretazione potrà portare a problemi attuativi. Ad esempio, se un fornitore dopo aver condotto l’indagine ritiene che il contenuto non sia illecito e non lo rimuove, si può ancora ritenere che sia in “buona fede” o che abbia agito “diligentemente”? E’ evidente che anche con questa clausola permane nell’ordinamento europeo un incentivo a rimuovere i contenuti dubbi, anche se tale incentivo è comunque limitato dal fatto che la valutazione dovrà essere comunicata e spiegata (art. 14, 17 e 20) chiaramente all’utente che subisce il provvedimento di rimozione da parte della piattaforma. E questo a differenza dell'ordinamento statunitense (art. 230 c) 2) del Communication Decency Act) nel quale per ottenere l’esenzione da responsabilità è sufficiente che gli intermediari adottino misure volontarie per limitare l'accesso o la disponibilità di determinati contenuti, anche se poi i contenuti illeciti non riescono a trovarli o non intraprendono alcuna azione (appunto, la protezione del Buon Samaritano).

Della clausola del “buon samaritano” ne abbiamo parlato qui:

→ Leggi anche >> Digital Service Act: l’Europa prepara le nuove regole per le piattaforme online

È significativo, comunque, che il DSA prenda atto che il problema dei contenuti illegali non è risolvibile scaricando l’onere solo sulle piattaforme. Il considerando 27, infatti, precisa che “ove possibile, i terzi interessati da contenuti illegali trasmessi o memorizzati online dovrebbero cercare di risolvere i conflitti relativi a tali contenuti senza coinvolgere i prestatori di servizi intermediari in questione”. In sostanza un diffamato dovrebbe, se possibile, prendersela con diffamante e non con la piattaforma.

Il problema della moderazione dei contenuti è sentito particolarmente per la VLOP e VLOSE con il rischio sistemico di diffusione di contenuti illegali o di disinformazione o di manipolazione intenzionale del servizio e le conseguenti ricadute negative sulle libertà fondamentali di espressione, di informazione. Un problema che si è posto in particolare con l'invasione russa in Ucraina, che ha portato a livelli molto più elevati la già presente propaganda russa in Occidente e in particolare in Europa. Il DSA ovviamente nasce prima dell’invasione, ma già le discussioni guardavano a tali problemi. In tal senso troviamo delle norme specifiche che impattano sulle politiche di moderazione dei contenuti, come l’onere di svolgere delle specifiche valutazioni dei rischi sistemici e attuare, se necessario, delle misure per ridurre tali rischi.

Moderazione dei contenuti e tutela dei diritti fondamentali

Una novità introdotta col DSA è l’articolo 14 che prova ad introdurre nell’ambiente digitale l’obbligo di tutelare i diritti fondamentali dei cittadini (come previsti dalla Carta dei diritti fondamentali dell’Unione europea), in particolare la libertà di espressione. Prima del DSA sostanzialmente nessuna normativa imponeva ai privati (le piattaforme e in genere gli attori presenti nell’ambiente digitale) obblighi di tenere in considerazione (due regard) i diritti fondamentali dei cittadini nell’esercizio delle loro attività.

Finora nessun tribunale nazionale e internazionale si è mai realmente spinto nel ritenere una piattaforma del web (es. un social media) una sorta di “forum pubblico” (è pacifico che i privati non devono condurre attività riservate allo Stato), quindi con obblighi di tutela dei diritti fondamentali dei cittadini (la relazione tra piattaforme e utenti è privatistica non pubblicistica). Al massimo alcuni tribunali si spingono a ritenere che nell’ambito privatistico anche dovrebbero essere tenuti in considerazione i diritti fondamentali. Tali obblighi, invece, sono rivolti agli Stati (obbligo verticale), nel rapporto con i cittadini, ma non ai privati (obbligo orizzontale). Per semplificare possiamo dire che è un errore, giuridicamente parlando, riferirsi ad un social media come una “piazza pubblica”. Un social media potrebbe essere, piuttosto, come un centro commerciale posto agli angoli di una piazza pubblica, laddove la piazza pubblica è l’intera internet. Anche se bisogna ricordare che il Relatore speciale dell’ONU per la libertà di espressione ha detto più volte che le piattaforme dovrebbero inserire direttamente nei loro TOS i diritti fondamentali dei cittadini (non come obbligo giuridico ma volontariamente). Inoltre un Avvocato Generale della Corte di giustizia europea ha enfatizzato l’importanza delle piattaforme come “infrastrutture essenziali” per l’esercizio della libertà di comunicazione online.

Occorre aggiungere, però, che gli articoli 10 della Carta dei diritti dell’uomo e 11 della Carta dell’Unione europea contengono delle obbligazioni positive per gli Stati (vedi anche CEDU: Remuszko v. Poland). Questi ultimi non solo devono astenersi dall’interferire con la libertà di espressione dei cittadini, ma hanno un obbligo di tutela della libertà di espressione anche nella sfera della relazioni tra privati.

Il DSA, quindi, riempie un importante vuoto (finora solo il Regolamento per i contenuti terroristici contiene un obbligo di tenere in considerazione i diritti fondamentali – art. 5.1 -). In tal senso introduce una serie di obblighi che, ovviamente, vanno a impattare direttamente sulla moderazione dei contenuti da parte della piattaforme online (che è spesso vista come una minaccia alla libertà di espressione e al dibattito pubblico, anche in considerazione degli incentivi ad eccedere nelle rimozioni). La scelta è stata quella di privilegiare la regolamentazione delle procedure e non del discorso (cioè i contenuti). Con ciò evitando il pericoloso compito di dover stabilire se occorre regolamentare solo i contenuti illeciti (in violazione delle norme) oppure anche quelli soltanto discutibili (es. hate speech, disinformazione).

In questa prospettiva si continua a seguire la strada della “delega” alle aziende private per la regolamentazione dei contenuti online, ma questa è un’ovvia conseguenza dell’impossibilità di una regolamentazione affidata a tribunali statali, data l’enorme quantità di contenuti che vengono immessi online ogni secondo. Per cui si è doverosamente preso atto che l’unica possibilità rimane affidare la regolamentazione dei contenuti alle piattaforme del web, considerandola anche come attività a rischio (in quanto impattante sui diritti fondamentali dei cittadini). Occorre aggiungere che probabilmente la sostanziale delega ai privati discende anche da un’altra considerazione pratica. Valutando che la moderazione dei contenuti è un compito impossibile (si tratta di mettere d’accordo tra loro 8 miliardi di individui!) se il governo si assumesse il compito passeremmo dalla rabbia dei cittadini contro le piattaforme ad una rabbia contro il governo.

In questo quadro il DSA introduce (Quintais, Appelman, Fahy, Using Terms and Conditions to Apply Fundamental Rights to Content Moderation) con l’articolo 14 un obbligo di prendere in considerazione i diritti fondamentali dei cittadini (recipients of the service). Questo onere si sostanzia innanzitutto in un obbligo di trasparenza e di informazione (in particolare per i VLOP e VLOSE). Per cui le piattaforme devono introdurre nei loro TOS (termini di servizio) specifiche indicazioni, in particolare relativamente alle procedure per la gestione dei contenuti (cosa è vietato), dei reclami ai provvedimenti delle piattaforme (sospensioni, rimozioni, cancellazioni), della possibilità di rivolgersi, in ultima istanza, anche a tribunali o autorità statali (le cui decisioni dovrebbero essere vincolanti per la piattaforma), sui parametri utilizzati dagli eventuali sistemi di raccomandazione dei contenuti presentati agli utenti. Inoltre dovranno essere più chiari sulle motivazioni che portano a provvedimenti di rimozione o sospensione, in modo da rendere consapevoli gli utenti del motivo che ha portato al provvedimento.

In seconda battuta, appunto, il DSA introduce un obbligo di considerare nell’attuazione e applicazione dei TOS anche i diritti fondamentali dei cittadini (incorporare i diritti fondamentali nei TOS), in particolare la libertà di espressione e il pluralismo dei media. Inoltre è espressamente previsto che le piattaforme debbano agire in maniera diligente e proporzionata, e non arbitraria né discriminatoria. I VLOP devono, inoltre, condurre delle valutazioni del rischio relativo alle loro attività (quindi diffusione di contenuti che impattano negativamente sui diritti fondamentali). L’obbligo di valutare i diritti fondamentali dei cittadini ha, ovviamente, delle ricadute, come ad esempio l’onere di un appropriato addestramento del personale che si occupa della moderazione dei contenuti. Ovviamente il rispetto dei diritti fondamentali non riguarda solo la decisione della piattaforme, ma l’intera procedura che porta al provvedimento di valutazione dei contenuti.

Se tale nuovo onere è decisamente importante, non possiamo non evidenziare che alla fine il DSA è una normativa quadro, che necessita di una attuazione concreta principalmente delegata alle aziende. La vaghezza dei termini, le difficoltà attuative, possono rendere una concreta applicazione dei diritti fondamentali dei cittadini difficile e complessa. Comunque è un primo passo importante che si muove nell’ottica del cosiddetto costituzionalismo digitale, cioè l’adattamento dei valori costituzionali alle peculiarità dell’ambiente digitale.

Sotto questo aspetto possiamo dire che l’attuazione diretta dei diritti fondamentali dei cittadini dovrà essere basata sugli standard ormai riconosciuti in materia (violenza, incitamento all’odio, propaganda terroristica, materiale estremista, attacchi politici, materia di pubblico interesse, ecc...), in genere derivante da una serie di pronunce delle corti internazionali, la Corte europea dei diritti dell’uomo (CEDU) e la Corte di giustizia europea (CGUE), che più volte si sono occupate di tali materie, segnando una serie di provvedimenti di rilievo ai quali fare riferimento per l’applicazione concreta.

Ciò nonostante sono sorte anche ampie critiche a questo approccio. Innanzitutto l’idea che siano applicati tali principi giuridici potrebbe portare a credere che la moderazione dei contenuti online diventerà priva di problemi, quando in realtà è pacifico che l'applicazione degli standard sui diritti umani a livello individuale non cancella necessariamente le ingiustizie e discriminazioni collettive e strutturali (es. discriminazioni per le minoranze). Inoltre non dobbiamo dimenticare che la moderazione dei contenuti effettuata dalle piattaforme dipende quasi essenzialmente da scelte commerciali. E come è noto l’ambiente pubblicitario, la gestione delle inserzioni, è purtroppo ancora molto legato a contenuti virali, laddove tali contenuti spesso si rivelano quelli che provocano, che attizzano rabbia e odio.

Anche le aziende private, tra l’altro, hanno i loro diritti fondamentali, come la loro libertà di espressione e la libertà di impresa. Tali diritti entrano comunque nella valutazione, e vanno adeguatamente valutati in proporzione coi diritti dei cittadini e utenti della piattaforma. Quindi, le piattaforme hanno i loro diritti di gestire i contenuti online in modo da ricavare dei profitti dall’attività (per cui imposizioni di obblighi di pubblicare contenuti difficilmente potrebbero essere attuabili). In tal senso le piattaforme hanno anche il diritto di rimuovere contenuti che finiscono per ledere la loro capacità di generare profitti (ad esempio la pubblicazione di contenuti di hate speech ai quali gli inserzionisti pubblicitari rifiutano di legare i propri marchi o prodotti).

In breve l’approccio proposto alla tutela della libertà di espressione si presenta sotto forma di garanzie procedurali imposte alle piattaforme del web, alle quali sostanzialmente viene delegata l’effettiva regolamentazione. L’utente bloccato dovrà conoscerne il motivo ed essere informato della possibilità di appellarsi alla decisione, compreso la possibilità di un ricorso giurisdizionale (o amministrativo).

Pubblicità online

Il DSA obbliga le piattaforme a rendere (art. 26) riconoscibili in modo inequivocabile le pubblicità, chi paga la pubblicità e il soggetto per conto del quale viene presentata la pubblicità (se diversi). Inoltre dovranno essere fornite agli utenti informazioni chiare sui parametri utilizzati per determinare il destinatario al quale viene presentata la pubblicità e, laddove applicabile, le modalità di modifica di detti parametri.

La norma prevede (art. 26.3) anche il divieto di indirizzare pubblicità in base alle categorie speciali dei dati di cui all’articolo 9 par. 1 del GDPR (cioè dati personali che rivelino l'origine razziale o etnica, le opinioni politiche, le convinzioni religiose o filosofiche, o l'appartenenza sindacale, dati genetici, dati biometrici intesi a identificare in modo univoco una persona fisica, dati relativi alla salute o alla vita sessuale o all'orientamento sessuale della persona). Nel caso in cui i destinatari siano minori è vietata (art. 28) la pubblicità basata sulla profilazione, se la piattaforma è consapevole, con ragionevole certezza, che il destinatario del servizio sia un minore.

I cosiddetti dark pattern (quelle tecniche di design di un sito web o un applicativo tali da indurre un utente a fare delle scelte che normalmente non farebbe) sono sostanzialmente vietati. In realtà il divieto si va sostanzialmente a sovrapporre agli standard già esistenti in materia di protezione dei consumatori e protezione dei dati.

Nuovi organismi di vigilanza

Il DSA introduce i Coordinatori dei Servizi Digitali (DSC), organismi stanziati negli Stati membri col compito di vigilare sull’applicazione delle norme rispetto alle piattaforme che hanno il principale stabilimento nello Stato membro. Il DSC avrà poteri investigativi e di esecuzione, come quello di ordinare la cessazione delle violazioni, imporre misure correttive o anche provvisorie per limitare i danni. Infine avrà anche il potere di imporre sanzioni effettive, proporzionate e dissuasive, fino al 6% del reddito annuo o del fatturato del fornitore di servizi.

Meccanismo di risposta alle crisi

L’articolo 36 consente alla Commissione europea di imporre ai VLOP e VLOSE delle specifiche azioni, quali valutare se i loro servizi possano contribuire a una minaccia grave, individuare misure specifiche (elencate negli articoli 35 e 48) per prevenire o eliminare il contributo alla minaccia grave. Per minaccia grave si intende una minaccia alla sicurezza e alla salute pubblica. Si tratta di una norma introdotta nel periodo dell’invasione dell’Ucraina che nel suo testo iniziale avrebbe dato ampi poteri alla Commissione per stabilire come le grandi piattaforme del web devono gestire il flusso dei contenuti in periodo di guerra o pandemia.

La norma nasce dalla consapevolezza che in periodi di crisi (come la pandemia, quando venivano diffusi molti contenuti di disinformazione) generalmente è necessario confidare nella buona volontà delle aziende del web. Ma ovviamente un meccanismo di questo tipo avrebbe finito per concentrare troppo potere nelle mani dell’esecutivo europeo. Per questo è stata parzialmente ridimensionata grazie all’apporto delle organizzazioni per i diritti civili.

Oneri eccessivi per le piattaforme minori

Un aspetto immediatamente evidente è che, nonostante la suddivisione in categorie con oneri differenziati, comunque il DSA prevede degli obblighi piuttosto stringenti anche per le piattaforme minori. Ad esempio raggiunti 10 milioni di fatturato e 50 dipendenti obblighi di trasparenza e obblighi di prevedere la possibilità di ricorrere contro i provvedimenti di rimozione vengono imposti a tutte le piattaforme laddove, ad esempio, Facebook pubblicò il suo primo rapporto nel 2013 quando già valeva circa 140 miliardi di dollari. Youtube attualmente prevede i ricorsi per le rimozioni di video ma non per i commenti, in considerazione dell’elevato numero. È evidente che porre aziende di piccole dimensioni allo stesso piano (o quasi) delle grandi aziende del web significa che dovranno gestire oneri piuttosto costosi che rischiano di diventare una barriera all’ingresso del mercato, impedendo così loro di rivaleggiare con le grandi aziende che già hanno una base utenti (e quindi un fatturato) consolidata. Ciò potrebbe portare a consolidare posizioni già dominanti sul mercato. Probabilmente per le aziende più piccole potrebbe diventare economicamente più vantaggioso semplicemente eliminare la possibilità di commentare.

Conclusioni

Il DSA è un buon strumento che parte dall’ovvia considerazione che la concorrenza tra aziende non basta per produrre una società migliore. Da cui la necessità di un intervento statale che stabilisca un quadro regolatorio imponendo degli oneri per evitare che le attività economiche finiscano per creare conseguenze negative sull’ambiente sociale. Quindi non è solo uno strumento che si occupa di regolamentare l’ambiente economico (pur essendo inscritto nel Digital Single Market) ma, forse per la prima volta, è una normativa europea che va oltre preoccupandosi effettivamente di altri aspetti e cercando una prospettiva decisamente più ampia. È significativo in tal senso l’approccio tutelante per i diritti fondamentali dei cittadini.

Purtroppo questo strumento si basa molto sulle strutture sociali. Esso funzionerà solo se ci sarà una sforzo dell’intera società civile nell’attuazione dello stesso. Occorreranno, per capirci, che gli europei siano consapevoli dei propri diritti e si attivino per farli valere (es. l’art. 45 prevede il coinvolgimento dei rappresentanti dei gruppi sui quali impattano le attività delle aziende, ovviamente in primis i gruppi maggiormente soggetti a potenziali discriminazioni). Occorreranno attivisti e associazioni dei consumatori che si occupino di segnalare i contenuti malevoli e si attivino in caso di ingiuste rimozioni, occorrerà che i genitori si occupino attivamente della gestione dei figli verificando come le piattaforme riducono i rischi piuttosto che parcheggiarli dinanzi all'ennesima App (come una volta si faceva col televisore). Il DSA incentiva le categorie (es. i giornalisti) ad agire insieme per difendere i propri diritti e plasmare più correttamente l’attuazione delle norme previste. Uno degli aspetti rilevanti emersi dall’attuazione del regolamento europeo in materia di protezione dei dati personali, infatti, è dato dalla cooperazione tra le autorità garanti dei singoli Stati nazionali che consentono un miglior contrasto alle violazioni delle grandi piattaforme laddove è evidente che un singolo garante non ha le risorse per svolgere adeguatamente tale attività. Infine, molto dipenderà dalle risorse che saranno messe a disposizione delle autorità nel difficile compito di dialogare e monitorare l’attività delle piattaforme e verificare nel concreto l’adeguatezza delle politiche attuative degli oneri imposti dal DSA.

In caso contrario l’intero strumento non sarà altro che una serie di ottime intenzioni messe su carta e la gestione dell’intero ambiente digitale sarà plasmata dall’incentivo economico e lasciata alle aziende del web.

Immagine in anteprima via cybersecurity360.it