Estinzione dell’umanità? I veri rischi delle Intelligenze Artificiali sono ben altri

|

|

Il virus dei colonizzatori

L’epidemia del nuovo coronavirus è nata nei paesi economicamente più avanzati, e si è diffusa velocemente grazie agli spazi condivisi che i paesi sviluppati hanno creato per moltiplicare l’accumulazione del capitale a livello globale. Eppure il nuovo coronavirus grava in maniera decisamente più pesante sui paesi meno sviluppati, come l’Africa, complice anche le politiche vaccinali dei paesi sviluppati che rendono più difficile produrre i vaccini in quel continente. Il virus è bianco, ma il vaccino diventa funzionale alla conservazione del peso egemonico degli attori statali piuttosto che alla risoluzione della pandemia.

Questo paradossale effetto è la conseguenza delle politiche di colonizzazione da parte dei paesi più sviluppati, non solo quelli occidentali ovviamente. L'imposizione della cultura dei colonizzatori e la completa sottomissione del colonizzato, porta quest’ultimo a diventare uno strumento dell’imperialismo culturale, che progressivamente convince il colonizzato che egli è tale per una giusta ragione, perché inferiore. In una sorta di sindrome di Stoccolma collettiva, i colonizzati aiutano i colonizzatori a mantenere uno status di inferiorità culturale e di incapacità politica. I meccanismi dell'oppressione bianca, del colonialismo, sono studiati da secoli, eppure continuano ad applicarsi tutt’oggi. Quello che è cambiato sono gli strumenti. Se un tempo il colonialismo era armato, oggi è prevalentemente culturale ed economico.

Le conseguenze di ciò non sono subito evidenti, ma è palese dagli studi che esistono delle profonde differenze tra, ad esempio, la realtà americana ed europea e quella dell’Africa. Uno studio che ha esaminato le pratiche di rilevamento precoce del cancro al seno tra l'Africa subsahariana e i paesi ad alto reddito, ha scoperto che ciò che funziona in Occidente, cioè le mammografie, in Africa non è efficace nel ridurre la mortalità per cancro al seno. I fattori incidenti sono un profilo di età inferiore, una presentazione con malattia avanzata e opzioni terapeutiche disponibili limitate. Tutto ciò suggerisce che l'autoesame e l'esame clinico del seno nell’Africa subsahariana funzionano meglio della pratica medica progettata per le loro controparti in paesi ad alto reddito. Questa esempio ci fa capire come la semplice importazione di strumenti tecnologici occidentali (AI di supporto o consulenza medica) potrebbe portare più danni che benefici. Non solo, tale importazione finirebbe anche per sottrarre risorse preziose a strumenti locali più adatti alla realtà del luogo e al contesto specifico.

Nel cuore delle AI

La tecnologia del momento è l’intelligenza artificiale, quella che ha spodestato la blockchain e il metaverso nell’immaginario collettivo e sulle prime pagine dei giornali. In effetti l’impressione è che questa tecnologia abbia effettivamente maggiori possibilità di incontrare quanto meno la curiosità del pubblico. Del resto i “creatori” come Sam Altman non lasciano passare giorno senza ricordarci la distruzione di massa che la sua tecnologia è in teoria capace di provocare. Argomenti del genere trovano facile sponda nei mass media affamati di sensazionalismo e sempre pronti a spingere sul filtro techlash alimentando l’indignazione costante contro le nuove tecnologie. E così ogni giorno leggiamo che le AI potrebbero portare addirittura all’estinzione della civiltà umana, e se da un lato questo ci terrorizza, dall’altro è evidente la fascinazione per una tecnologia così dirompente tanto da essere paragonata alla tecnologia nucleare.

ChatGPT, i rischi per l’umanità e la sindrome SkyNet

Ma nonostante le mirabolanti descrizioni che magnificano sistemi ritenuti ormai quasi senzienti, alla base delle AI non c’è altro che una quantità enorme di dati raccolti e lavorati da sottopagati operatori spesso residenti in paesi sottosviluppati come l’Africa o l'Asia orientale. Il loro compito è di immettere dati e informazioni in enormi database che saranno poi ingurgitati da software complessissimi che si occuperanno di creare quello che noi oggi chiamiamo, impropriamente, sistemi di intelligenza artificiale. Sono schiere di “contractor”, persone che attraverso delle piattaforme sviluppate apposta, lavorano a progetti con nomi improbabili come Yukon o Crescent, e il cui compito consiste nell’etichettare immagini e video, nel verificare quale tra i risultati di ricerca proposti a video risulta effettivamente più efficace in relazione ad una specifica query, nel verificare se il risultato ha la corretta formattazione e così via.

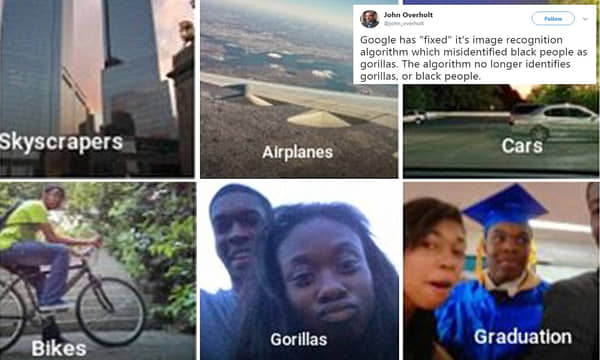

Il lavoro di questi sottopagati operai serve anche a correggere gli errori e i bias dei dataset utilizzati per l’addestramento degli algoritmi, e quindi dei sistemi di intelligenza artificiale. Perché uno dei più grandi problemi di questi sistemi complessi non è la loro capacità di distruggere la civiltà umana, quanto piuttosto l’amplificazione delle discriminazioni sociali. Quel lavoro serve per evitare errori come quello che accadde nel luglio del 2015, quando una persona di colore venne etichettata come gorilla dall’algoritmo di Google. Ma perché accadono errori del genere?

I problemi e i rischi del riconoscimento facciale tra Cina e resto del mondo

La discriminazione delle persone di colore dipendeva da una serie di problematiche connesse. Innanzitutto il riconoscimento facciale è difficile di per sé, il sistema sbagliava anche coi bianchi, alcuni dei quali venivano etichettati come cani, o foche. Nel caso delle persone di colore, però, l’errore si innesta su un problema culturale, anni di discriminazione razziale introitati dalla nostra società. L’illuminazione di un volto dipende da dei modelli standardizzati creati negli anni ‘50, le cosiddette Schede Shirley, dalla modella originale, Shirley, che era dipendente della Kodak, la multinazionale all’epoca leader del settore fotografico. Si tratta di immagini di modelli standardizzati che sono usati per calibrare i toni della pelle, le ombre e le luci nella fase di stampa. Il problema di questi modelli, comuni a tante situazioni simili, è che erano esclusivamente focalizzati sui bianchi, creati da bianchi per i bianchi, e in questo modo l’illuminazione del volto di una persona di colore era più difficile e questo incideva sul riconoscimento di un volto rendendolo più complicato e aperto a possibili errori. Solo negli anni ‘70 si iniziò ad affrontare la revisione di questi standard.

Pregiudizio culturale

Il pregiudizio culturale è il risultato di dati di addestramento influenzati da stereotipi culturali, come ad esempio un algoritmo di visione artificiale addestrato su persone bianche, che quindi fatica a riconoscere quelle di colore, oppure un algoritmo addestrato in relazione al genere. Il sistema ingurgita milioni di immagini dove si vedono donne in cucina e uomini al lavoro e quindi “impara” che la donna sta in cucina, mentre è l’uomo che va al lavoro. Se un sistema del genere fosse utilizzato senza correzione di bias per la selezione di candidati, facilmente preferirebbe uomini per i posti di programmatore.

Così nel 2017 un professore dell’università della Virginia nota che un sistema algoritmico produce risultati “sessisti”, associando alle donne immagini di cucina e così via. Analizzando gli input forniti alla macchina vede che due collezioni di immagini, tra cui una supportata da Microsoft e Facebook, presentava una distorsione di genere nella raffigurazione di attività come la cucina e lo sport: mentre le immagini di cucina, shopping e lavaggio erano associate a donne, quelle di sport erano legate ad uomini. Il software di apprendimento automatico in fondo non faceva altro che il suo lavoro: apprendeva, erano le immagini che soffrivano di pregiudizi.

Nel 2018 si scopre che Amazon aveva avviato un programma di valutazione dei curriculum online che, basandosi sui dati storici, finisce per preferire uomini a donne per i posti da assegnare (programmatori o comunque posizioni tecniche). A questo proposito è significativo che in uno studio del 2015 solo il 15% degli studenti ricorda di aver visto donne svolgere compiti di informatica in film o in TV, cosa che si riflette nella vita reale in cui le donne costituiscono solo il 17% delle major in informatica - un costante calo da un picco al 37% nel 1984. Il sistema, quindi, comincia a scartare i curriculum nei quali ci sono termini quali “donna” o simili, addirittura eliminando un curriculum solo perché vi era indicato “capitano della squadra di scacchi femminile” (women’s chess club captain). Ancora, il sistema preferiva il linguaggio utilizzato dai candidati maschi. Col passare del tempo, nonostante i tentativi di risolvere i problemi, il sistema ha finito per raccomandare candidati non qualificati, come se la selezione fosse completamente random. Alla fine il programma è stato chiuso.

E non è un problema della AI, non è un problema del sistema che ragiona male o produce risultati inesatti, il problema dipende dalla società sottostante, quella stessa società che produce i miliardi di dati che poi saranno ingurgitati dalla AI. Sono gli esseri umani, siamo noi che scriviamo gli articoli di giornale, le guide scolastiche e i commenti discriminatori che poi finiscono nell’enorme calderone del dataset e formano una AI con pregiudizi. La ricercatrice e pedagogista Irene Biemmi sostiene che nelle storie raccontate nei testi per l’infanzia tutt’oggi si riproducono stereotipi di genere che ingabbiano bambini e bambine nel loro percorso di formazione. Analizzando i libri di lettura di quarta elementare di 10 case editrici vede che “il 59% delle storie ha per protagonista un maschio, quelle con una protagonista femminile sono il 37 per cento, condividono il ruolo solo nel restante 4%. Per ogni dieci protagoniste femmine ci sono sedici maschi. Una raffigurazione dei due generi ben poco paritaria”.

Le donne nei libri di formazione sono poco rappresentate, spesso confinate ai ruoli domestici, sottomesse. Ma il problema non si ferma lì, anche i profughi sono rappresentati come “clandestini” che vivono nelle nostre città “in condizioni precarie, senza un lavoro e una casa dignitosi”. E sono queste le cose che i nostri figli apprendono a scuola e che formano l’immaginario e la cultura delle nuove generazioni. E tutto questo si riversa, poi, nella produzione culturale fino ai commenti sui social, che a sua volta diventa la base per l’addestramento dei sistemi di intelligenza artificiale. La matematica non può molto per superare il pregiudizio strisciante nella nostra società.

Nei sistemi di intelligenza artificiale è necessario che si inseriscano dei correttivi per gli evidenti bias dei dati di addestramento perché il processo decisionale dipendente da algoritmi finisce per replicare le discriminazioni presenti nei dati di input, amplificandone gli effetti, data la scala di utilizzo. E poiché per le minoranza ci sono meno dati, l’impatto è maggiore per esse. I nostri modelli sulle minoranze tendono a essere peggiori di quelli per la popolazione in generale.

Ma l’intera questione è ben più problematica, perché dati “non biased” in realtà non esistono. In un certo senso i dati sono opinioni, come afferma la data scientist Cathy O’Neill (Weapons of math destruction), occorre essere consapevoli che misurarli è di per sé un atto ideologico. Io ho una mia ideologia e quindi penso che abbia senso misurare (datification, ridurre il mondo in termini matematici analizzabili da una AI) il mondo in un certo modo, nel mio modo. Io penso che il mio sia il modo migliore di misurare il mondo, e questo purtroppo appare sempre più vero per quanto riguarda coloro che sono a capo di grandi società tecnologiche, come Elon Musk, che credono di essere i migliori solo perché loro ce l’hanno fatta, hanno avuto successo.

Nell’addestramento delle AI, poi, c’è una sequenza che porta a sommare bias su bias, quelli del creatore, dell’ingegnere, del data collector, della stessa AI che estrapola dal dataset le regole che formano il suo “cervello”, in una moltiplicazione dei bias che si inseriscono in un sistema che fondamentalmente non è altro che una enorme black box, una scatola chiusa e impermeabile nella quale non possiamo guardare, e l’unico modo per capire come opera sta nel verificare gli input e gli output.

Potere e controllo

Gli algoritmi hanno a che fare col “controllo”. Le nostre vite sono regolate dagli algoritmi programmati dagli ingegneri. Se una volta l’uomo era controllato perché rinchiuso in luoghi di supervisione, come la fabbriche o le scuole, oggi l’individuo (individuo vuol dire indivisibile) può andare dappertutto, c’è decisamente maggiore libertà di movimento rispetto al passato. Ma il controllo non è scomparso, anzi oggi è ancora più pervasivo, tramite le telecamere, le tessere di identificazione, le smart card, i sensori immersi nelle strade e per le città. Tutti questi “sensori” che ci circondano scompongono l’individuo in una miriade di dati, che alimentano una enorme quantità di flussi di informazione che tramite mille rivoli (online, ma non solo) finiscono per riunirsi nei data base dei data broker a realizzare un profilo per ogni cittadino.

L’individuo non è più, quindi, indivisibile, ma è frammentato e ricomposto a creare quella che non è la banale transcodifica della sua vita in informazioni gestibili da un elaboratore, quanto piuttosto l’esercizio di un vero e proprio potere, una forma di controllo. È un algoritmo, una scatola chiusa che raccoglie input da mille fonti, li elabora secondo una specifica programmazione e fornisce degli output, a decidere chi è professore, chi è studente, anche chi è terrorista. In tal modo non c’è nemmeno necessità di conoscere il nome di una persona, è sufficiente sapere cosa compra, dove vive, dove lavora, cosa fa abitualmente, conoscere le sue attività routinarie. Questa è la “datificazione”.

La datificazione non è altro che l’etichettatura degli individui secondo parametri stabiliti da chi ha il potere di controllare l’algoritmo. E statisticamente queste persone sono per lo più bianchi di lingua inglese che vivono nel nord del mondo. A questi poi si aggiungono, per il continente asiatico, i cinesi, che sono gli unici a contrastare la supremazia tecnologica degli Usa. Non è quindi solo un problema occidentale.

Il processo di trasformazione dell’essere umano in “dati” passa attraverso una serie di sotto-processi che determinano il risultato finale. I dati finali sono qualcosa di separato e diverso rispetto al materiale osservato inizialmente (l’essere umano). Ciò innesca una serie di problemi di difficile soluzione:

- I dati sono approssimati.

- I dati sono perlopiù dati storici (del passato).

- I dati sono spesso proxy data (inferiti da altri dati, ad esempio l’etnia inferita dal luogo di residenza).

L’elaborazione di dati raccolti da Internet e in particolare dai social network può, quindi, portare a discriminazioni. Le persone dovranno, così, imparare a convivere con questi algoritmi, cercando di capire come rapportarsi ad essi, come muoversi online tenendo presente quali elementi gli algoritmi prendono in considerazione. Essendo del tutto opachi, in quanto non sappiamo mai esattamente come tali algoritmi agiscano e decidano, dobbiamo imparare un gioco del tutto nuovo senza nemmeno conoscerne le regole.

I classici algoritmi di valutazione della recidiva, ad esempio, raccolgono dati derivanti da aspetti periferici. Un soggetto che vive in un quartiere povero, che frequenta gente che già ha avuto problemi con la giustizia, che non ha un lavoro, viene considerato ad alto rischio di recidiva. Negli USA statisticamente i neri vengono fermati più spesso dei bianchi, quindi di fatto hanno a che fare con poliziotti più spesso dei bianchi. In questo modo il modello di valutazione non fa altro che mascherare i pregiudizi degli essere umani, piuttosto che eliminarli. Ovviamente, il fatto di essere considerati possibili recidivanti, rende più difficile trovare un lavoro, e di conseguenza aumenta la possibilità di incappare in guai con la giustizia. E così via, in una spirale senza fine.

They define their own reality and use it to justify their results. This type of model is self-perpetuating, highly destructive and very common (Cathy O’Neil, data scientist)

Un terrorista oggi non è più una persona, quanto piuttosto un modello (type) ricavato dalla datificazione di una serie di comportamenti tipici di soggetti ritenuti terroristi. I dati (comportamenti) da estrarre sono selezionati dai programmatori del modello, quindi alla fine il modello di terrorista non descrive affatto un terrorista quanto piuttosto come un terrorista è visto dal programmatore. La costruzione di un modello ideale non si basa sulla realtà quanto piuttosto è un'approssimazione di un fenomeno dinamico, la traduzione in una quantità di numeri trattabili da un software. In tal senso la costruzione di un modello di terrorista (ma anche di altre tipologie) non è tanto l’estrazione di dati dalla realtà (raw data), quanto piuttosto la costruzione di dati a partire dall’osservazione della realtà (cooked data). E, come tale, è soggetta a molteplici errori e fenomeni discriminatori.

In fine dei conti dipende dall’algoritmo se noi abbiamo dei diritti, perché dipende dall'algoritmo se siamo identificati come soggetti che hanno dei diritti.

L’algoritmo che prevede chi commetterà un crimine, tra poca trasparenza e pregiudizi

Colonialismo culturale

Nel corso della conferenza di Bandung in Indonesia, nel 1955, il presidente indonesiano Ahmed Sukarno sostenne che il colonialismo avesse “anche un vestito moderno, nella forma del controllo economico, del controllo intellettuale […] esercitati da parte di una piccola comunità estranea all’interno di una nazione”. Il colonialismo moderno non si esercita più per mezzo delle armi, non si domina più il paese sottoposto, ma si creano le condizioni perché quel paese dipenda dal paese dominante sul piano economico. Oggi la tecnologia consente un ulteriore passo in avanti, permettendo un vero e proprio colonialismo culturale che punta a plasmare l’identità di un paese e della sua popolazione. Non è una novità, lo vediamo tutti i giorni coi mass-media, con la produzione televisiva e cinematografica. A tutto questo oggi si affianca un nuovo e penetrante strumento, i sistemi di intelligenza artificiale capaci di elaborare quantità enormi di dati per fornire risposte che hanno degli effetti importanti sull’intera società. Il rischio delle AI si dipana su tre direttrici: sono automatizzate e lavorano enormi quantità di dati su larga scala; sono opache e non ispezionabili; generalmente sono ritenute autorevoli, in quanto basate sulla matematica.

ChatGPT, Google Bard. BingChat, sono sistemi che aggregano informazioni da una grande quantità di dati da diverse fonti, da diversi autori, per creare le risposte alle domande degli utenti. La risposta non è altro che l'elaborazione statistica di una enorme quantità di informazioni correlate. Il sistema cerca la risposta statisticamente più rilevante, e questo ha un enorme impatto perché così si riduce al minimo la rappresentazione dei gruppi minoritari, dei gruppi emarginati e discriminati. L’effetto è la soppressione delle voci minoritarie, una vera e propria cancellazione dei dettagli del quadro sociale, dove tutto ciò che emerge è la punta dell’iceberg in un’unica visione algoritmica.

Se con i motori di ricerca otteniamo una serie di risposte possibili, elencate su più righe di più pagine, dove ovviamente già c’è una selezione statistica ma che comunque consente, volendo, di visitare anche risultati meno rilevanti, e quindi più aperti a possibili alternative, la risposta dei sistemi di AI inglobati in un motore di ricerca, come BingChat, di fatto elide tutte le voci differenti e minoritarie, enunciando un’unica e universale verità statistica.

Il vero problema dei sistemi di intelligenza artificiale è che rischiano di imporre una visione del mondo monolitica che prevale sulle miriadi di espressioni, tutte ugualmente legittime, della cultura umana. La vera minaccia delle AI non sta nella capacità di distruggere la civiltà umana, come ci ricorda fin troppo spesso Sam Altman e i suoi simili, quanto piuttosto nel rischio di una assimilazione culturale e nell’imposizione di valori tipici di determinate popolazioni ad altre popolazioni. Uno studente africano o asiatico che pone una domanda ad una AI, otterrà una risposta che è la visione del mondo unilaterale del creatore di quella AI, plasmata attraverso l’informazione ingurgitata dalla AI e selezionata dal suo creatore. Il sistema non ha gli strumenti per distinguere l'esperienza personale tipica di un paese, dell'utente, i valori familiari o le diverse visioni del mondo. Il risultato potrebbe essere una enorme e onnisciente macchina per il lavaggio del cervello.

Ma non si tratta di opporci all’avvento della tecnologia per rifugiarci in una nostalgica rivendicazione del passato, quanto piuttosto di prendere atto che la tecnologia è uno strumento e come tale può essere usato per il bene o per il male. Se lasciamo la regolamentazione della tecnologia ai suoi stessi creatori, questi faranno di tutto per strutturare tale regolamentazione secondo le loro idee, e ovviamente sarà tale da favorire i loro prodotti. È già accaduto alla televisione, lasciata all’appropriazione dei privati è diventata un luogo di spartizione di monopoli. Lo stesso sta accadendo ad Internet.

Ciò che occorre, invece, è prendere atto che la tecnologia può essere un ottimo strumento per far emergere le diversità di persone, di etnie e di gruppi, le differenze ideologiche e intellettive. Occorre resistere alle spinte costanti all'omologazione di massa. La critica moderna alla tecnologia concentra lo spazio della democrazia al solo momento della comunicazione, sede privilegiata della manipolazione delle coscienze, ma questo perché il terreno del potere economico si è da anni sottratto alle regole, appartandosi rispetto alla politica.

Dobbiamo invece recuperare uno spazio di discussione politica che coinvolga l’economia e la finanza, e in questo modo iniziare a regolamentare le nuove tecnologie per quello che sono, non uno strumento di manipolazione di consensi alla Cambridge Analytica quanto piuttosto lo strumento di aziende capaci di inserirsi nei processi democratici di regolamentazione e dirottare tali processi e quindi di ottenere una sorta di monopolio a protezione dei loro business. Sono aziende che fanno lobbying per guidare le leggi e gli oneri legislativi ad esse imposti, spesso perché i legislatori non sono nemmeno in grado di capire esattamente come operano gli strumenti tecnologici che queste aziende gestiscono.

Gli strumenti di intelligenza artificiale sono in mano a poche grandi aziende che stanno occupando gli spazi e monopolizzando l’attenzione dei politici, al fine di ottenere il monopolio dell'interlocuzione ai fini della loro prossima, e ormai indifferibile, regolamentazione. Ma sono quegli stessi strumenti che impoveriscono le comunità e i paesi che non hanno voce in capitolo nel loro sviluppo. Le ex colonie oggi non sono più angariate tramite la forza, quanto piuttosto da un sistema che relega la loro cultura ed esperienza particolare negli spazi più remoti dei dataset delle AI. L’invasione algoritmica dell’Africa vede dei sistemi inadatti ed inesperti rispetto ai problemi locali, ma che nel contempo lascia quei territori al di fuori dei dataset di addestramento.

Oggi il dominio e controllo delle popolazioni avviene attraverso meccanismi invisibili e sfumati, tramite il controllo degli ecosistemi digitali, dello sviluppo delle nuove tecnologie, campi nei quali sono sempre i soliti noti ad avere un ruolo. E i legislatori finiscono per rivolgersi sempre a loro per costruire possibili regolamentazioni. Così i nuovi colonizzatori possono creare ecosistemi di commercio, politica e cultura, mentre sostengono di creare conoscenza per tutti. Ma non è niente di nuovo rispetto a quello che si faceva nel passato: “sappiamo noi di cosa hanno bisogno queste persone e così veniamo a salvarle”.

Sono i più vulnerabili che vengono colpiti maggiormente dall'adozione indiscriminata delle nuove tecnologie, sono coloro che vivono ai margini della società, coloro che sono visti come devianti e che veicolano valori differenti dalla massa, coloro che non si conformano alla status quo. Se le nuove tecnologie verranno sviluppate in base al principio utilitarista, cioè quello che persegue il miglior risultato per il maggior numero di persone, avremo AI che non cercano soluzioni per le minoranze e per gli emarginati. Avremo AI che continueranno a consigliare le mammografie per le donne dell’Africa subsahariana, anche se è un errore.

La grande illusione dei Big Data. Gli algoritmi comprendono davvero il mondo?

Occorre finanziare e favorire iniziative di sistemi software, algoritmici e di intelligenza artificiale che tengano in debito conto le peculiarità dei paesi nei quali vengono utilizzati. Occorre avviare un percorso di decolonizzazione delle nuove tecnologie, come nell’AI Decolonial Manifesto redatto da studiosi delle nuove tecnologie, dove si spiega chiaramente che la soluzione per avere AI migliori non è avere più dati, ma avere dati più rappresentativi delle diversità delle popolazioni esistenti sulla Terra.

Immagine in anteprima da Bing Creator con tecnologia Dall-E