I motori di ricerca sono neutrali o ci manipolano?

15 min letturaEffetto IKEA

Pregiudizio cognitivo in cui i consumatori attribuiscono un valore sproporzionatamente elevato ai prodotti che hanno parzialmente creato. Il nome si riferisce al produttore svedese e rivenditore di mobili IKEA, che vende molti mobili che richiedono il montaggio.

Uno studio del 2011 ha rilevato che i soggetti erano disposti a pagare il 63% in più per i mobili che avevano assemblato da soli, rispetto a oggetti preassemblati equivalenti (Wikipedia)

I confini dell’informazione

I motori di ricerca sono neutrali? Oppure ci manipolano? Come tutti gli algoritmi anche i motori di ricerca sono sostanzialmente matematica applicata, basati su grandi numeri (Big Data), cosa che conferisce loro generalmente un’aurea di obiettività.

Leggi anche >> La grande illusione dei Big Data. Gli algoritmi comprendono davvero il mondo?

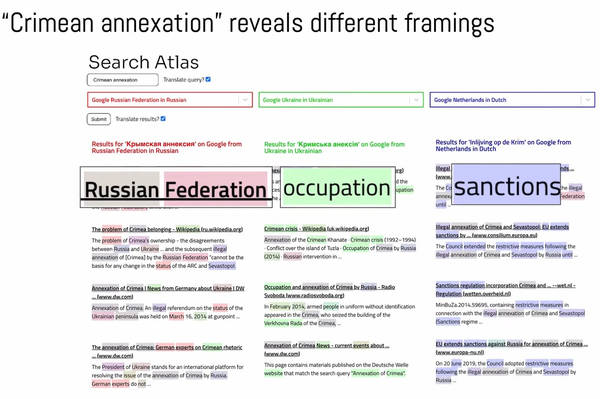

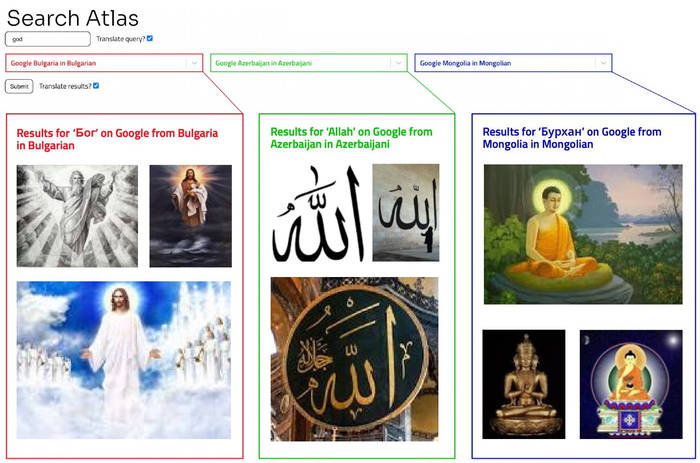

Uno studio del 2021, dal titolo Visualizing Divergent Search Results Across Geopolitical Borders, di Rodrigo Ochigame e Katherine Ye, ha dato un contribuito alla discussione critica sulla neutralità dei motori di ricerca. Per fare ciò gli autori si sono avvalsi di un’interfaccia sperimentale, Search Atlas (qui l'annuncio del lancio), al fine di comprendere come funziona l’algoritmo di Google, e quali sono le differenze di risultati che presenta agli utenti.

Ad esempio, la ricerca “crimean annexation” mostra risultati differenti a seconda dell’impostazione del motore di ricerca. Per gli utenti russi la ricerca evidenzia che la Crimea è territorio russo, per gli ucraini si parla di “occupazione”, e così via.

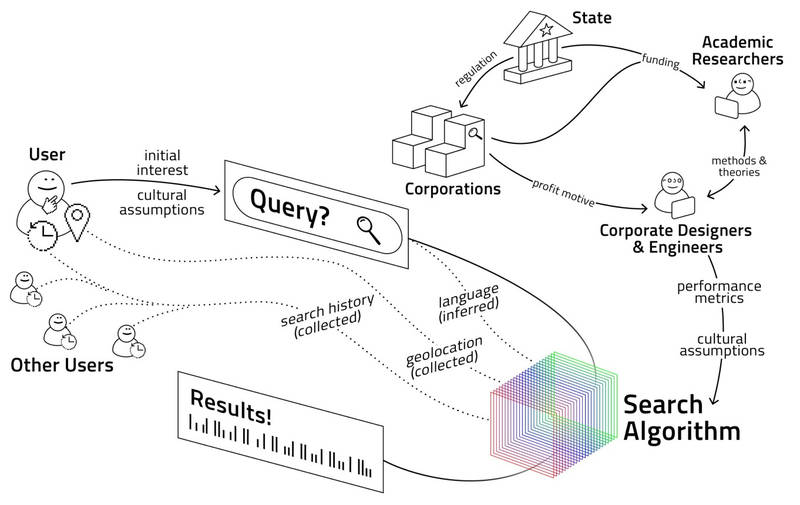

Secondo gli autori i risultati dello studio portano a credere che i motori di ricerca non rispondono agli interessi degli utenti con risultati oggettivamente rilevanti, ma non sono nemmeno editori che selezionano i risultati da mostrare, piuttosto sono prodotti complessi risultato sia di modelli culturali che di scelte di progettazione.

Ovviamente un motore di ricerca è anche figlio degli interessi economici dell’azienda, per cui non può che conformarsi agli imperativi finanziari derivanti dall’attività pubblicitaria di Google. Analogamente risponde anche alle pressioni politiche e alle normative legali: come Baidu favorisce la propaganda del governo cinese, così Google rimuove risultati in base alle norme europee, ad esempio per la protezione dei dati o per motivi di copyright.

Infine, un motore di ricerca è anche il risultato del giudizio umano dei curatori del sistema. Google, ma non solo, impiega personale umano che giudica la qualità percepita dei risultati di ricerca, e moderatori di contenuti che ne giudicano l’appropriatezza e la liceità (Rethinking gaming: The ethical work of optimization in web search engines).

Search Atlas rende facile vedere come Google offre delle risposte differenti a seconda della versione del motore di ricerca, ad esempio risposte diverse per la Cina rispetto agli Usa, e così via. In tal modo Google search rispecchia le differenze culturali, come anche le preferenze delle autorità locali, offrendo agli utenti differenti realtà a seconda dei luoghi o delle lingue. Così emergono i “confini” dell’informazione online.

Non si tratta di una novità, già nel 2018 Safiya Noble, cofondatrice e condirettrice del Center for Critical Internet Inquiry dell'UCLA, nel libro Algorithms of Oppression basato su 6 anni di ricerche, ha esplorato come le ricerche su Google, utilizzando parole tipo “black” o “ispanic”, producono risultati che possono riflettere e rafforzare i pregiudizi della società nei confronti delle persone emarginate. I motori di ricerca da un lato semplificano i fenomeni complessi dall’altro danno priorità ai profitti. Non si tratta solo di riflettere come uno specchio la società come si presenta, l’interazione con questa tecnologia può avere delle conseguenze su di noi. Ovviamente questo vale per tutti i media, come la televisione e i giornali, ma per le tecnologie digitali, data la scala e la novità, questi aspetti sono ancora poco esplorati e compresi.

La ricerca non si limita a presentare pagine web ma struttura la conoscenza, e i risultati recuperati in un motore di ricerca commerciale creano una loro particolare realtà materiale. Il ranking è esso stesso un'informazione che riflette anche i valori politici, sociali e culturali della società in cui operano i motori di ricerca... (Safiya Noble)

Rompere la bolla

Ma come funziona un motore di ricerca? Allo stato ne sappiamo davvero poco di queste tecnologie dalle quali in fondo dipendiamo. Del resto, essendo gli algoritmi proprietari non possiamo sapere con certezza come operano.

In sintesi un search engine (es. Google, Microsoft Bing) non fa altro che scansionare il web alla ricerca di pagine delle quali fa delle copie (cache) e le archivia in un indice. L’indice viene organizzato (classificazione o ranking) in base a specifici parametri dell’algoritmo in modo da cercare di comprendere qual è il contenuto più utile per gli utenti in risposta alle loro ricerche (query). A seguito di una query (un suggerimento per ottenere risultati più utili è di inserire più informazioni possibili, più parole chiave) l’algoritmo offre all’utente una serie di contenuti ritenuti più rilevanti tra quelli contenuti nell'indice. Tali contenuti sono classificati gerarchicamente in base ai parametri dell'algoritmo e anche ad ulteriori parametri che dipendono dall’utente: la posizione geografica (localizzazione), la lingua (impostata nel search engine), la cronologia delle precedenti ricerche (un risultato che ottiene un feedback positivo può avanzare nel rank; inoltre l’autocomplete dipende dalle precedenti ricerche) e così via. Il motore valuta se la pagina web ha usato le parole della query, quanto frequentemente sono contenute (se sono troppo frequenti è segno di manipolazione dell’algoritmo), se sono nella parte alta o bassa della pagina, e così via.

Insomma, il motore di ricerca approssima il risultato sulla base di una serie di assunti dipendenti dal modello algoritmico programmato (ogni motore ha un algoritmo differente, quindi i risultati possono essere differenti).

L’idea comune è che se due persone sedute vicine inseriscono la stessa ricerca su Google, ottengono risultati differenti, in quanto personalizzati (per questo alcuni suggeriscono di usare la modalità di navigazione in incognito per impedire la personalizzazione). Ma in realtà, come spiega Danny Sullivan di Google, i risultati del motore di ricerca, compreso i contenuti politici, raramente cambiano per le singole persone (Robertson, Lazer, Wilson, Auditing the Personalization and Composition of Politically-Related Search Engine Results Pages), mentre sono ottimizzati in base alla localizzazione (da non confondere con gli annunci pubblicitari che sono personalizzati, “tailored”). Non ha molto senso, ad esempio, offrire gli stessi risultati a persone che abitano in due Stati differenti, pensiamo alla ricerca “pizza”. Ma anche la ricerca per “terremoti” ha un senso differente a seconda di dove ci troviamo, le risorse in materia sicuramente variano. Ovviamente è sempre possibile che le differenze dipendano da una diversa versione della cache dell’indice, non ancora sincronizzata tra i vari server (cosa che comunque accade in secondi).

Manipolare l’algoritmo

Tutti vogliono essere al primo posto, per risultare pertinenti, autorevoli, di alta qualità su un dato argomento, così alcuni utenti cercano di “manipolare” l’algoritmo del motore di ricerca per far salire il posizionamento di un certo contenuto nell’indice, sia esso il sito della propria azienda che un contenuto politico per favorire un certo candidato. Alcuni cercano di farlo semplicemente migliorando i contenuti, altri invece provano a ingannare il motore. Una delle tecniche, nota come "Google bombing", ha avuto vittime illustri, come l’ex presidente del Consiglio Berlusconi e l’ex Presidente Usa Trump.

Il SEO (Search Engine Optimization) non è altro che una serie di tecniche per “ingannare” l’algoritmo, e tecniche simili sono utilizzate dai “manipolatori”. Ovviamente gli architetti del search engine raffinano l’algoritmo per impedire le manipolazioni del motore di ricerca in una continua lotta con i “manipolatori” (dopo le modifiche all’algoritmo del 2007, ad esempio, il "Google bombing" è molto più difficile da attuare).

La manipolazione dei risultati di ricerca è un processo di miglioramento continuo delle tecniche. Se cerco “pillola del giorno dopo” (morning after pill) per anni uno dei primi risultati è stato morningafterpill.org che in realtà è un sito anti-aborto e anti-contraccezione. Su temi estremamente divisivi non solo a livello sociale ma anche politico, la lotta alla manipolazione è costante e continua, cercando di reindirizzare le ricerche verso il proprio campo ideologico (da aborto ad adozione, per esempio), con ciò tentando di modificare la visione del mondo degli utenti.

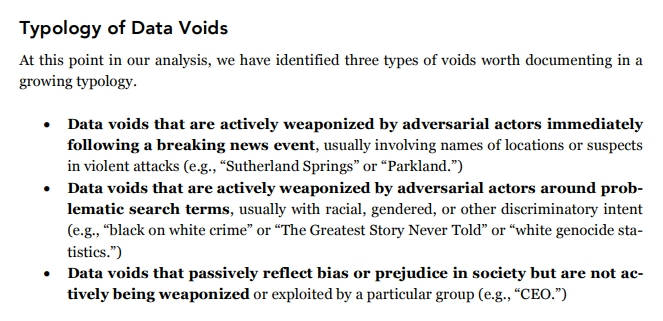

Un altro esempio sono i “data void”, un termine coniato da Michael Golebiewski e danah boyd che nel report Where missing data can easily be exploited lo relazionano, tra l’altro, alle breaking news. Quando non ci sono fonti dell’evento (data void, vuoto di dati) ma c’è un picco nelle ricerche il search engine si rivolge alle fonti alternative. Se i “manipolatori” si sono attrezzati preparando delle spiegazioni di comodo (quindi pagine web o video o contenuti sui social), il motore di ricerca in mancanza di altro non può che offrire quelle fonti.

Leggi anche >> Le breaking news e la manipolazione dell’opinione pubblica

Non è un problema del search engine che svolge il suo ruolo (quello di cercare notizie non di crearle), il problema è che chi deve riportare le notizie non lo fa nel modo giusto, affidandosi per la fretta, per non bucare la notizia, a fonti terze spesso non verificate. I media tradizionali quando non sanno cosa pensare di un evento si rivolgono ai social (spesso Reddit e Twitter) e ai motori di ricerca, e in tal modo le fonti e le spiegazioni alternative emergono e vengono amplificate dai media mainstream. La disinformazione viene amplificata per lo più dai media tradizionali, per una certa autorevolezza che essi ancora offrono.

Questo non vuol dire che i motori di ricerca non debbano preoccuparsi del problema, in tal senso Google ha cercato di enfatizzare l’autorevolezza dei contenuti (es. biografia dell’autore) tramite un aggiornamento dell'algoritmo del 2018 (anche eventualmente a scapito della novità). Ma probabilmente non basta.

Politica identitaria

Google è stata accusata anche di fornire differenti risultati a conservatori e progressisti, ma ciò appare più dipendente dal punto di partenza per la ricerca delle informazioni (Eszter Hargittai, Beyond Logs and Surveys: In-Depth Measures of People's Web Use Skills), nel senso che le nostre inclinazioni politiche possono impedirci di “vedere” le informazioni con le quali non siamo d’accordo. Quando cerchiamo qualcosa che ha a che fare con la nostra identità molto spesso quello che davvero vogliamo sono solo conferme e connessioni con ciò che siamo, con le nostre storie profonde. Se cerco informazioni sugli immigrati potrei andare a vedere i link che portano a stranieri illegali e reati degli stranieri, oppure a storie di accoglienza, a seconda del mio modo di vedere le cose. E tale “polarizzazione” non la risolvo “uscendo” da Google, perché dipende principalmente dal mio modo di essere.

Le bolle di filtraggio sono spesso sovrastimate (il discorso sulle echo chambers è ormai di per sé una echo chamber) per svariate ragioni, tra le quali perché ci si concentra solo sul ruolo degli algoritmi senza considerare il ruolo che gioca l’utente nella ricerca delle informazioni, si paragona la situazione ad una idea astratta e utopistica dell’ambiente informativo invece di paragonarla all’ambiente informativo pre-internet dominato da giornali e televisione, molti degli studi collocano gli utenti in situazioni che offrono un numero di opzioni decisamente più limitato rispetto a quello reale. Le stesse query, i termini di ricerca utilizzati dagli utenti, riflettono la prospettiva politica. Spesso il digital divide viene visto esclusivamente in termini di accesso ad Internet, in realtà è anche un problema di valutazione delle informazioni ottenute. Le differenze socioeconomiche, il background culturale e l’ideologia politica influenzano enormemente come le persone cercano online e come interpretano le risposte che ottengono.

Per quanto Google possa indicizzare informazioni autorevoli o pertinenti in risposta ad una query, alla fine la ricerca dipende dalle parole che abbiamo inserito (keyword), se quello che diciamo a Google è che vogliamo leggere quel contenuto, Google non può fare altro che mostrarci quel contenuto. E come chi, ad esempio, guarda solo il TG di uno specifico canale, è inutile presentargli anche gli altri TG, se è quello e solo quello che vuole vedere. Google, come chiarisce Sullivan, non è un motore di verità, il suo ruolo è quello di ottenere informazioni valide, ma alla fine sono le persone che elaborano tali informazioni:

“Possiamo darti le informazioni, ma non possiamo darti la verità”.

Inferenza scritturale

“Per quello che posso, quando accadono le cose, cerco di capirle da solo, prima di leggere qualsiasi storia su di esse. Tanto, si sa, alla fine mentono tutti”.

Una costante dei nostri tempi è la sfiducia crescente nei media, giornali e televisione. Sempre più persone pensano che questi mentano, che i fatti non siano verificati, o addirittura falsi, per questo occorre incoraggiare le persone a pensare con la propria testa, a fare le proprie ricerche. Nell’era dell'individualismo spinto dove il singolo vale più del collettivo, è sempre più comune l’idea che chiunque sia in grado di raggiungere la verità con uno sforzo individuale.

Nello studio “Searching for alternative facts, Analyzing Scriptural Inference in Conservative News Practices”, la sociologa Francesca Tripodi descrive il processo di lettura delle notizie da parte di un gruppo di conservatori alla stregua della lettura della Bibbia nelle chiese evangeliche. È l’“inferenza scritturale”, un approccio che utilizza i testi primari come base per la verità: ad esempio, spacchettare un versetto della Bibbia per applicarlo alla vita moderna o fare affidamento sulla Costituzione quando si tratta del diritto di portare armi, oppure nel caso di Trump fare affidamento solo sulle sue parole e non sull’“interpretazione” dei media ritenuta inaffidabile (tanto, si sa, mentono tutti).

Lo studio di Tripodi nasce dall’idea di comprendere meglio le dinamiche che hanno portato all’elezione di Trump, e si è concentrato su gruppi di conservatori bianchi, dai quali è emersa una pratica comune: “Devi fare le tue ricerche, devi tornare alle parole”. È un processo di autocostruzione della verità, come una scatola di montaggio, laddove l’algoritmo di Google viene usato per confermare le proprie idee e porta ad un vero e proprio recinto ideologico. Le parole chiave inserite nel motore di ricerca cambiano drasticamente le informazioni che Google recupera e ti offre.

“Google funziona come controllo dei fatti”, dice uno studente. “Controllo un paio di siti e vedo quali somiglianze condividono, clicco su quelli in alto, so come funziona Google, prende le cose rilevanti e le mette in cima”.

Le ricerche su Google, dicono, raramente rivelano punti di vista alternativi. Ma, nessuno di loro considera che il modo di cercare influenza l’ordinamento algoritmico delle informazioni. Google viene usato per convalidare le proprie affermazioni, le proprie idee, la propria visione del mondo. Una prospettiva alternativa non viene nemmeno presa in considerazione.

L'approccio basato sul testo è utilizzato spesso dai leader della destra, che conoscono l’influenza che ha sul loro pubblico. Il riferimento costante è a “fonti originarie”, al fine di “verificare i fatti” e a non fidarsi dell’interpretazione dei media (i media mentono, i giornalisti nascondono la verità...). “Attingendo da una visione del mondo cristiana conservatrice, questi gruppi interrogano criticamente i messaggi dei media nello stesso modo col quale si avvicinano alla Bibbia”, spiega Tripodi nel rapporto. Non è solo un problema delle piattaforme, le persone sono profondamente coinvolte nel processo di creazione di significato, ed è impossibile separare l'alfabetizzazione mediatica dal contesto epistemologico e culturale in cui viene praticata.

"Just remember, what you are seeing and what you are reading is not what's happening" Trump says at the Veterans of Foreign Wars convention. pic.twitter.com/NWFsB8QV2g

— Vera Bergengruen (@VeraMBergen) July 24, 2018

È lo stesso concetto evidenziato da Jennifer Mercieca (Demagogue for President, The Rhetorical Genius of Donald Trump) alla base dell’elezione di Trump. In un periodo storico di forte polarizzazione in cui gli americani credono di non avere più nulla in comune con gli oppositori politici, Trump ha condotto una campagna progettata per aumentare la polarizzazione. In un periodo storico di estrema disillusione, nel quale gli americani ritengono che lo stesso governo sia sulla strada sbagliata e che chiunque altro avrebbe fatto un lavoro migliore nella gestione del paese, Trump ha condotto una campagna politica per aumentare la frustrazione e la disillusione. Insomma una campagna estremamente divisiva fatta per accentuare l’odio verso l’altro e alimentare le differenze e le incomprensioni, una campagna basata sull’idea che non bisogna fidarsi di nessuno (in particolare dei giornali, che mentono!). Trump in realtà non esorta i suoi seguaci a fare le proprie ricerche, quanto piuttosto si pone come narratore autoritario, fonte primigenia, colui che ha fatto le “sue ricerche” e ha raggiunto la verità. Da solo.

To Ted Cruz and fellow conservatives: Right now the greatest conservative principle is to defeat the Left and their party, the Democrats.

— Dennis Prager (@DennisPrager) July 21, 2016

Anche Dylann Roof fece le sue ricerche, con la query su Google “crimini dei neri sui bianchi”, e ha raggiunto la sua verità. Come egli stesso ebbe a dire, quella ricerca ha plasmato le sue convinzioni razziste. Portandolo a compiere una strage.

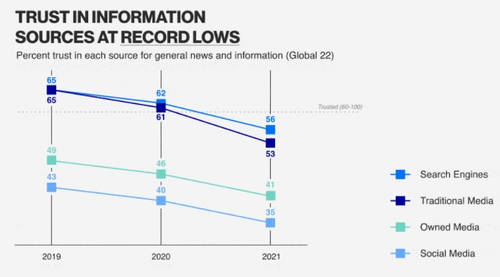

Googlare la verità

Spesso gli utenti hanno una percezione di Google come neutrale e obiettivo, perché la ricerca non è basata sui social (considerati quindi non obiettivi) e non è guidata da algoritmi di raccomandazione. Google è la fonte più affidabile secondo l'Edelman Trust Barometer, più dei media tradizionali, e quindi è spesso usata per “fare le proprie ricerche”, per costruirsi la “propria verità”. Ma questa pratica, anche se ben intenzionata può facilmente portare a conseguenze negative, a leggere solo le fonti che confermano le proprie convinzioni, le fonti che si allineano con la propria visione del mondo.

Come abbiamo già detto ci sono molti che provano a manipolare l’algoritmo di Google, e in questa arena alcuni media usano tale conoscenza a loro vantaggio per modificare le preferenze degli elettori, in particolare di quelli indecisi (Epstein, Robertson, Lazer, Wilson, Suppressing the Search Engine Manipulation Effect), proprio a causa della fiducia delle persone nel motore di ricerca. Secondo Wilson ciò non vuol dire che Google stia mostrando cose radicali (iper-partigiane), ma che se io sono già di quelle idee, andando su Google non considero quelle cose iper-partigiane, ma le prendo come un dato di fatto, la verità appunto.

Per comprendere meglio possiamo fare un esempio “estremo” seguendo le ricerche di Jonas Kaiser e Adrian Rauchfleisch. Secondo i due ricercatori l’algoritmo di raccomandazione di Youtube, partendo da canali politici e non, raggruppa una miriade di canali (fino a 13mila) che accomuna gli account di Fox News e la comunità di Alex Jones (noto cospirazionista) fino alla manosphere e a canali di estrema destra. Cioè, concludono i ricercatori, essere un conservatore su Youtube ti porta a soli due click di distanza dall’estrema destra, le teorie del complotto e i contenuti radicalizzanti.

Non dobbiamo, però, dimenticare che Youtube è un social e non un motore di ricerca, anche se ha in sé un motore di ricerca abbinato ad un algoritmo di raccomandazione. Ma è esemplificativo di come funzionano queste cose.

Riciclaggio narrativo

Non è il motore di ricerca che ti rinchiude in uno spazio monoideologico, quanto piuttosto è lo stesso utente che cerca e legge le informazioni che il search engine gli offre per rinchiudersi nella propria area di comfort, la propria bolla decisionale (Baekdal, The Filter Bubble is Actually a Decision Bubble) dove tutto ciò che legge è solo quello che conferma le sue idee, e che non metta in discussione l’intera nozione di verità che già conosce o crede di conoscere. I terrapiattisti sanno benissimo che ci sono miriadi di fonti che parlano della terra sferica, come i novax conoscono tutte le tesi sulla validità dei vaccini, perché passano gran parte del tempo a criticarle, non vivono in una bolla-filtro, ed esporli a idee diverse non risolve il problema (paradossalmente crea più problemi agli altri che si ritrovano un ambiente informativo strapieno di teorie e controteorie), anzi, conferma che quei siti (casomai giornali) che riportano idee differenti mentono. Perché non hanno fiducia in loro.

Il mercato delle idee, neologismo che riguarda la comunicazione intesa secondo il modello dell'economia liberista, in base al quale la libera concorrenza applicata alle idee farebbe emergere le idee migliori, è la pietra angolare della democrazia americana, e non solo. Ma Jennifer Mercieca, decodificando il discorso di Trump ci mostra come questo non sia più vero. Trump è solo l’ultimo anello di una catena che ha portato alla trasformazione della parola in un’arma, rivoltando la libertà di parola contro gli stessi valori americani e democratici.

La democrazia è costruita sul dialogo, sulla convinzione che anche dopo le aspre discussioni su politici e programmi, alla fine i cittadini usano il voto per decidere una direzione condivisa. La democrazia presuppone che la parte che perde accetti la sconfitta senza ritirarsi in una realtà alternativa dove il suo candidato ha vinto (StopTheSteal). Nessun tipo di moderazione sui social o modifica degli algoritmi potrà mai compensare l’incapacità dei più accaniti seguaci di Trump di vedere la realtà dei fatti. Anche oggi esistono milioni di persone in tutto il mondo (anche in Italia) che credono che Trump sia tutt’ora il legittimo Presidente Usa e ne attendono il ritorno alla Casa Bianca.

Varie soluzioni sono state proposte, ma istituire organismi che decidono per gli altri qual è la verità (più o meno come avveniva ai tempi dei giornali e della televisione, con gli editori quali filtro) non appare una soluzione valida né legittima (del resto porterebbe solo a spostare la disinformazione su nuovi canali, nuovi media, come Parler), piuttosto dare ai cittadini gli strumenti per comprendere come funzionano le nuove tecnologie (ma anche i media mainstream in generale) per potersi difendere dalla demagogia e dalla propaganda. Gli strumenti per ingannare i cittadini si stanno moltiplicando, non solo la propaganda (persuasione senza consenso secondo Mercieca), anche il riciclaggio narrativo (es. Trump che fa da eco, amplificandole, alle idee cospirazioniste di Alex Jones), cioè il comportamento di chi inserisce narrazioni sporche per farle scorrere attraverso più fonti all’interno dell’intero ciclo informativo (non accade solo negli Usa ma praticamente in quasi tutti i paesi, compreso l'Italia), alla fine risultandone pulito perché tali narrazioni non sono a lui riconducibili immediatamente, ma sono diventate proprie del ciclo informativo (in pratica sono state recepite e amplificate dai media mainstream).

Come sostengono Steven Levitsky e Daniel Ziblatt (How democracies die: what history reveals about our future) le democrazie non muoiono sempre con un bang, ma più spesso giorno dopo giorno, per mano di funzionari regolarmente eletti, che progressivamente rifiutano di rispettare le regole democratiche, negano la legittimità agli oppositori politici e le libertà civili di coloro che non fanno parte della loro cerchia, tollerano o addirittura incoraggiano la violenza contro gli “altri”. Il primo passo si ha quando la paura, l’opportunismo o l’errore di calcolo portano i partiti tradizionali a inserire gli estremisti nel ciclo mainstream, casomai credendo di riuscire a contenerli.

I motori di ricerca sono neutrali? È colpa dei motori di ricerca il pervertimento dell’ambiente informativo? O forse noi stessi, incapaci di comprendere il funzionamento dei mass media e le tecniche dei manipolatori, siamo complici per la circolazione della propaganda? A nessuno piace l’idea di essere manipolato, ognuno di noi è convinto di essere in grado di capire le cose, ma il modo migliore per manipolare le persone è fornire loro gli strumenti perché credano di arrivare alle conclusioni da soli, così che sembrerà una loro idea, e se ne convincano più facilmente. Anche un mobile scadente, se lo monti da te, lo apprezzi sicuramente di più.

Immagine in anteprima via Pixabay.com