Intelligenza artificiale e riconoscimento facciale: perché la società della sorveglianza digitale non è più accettabile

35 min letturaLa rivoluzione deve ancora cominciare, ma il totem è già stato abbattuto. Accade il 24 agosto, a Hong Kong, in un sabato di protesta che segue a molti altri. Nel video, circolato ovunque in rete, ci sono manifestanti vestiti principalmente di nero. Si coprono il volto con maschere e indumenti, quando non bastano gli ombrelli, l'oggetto-simbolo della volontà di interporre uno strato di stoffa tra l'occhio dello Stato e il proprio spazio personale, che è uno dei grandi motori della rivolta. Un ragazzo armeggia con una flex mentre altri, con e senza tiranti, circondano elettrici un palo della luce "intelligente".

Nella città ne sono previsti 400, di cui 350 in arrivo. Ma per i manifestanti, in lotta col governo cinese per ottenere libertà di pensiero e democrazia, sono l'incarnazione di quello sguardo del potere a cui hanno ben compreso sia indispensabile sfuggire. Perché, dicono, quei pali sarebbero dotati di tecnologie di riconoscimento facciale.

Leggi anche >> I problemi e i rischi del riconoscimento facciale tra Cina e resto del mondo

“Quello non è un lampione”, afferma un tweet virale di un manifestante, “è un lampione intelligente dotato di videocamera e tecnologia di riconoscimento facciale. Consentono di sorvegliare Hong Kong, e dunque i manifestanti. Di conseguenza i manifestanti li stanno abbattendo”. “Le informazioni dei cittadini di Hong Kong vengono già estradate in Cina, dobbiamo essere molto preoccupati”, raccontano altri all'ABC. Altro che misurare la qualità dell'aria o l'intensità del traffico, come si limitano a dichiarare le autorità di Hong Kong: quella luce significa essere costantemente monitorati e riconosciuti dagli algoritmi, prima, e dai funzionari, poi, di un regime autoritario. Per questo bisogna proteggersi, celare la propria identità in ogni modo. Per questo quel palo, apparentemente innocuo, va distrutto.

Nessuna motosega azzera un regime, certo, ma il gesto è simbolico. Nel video condiviso da Jordan Sather su Twitter, oltre 14 milioni di visualizzazioni da solo, si vede benissimo: abbattere quel palo della luce significa segare il tronco da cui si alimenta il potere repressivo delle autorità cinesi; quantomeno, dare forma al desiderio di farlo. Significa dire, come si è letto sempre su Twitter in una deliziosa parafrasi del manifesto di Gil Scott-Heron, "the revolution will not be facially recognised".

O meglio: che è cominciata la lotta per impedirlo. Dall’inizio della protesta contro la nuova legge sull’estradizione, i manifestanti hanno regolarmente preso d’assalto, spray alla mano, telecamere a circuito chiuso, a partire, lo scorso luglio, da quelle fuori dagli edifici governativi. Già allora avevano scelto di coprirsi il volto con mascherine e caschi, usare chat cifrate per comunicare in modo sicuro, chiedere regolarmente: “No photo”. Gli esperti dicono: lasciate a casa i cellulari. È la rivolta dell’era della sorveglianza digitale di massa, la rivolta contro lo “smart” al servizio della repressione. Una battaglia all'interno di una guerra lunga e appena cominciata, il cui esito è tutt'altro che scritto.

E in cui, tra i nemici, figura il riconoscimento facciale. Lampioni-spia o meno, i manifestanti hanno ragione a preoccuparsi. A quanto sappiamo il governo di Hong Kong, infatti, usa eccome il riconoscimento facciale per controllare i propri cittadini. BuzzFeed per esempio ha visionato centinaia di pagine prodotte dal Dipartimento Logistica del governo in risposta a richieste passate di accesso agli atti, scoprendo che il riconoscimento facciale è in uso in “almeno” tre casi: è collegato con il chip biometrico della carta d’identità dei residenti, viene utilizzato nei passaporti e per l’ingresso nel paese.

E così ci si copre, come si può. Si parla insieme al riparo degli ombrelli, organizzando le prossime mosse. Ma cosa vieta di pensare che alcuni poliziotti si siano infiltrati tra i manifestanti, solo per fotografarli a tradimento, e fornire così l'immagine al proprio database, verificando all'istante l'identità del bersaglio? In molti tra i manifestanti lo pensano, e lo riportano ai media. Il New York Times arriva a scrivere che "manifestanti e polizia hanno trasformato l'identità in un'arma". Ed è vero. Identità, armi, diritti: tutto viene comunque ridotto a dati e analisi di dati.

Anche se i manifestanti intenti a calpestare la carcassa di una centralina "smart" non lo possono sapere, le immagini rimbalzate su tutti i media, vecchi e nuovi, del semplice gesto di abbattere un lampione hanno il potere delle statue dei dittatori che crollano. Annunciano che qualcosa di fondamentale sta accadendo. Dan Gillmor, osservatore esperto delle dinamiche mediatiche e sociali, ne fa il fondamento per sostenere che quei manifestanti "sono molto avanti rispetto a noi nel comprendere il pericolo per la libertà rappresentato dal riconoscimento facciale".

Ed è vero. Ma c'è di più: quando si amplia lo sguardo allo scenario globale, si comprende che anche molti di "noi" sono piuttosto "avanti" nella comprensione di quel rischio terribile.

Quelle immagini ci dicono che per una parte della collettività, piccola o grande qui poco importa, la società della sorveglianza digitale non è più accettabile, è territorio di scontro politico aperto, di contestazione sociale. E il riconoscimento facciale, che ne è ingrediente indispensabile, non è più la norma, qualcosa che si può imporre alla cittadinanza con noncuranza, senza dibatterne in modo democratico prima, e senza pensare alle conseguenze che produrrà nel tessuto sociale e nella vita di ogni individuo.

C'è stato un tempo in cui si giustificavano progetti pilota a base di algoritmi di "facial recognition" a partire da quel modo di pensiero, e di potere, tipico della Silicon Valley che Shoshana Zuboff riassume nel termine "inevitabilismo": cioè l'idea – che per l'autrice di Surveillance Capitalism è una "ideologia" – per cui è la tecnologia a imporre i suoi cambiamenti all'uomo, non viceversa. Astratto? Per nulla. Perché la conseguenza logica è sottile, e sinistra: se il riconoscimento facciale è una necessità, una naturale e inevitabile conseguenza dello sviluppo tecnologico, che senso ha opporvisi?

Al massimo la si potrà "regolare", come infatti chiedono tutti i CEO dei principali colossi tecnologici. Ma non metterla al bando.

Ma quel tempo è finito, e i pochi secondi raccontati in quel video di protesta a Hong Kong dicono chiaramente perché: non importa nemmeno più che il riconoscimento facciale, poi, ci fosse davvero. Importa che basti il mero sospetto ad accendere le flex.

La sola possibilità del controllo motiva una rivolta per eliminarlo. Il Panopticon sembra finalmente essersi rovesciato contro se stesso. E ora ad avere paura è chi osserva, non chi è osservato. Perché le voci che si levano in protesta contro il riconoscimento facciale si stanno moltiplicando in tutto il mondo, su diversi fronti e con risultati già importanti.

Voci che chiedono non regole, ma divieti: che il riconoscimento facciale sia vietato fino a nuovo ordine, e per intanto sia vietato. Subito.

Voci, poi, che insinuano un dubbio anche più profondo: e se un mondo senza riconoscimento facciale fosse non solo possibile ma stesse, anzi, già accadendo?

Il mito degli algoritmi infallibili, imparziali e oggettivi

Il riconoscimento facciale nella vita di tutti i giorni

Regolamento facciale e forze dell'ordine: quali sono i rischi

La nascita dei movimenti di protesta

"Possiamo vivere senza essere uno Stato di sicurezza"

Riconoscimento facciale e discriminazioni

Cosa dovrebbero fare le grandi aziende della Silicon Valley

Il mito degli algoritmi infallibili, imparziali e oggettivi

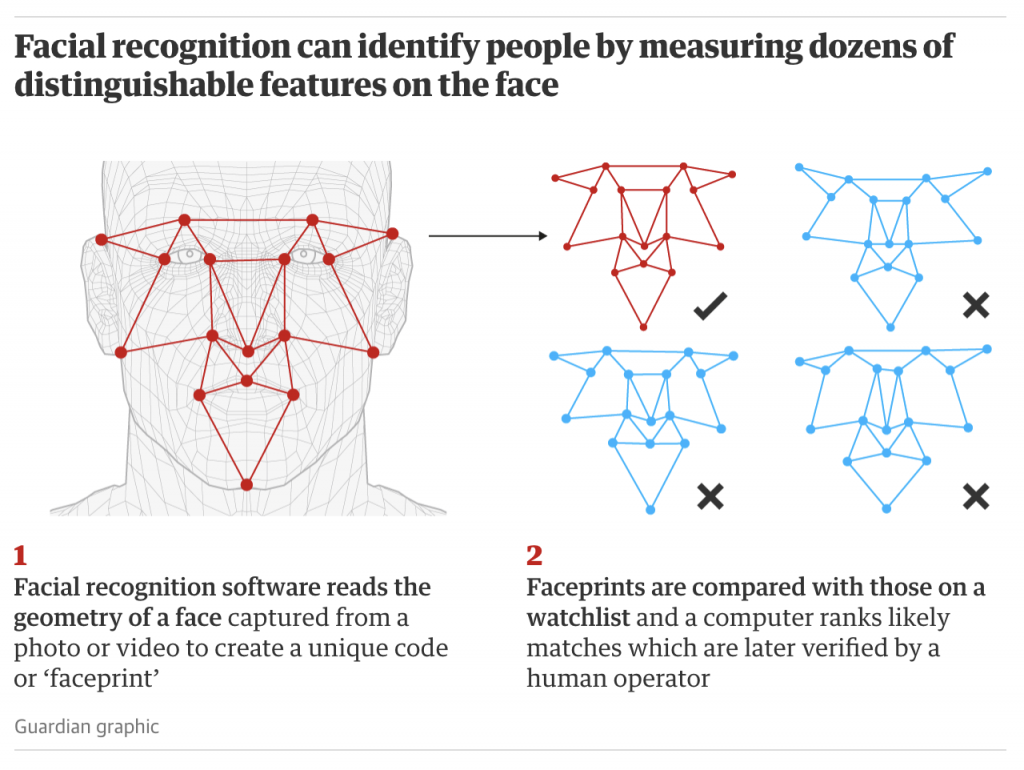

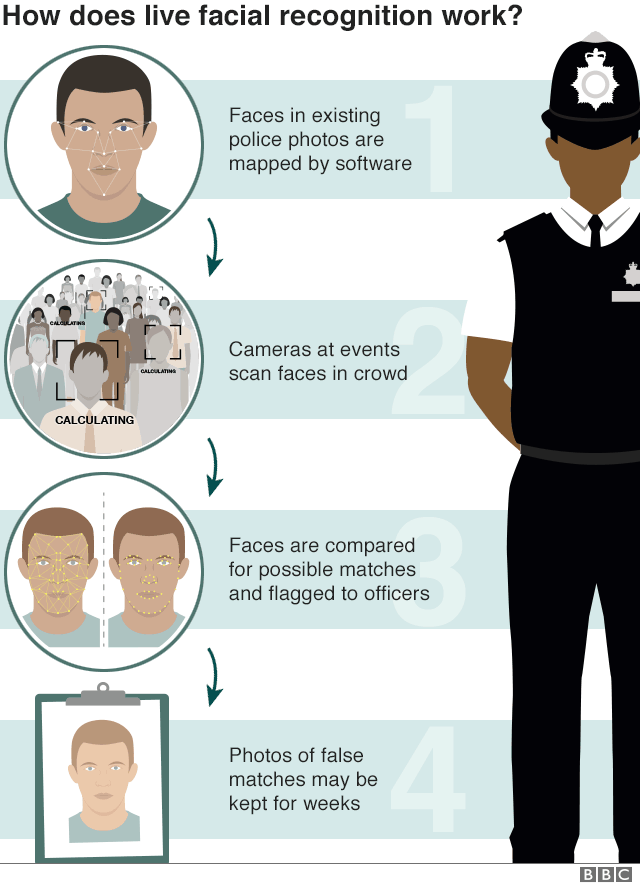

La fede nel riconoscimento facciale si basa su un assunto tanto semplice quanto errato: che sia possibile per un'immagine descrivere se stessa. L'idea è elementare. Un software mappa i volti presenti nei database per esempio delle forze dell'ordine, ricavandone una "impronta facciale" che viene poi confrontata con le facce analizzate in tempo reale di individui presenti a un concerto o a una manifestazione, o di chiunque passi per una certa strada. Questo dovrebbe, secondo i proponenti del riconoscimento facciale, permettere una identificazione rapida e precisa, consentendo di realizzare un duplice obiettivo: ottenere più sicurezza per i cittadini e un utilizzo efficiente delle sempre troppo scarse risorse a disposizione dello Stato o dell'amministrazione locale di turno. Più volti ci sono, più gli algoritmi imparano a riconoscere meglio altri volti. Certo, ammettono perfino i sostenitori più convinti, a volte ancora sbagliano, ma "grazie ai progressi sbalorditivi dell'intelligenza artificiale" presto saranno infallibili.

Oltre che neutrali, imparziali, oggettivi, naturalmente. Perché senza questa altrettanto semplice e fallace premessa, il discorso non regge. Chi mai vorrebbe demandare l'identificazione di un terrorista a un computer che prende le decisioni sbagliate? E chi mai si fiderebbe di un algoritmo in uso alle forze dell'ordine dotato di una propria agenda politica?

Nessuno, naturalmente. È solo finché si suppone, erroneamente, che gli algoritmi e il software siano apolitici che si può credere che installare sistemi di riconoscimento facciale in una scuola o in un aeroporto siano pure e semplici scelte amministrative o di business, che nulla hanno a che fare con democrazia e diritti dei cittadini. Solo finché regge questo inganno si possono inserire simili strumenti tecnologici nella gestione dell'ordine pubblico o nel sistema giudiziario senza alcun dibattito democratico o alcuna regola che ne indirizzi quantomeno lo sviluppo.

Perché non vorreste essere scambiati per un terrorista, o essere ri-arrestati per crimini che avete già scontato, o semplicemente vedervi negato ogni pagamento online perché vi siete rifatti il naso. E di certo non vorreste essere considerati più pericolosi della norma solo per avere la pelle nera. E invece è quanto realmente accaduto, e accade ogni qual volta si impiegano strumenti di riconoscimento facciale. Strumenti che, come vedremo nel dettaglio, producono discriminazioni sistematiche, specie a danno di categorie già vulnerabili: le donne, gli afroamericani, i "diversi" in genere. Che sbagliano su questioni cruciali per le esistenze di ogni individuo, in cui nessun margine di errore statistico dovrebbe essere tollerato. Che non sono affatto neutrali come vorrebbero i loro creatori.

E su questo, nessuno ha scritto parole più chiare e radicali di quelle di Kate Crawford e Trevor Paglen, nel loro progetto Excavating AI, una sorta di scavo archeologico dei pregiudizi annidati nei database composti in tutte le epoche, e a volte ancora usati per addestrare le intelligenze artificiali che abbiamo l'ardire di chiamare "intelligenti":

"Le immagini non si descrivono da sole. È una caratteristica che gli artisti hanno esplorato per secoli. Agnes Martin crea un dipinto a forma di griglia e lo chiama "Fiore Bianco", Magritte aggiunge al dipinto di una mela le parole "Questa non è una mela". Vediamo le stesse immagini in modo diverso a seconda di come vengono etichettate. Il circuito tra immagine, etichetta e referente è flessibile e può essere ricostruito in un qualunque numero di modi per fare cose differenti. Ancora più importante è quei circuiti possano cambiare nel tempo con il mutare del contesto culturale di un'immagine, e significare cose diverse a seconda di chi guarda, e di dove sono situati. Le immagini sono aperte a interpretazioni e re-interpretazioni.

Ed è questo in parte il motivo per cui i compiti del riconoscimento e della classificazione degli oggetti sono molto più complessi di quanto Minsky e molti dei suoi successori abbiano inizialmente immaginato.

Nonostante il comune mito per cui l'AI e i dati da cui attinge stiano categorizzando il mondo in modo oggettivo e scientifico, ci sono sempre politica, ideologia, pregiudizi e tutta la materia soggettiva di cui è fatta la storia. Nell'analizzare i training set (di dati, ndr) di più largo utilizzo, abbiamo scoperto che questa è la norma, non l'eccezione".

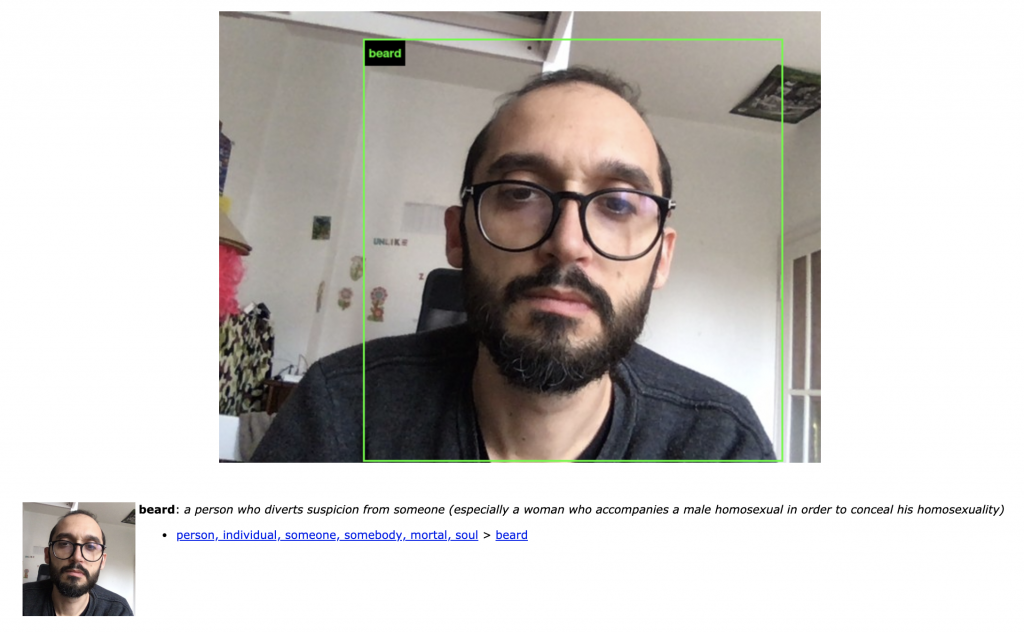

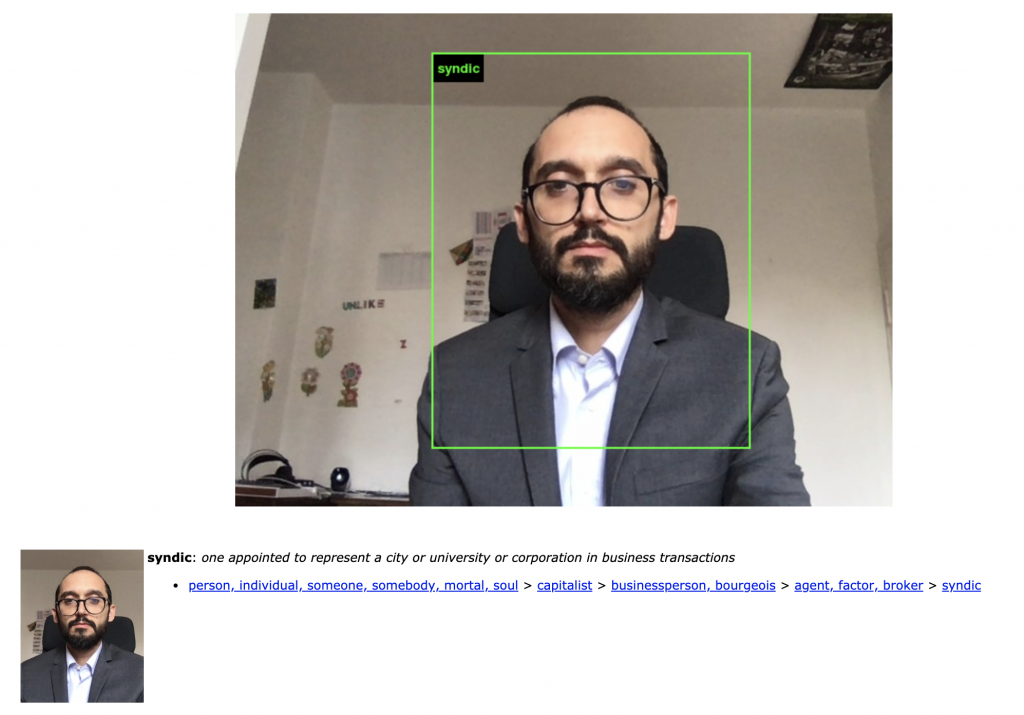

"Vediamo le stesse immagini in modo diverso a seconda di come vengono etichettate". È esattamente quanto dimostra ImageNet Roulette, il software-provocazione lanciato dagli stessi studiosi all'interno di un più ampio tentativo di sensibilizzare l'opinione pubblica sulle controindicazioni dell'AI attraverso l'arte, e che consentiva di associare un'etichetta ricavata da uno dei database di immagini più usati al mondo per affinare il machine learning, ImageNet, a una propria fotografia, scattata sul momento o presa da un proprio archivio. Nel mio caso, è bastato indossare una camicia e una giacca per passare, nel catalogo composto dall'algoritmo, da "copertura" ad "amministratore".

Questo è un gioco, ma il principio e i dati sono gli stessi per decisioni reali. E chissà quali conseguenze possono derivarne nella vita quotidiana, oggi come in futuro. Chi sa a quanti usi è sottoposta ogni analisi del mio volto? Chi è a conoscenza di tutte le etichette che i sistemi di riconoscimento facciale gli hanno attribuito, e di come vengono usate? Nessuno. Da cui una prima questione: la trasparenza, che fino a oggi non c'è stata per la semplice ragione che nessuno aveva avuto la forza politica per richiederla.

Ma se l'intelligenza artificiale è dunque politica, e se è sempre il prodotto di intenti e criteri umani, allora, piuttosto che un inevitabile miracolo di progresso che si autoregola, è più ragionevole aspettarsi dal riconoscimento facciale tutto quello che da sempre si accompagna all'umano: conflitti di potere, abusi, discriminazioni, il tentativo costante di spacciare il nuovo per il giusto. E, insieme, una lotta politica e ideologica in cui in ballo è il diritto stesso di esistenza di queste tecnologie.

Quella che stiamo testimoniando in questo frangente cruciale della storia del riconoscimento facciale, in cui le notizie si affollano come su di un campionato giunto nel vivo. Notizie come queste, che domani potrebbero venire da ogni classe di ogni scuola del pianeta.

Il riconoscimento facciale nella vita di tutti i giorni

A maggio 2019 il Guardian racconta la sperimentazione avviata nel distretto scolastico cittadino di Lockfort, nella parte occidentale di New York. Protagonista è un sistema di riconoscimento facciale chiamato "Aegis", unico nel suo genere: contrariamente a quelli installati in altri sistemi scolastici del paese, non si limita all'ingresso dell'istituto, ma, classi escluse, è presente e attivo in tutto l'edificio.

Di fatto, è il sistema più invasivo mai realizzato negli USA, essendo predisposto per "riconoscere i volti degli individui a cui è proibito l'accesso alle scuole di Lockport, i molestatori sessuali, gli studenti sospesi, i membri dello staff e chiunque sia ritenuto pericoloso, così da allertare le autorità se scoperti all'interno delle strutture scolastiche. Il sistema è anche in grado di riconoscere le armi", si legge, lasciando la spiacevole sensazione che gli sperimentatori stiano immaginando anche, forse soprattutto, una soluzione al problema degli omicidi di massa nelle scuole americane senza regolamentare in modi ben più stringenti il possesso di armi da fuoco.

Gli scettici argomentano che senza avere già identificato il potenziale attentatore il sistema non servirebbe a nulla, e basterebbe comunque indossasse una maschera per renderlo totalmente inutile. Ma la replica della sovrintendente non è esattamente un invito al dibattito: "Sarà pure controverso, ma non è proibito".

Non per ora. Altri paesi, infatti, stanno cercando di trovare la quadra per il difficile connubio tra riconoscimento facciale e sistema scolastico. In Cina si è già fatto il passo oltre. Il completamento di Aegis: il riconoscimento facciale usato non fuori dalle classi ma in classe, per studiare, analizzare e correggere l’attenzione degli studenti durante le lezioni.

L'incipit della cronaca del Telegraph si legge come un romanzo distopico: "Ogni movimento degli studenti del Liceo Numero 11 di Hangzhou nella Cina orientale è osservato da tre videocamere posizionate sopra la lavagna". Il "sistema di gestione intelligente del comportamento in classe", o "occhio intelligente", prosegue l'articolo, è stato sperimentato prima in una classe, e poi in tutto l'istituto. Il software mira a identificare le emozioni espresse dai volti dei ragazzi, darle in pasto a un computer e poi fargli giudicare se sono concentrati sulla lezione in corso oppure se le loro menti vagano altrove.

E alcuni comportamenti degli studenti stanno già cambiando. Almeno, a sentire la propaganda governativa: "Prima durante le lezioni delle materie che non mi piacciono impigrivo e magari mi facevo una dormita sul banco, o sfogliavo altri libri di testo", dice uno studente a un sito gestito dal governo, "ma ora che ci sono le videocamere in classe non oso distrarmi. È come se un paio di occhi misteriosi mi guardasse costantemente". Che sia vero o meno, il fatto che sia il risultato deliberato e addirittura propagandato con orgoglio di un programma governativo fa comprendere quanto distante sia il sistema cinese da un sistema democratico.

Ma nella lista degli sperimentatori del riconoscimento facciale a scuola figurano anche paesi saldamente appartenenti al novero delle democrazie, a partire da quello che ne ha concepito la sua forma moderna: la Francia. Qui, la città di Nizza è stata descritta recentemente da Politico Europe come "il laboratorio del riconoscimento facciale". Con 2600 videocamere di sorveglianza disseminate in tutto il territorio cittadino, e soprattutto la proposta di una sperimentazione nel liceo Les Eucalyptus, a cui si aggiunge quella in un altro istituto di Marsiglia, il titolo è meritato. L'ingresso a scuola avverrebbe dunque per riconoscimento biometrico previo consenso degli studenti, e la tecnologia verrebbe dal colosso statunitense Cisco.

Qualcosa di simile è stato tentato anche in Svezia: una scuola nel nord del paese aveva lanciato un programma pilota per tenere sotto controllo il tasso di assenze scolastiche degli studenti tramite un sistema di riconoscimento facciale. Il test aveva riguardato una sola classe, ma il Garante per la protezione dei dati personali svedese è intervenuto comminando una multa di circa 20 mila euro all'amministrazione cittadina, perché avrebbe processato i dati degli studenti in modo illegale e senza una adeguata valutazione d'impatto, preventivamente valutata con l'authority stessa. Insomma, il Regolamento europeo in materia di protezione dei dati personali (GDPR) sembra conoscere per la prima volta un ulteriore ambito di applicazione.

Questo del riconoscimento facciale nelle scuole è solo uno dei molteplici esempi possibili per far comprendere quanto queste tecnologie siano già presenti nelle nostre vite quotidiane. Il riconoscimento facciale, come quello di FaceWatch, è presente in sempre più supermercati per identificare “soggetti attenzionati” e chiedere gentilmente che escano dal negozio prima ancora che possano compiere un reato, ammesso (e non concesso) che lo avrebbero poi compiuto davvero. Lo stesso sistema, ha scritto la ricercatrice Stephanie Hare in un editoriale sul Guardian, sarebbe stato usato per identificare soggetti presenti nelle watchlist della polizia, e in procinto di finire alla polizia Metropolitana e a quella della Città di Londra, di Hampshire e del Sussex. Il software sarebbe stato anche testato in catene di supermercati in tutta la Gran Bretagna, per eventi di rilievo e "perfino in una prigione", e adottato, si legge, "in stadi di calcio, centri commerciali e palestre in Brasile", all'insaputa e senza il consenso dei cittadini.

Il riconoscimento facciale sta spopolando poi anche nei campi estivi per i più giovani, che vengono continuamente fotografati, identificati, e valutati dai genitori tramite app come Bunk1. Il sistema prevede infatti l'invio costante di foto che accertino lo stato psicofisico e umorale del figlio ai genitori, così che possano interagirvi o richiedere le attenzioni dei gestori se lo vedono infelice o giù di corda. Dando a questo modo luogo a uno strano fenomeno: ragazzi in pose innaturalmente sorridenti davanti al fotografo o alla telecamera, al fine di avere una speranza di essere lasciati in pace dai genitori. Ma hanno poche chance: sarebbero già 100 infatti i campi estivi che avrebbero sottoscritto accordi per implementare soluzioni di riconoscimento facciale.

Usi privati, usi pubblici. E altri, individuali, degni di Black Mirror. Il più eclatante viene forse dall'est della Cina, dove un uomo di 29 anni è stato scoperto a inquadrare il volto della compagna appena ammazzata dopo una lite per questioni di soldi, per accedere, tramite il riconoscimento facciale della app MoneyStation, a un prestito con le sue credenziali. Missione sventata proprio dal software, che dopo aver notato la completa assenza di movimenti oculari da parte del richiedente, ha inviato i dati biometrici per la domanda di prestito a revisori umani, il cui successivo approfondimento ha individuato lividi e “un profondo segno rosso intorno al collo” della donna, proprio lì, dove la corda l’aveva strangolata. Quando le forze dell'ordine sono arrivate sul posto, hanno trovato il ventinovenne intento a bruciare il cadavere della donna.

Il che ci costringe ad approfondire l'impiego forse più controverso di queste tecnologie: quello da parte proprio delle forze dell'ordine.

Regolamento facciale e forze dell'ordine: quali sono i rischi

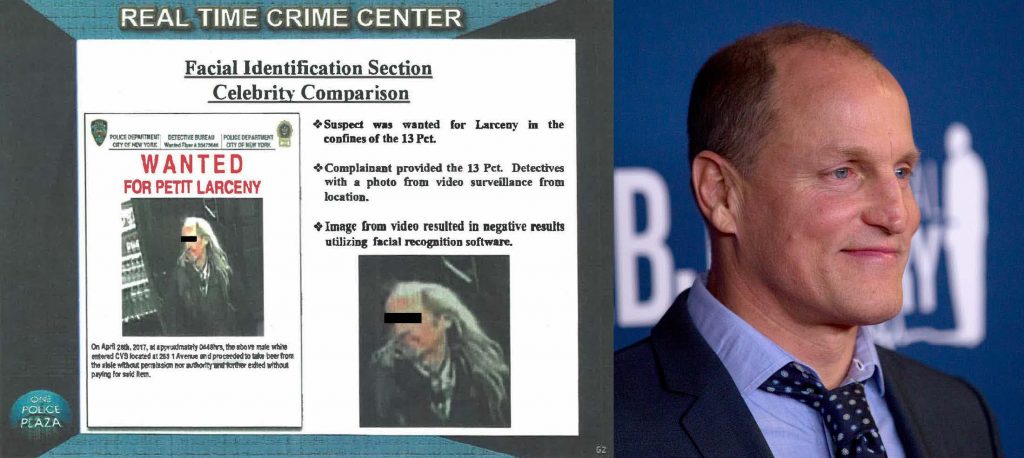

Il 28 aprile 2017, la polizia di New York deve affrontare una questione da nulla: un furto di birra da un CVS, la catena di negozi che in America significa beni di prima necessità, dal cibo ai farmaci. La faccia del ladro viene ripresa da una videocamera di sorveglianza, ma è parzialmente oscurata, e poco definita. Il sistema di riconoscimento facciale non restituisce risultati utilizzabili.

È allora che i detective, forse per noia, forse perché possono, diventano creativi: “Sembra Woody Harrelson!”, decide uno di loro scorrendo le immagini del sospetto, che si ostinano a non voler combaciare con quelle nei database. L'agente decide di mettere immediatamente alla prova la sua intuizione, scaricando foto ad alta definizione dell'iconico attore di Natural Born Killers e True Detective, e inserendole nel motore di ricerca dell'algoritmo di riconoscimento facciale.

Da quelle foto di Harrelson il sistema ricava deduzioni sul sospetto, in particolare una lista di possibili colpevoli. È infatti da lì che, infine, gli agenti decidono di estrarre quello che identificano come il colpevole vero e proprio, che dunque viene arrestato. Il sistema, studiato dal Georgetown Law Center on Privacy & Technology, viene definito dai ricercatori "garbage in, garbage out": pessima l'informazione in ingresso, pessime le conclusioni in uscita.

Che si usino foto di un attore di Hollywood per acciuffare un ladro di birre al supermercato è già degno di nota. Ma che questo, in assenza di regolamentazione, sia un metodo stabilito e replicato, che viene impiegato legalmente in "almeno una mezza dozzina di dipartimento di polizia in tutto il paese", fa comprendere anche meglio quanto pesi l'assenza totale di una regolamentazione per il settore.

Eppure è proprio sul terreno della "polizia predittiva" che si gioca in buona parte il futuro della battaglia per il riconoscimento facciale. Perché è qui che si vede con maggiore chiarezza la profondità e la delicatezza delle questioni che si vorrebbero demandare interamente o quasi agli algoritmi.

Le due posizioni in campo sono piuttosto chiare. Una parte la vorrebbe regolamentata ma ubiqua, mentre l'altra, opposta, la vorrebbe più semplicemente vedere messa al bando.

Ed è del resto alla richiesta sempre evasa di sicurezza che meglio si accorda il canto delle sirene dei produttori di riconoscimento facciale: se le casse per le forze di polizia sono sempre più desolatamente vuote, e se i cittadini si sentono sempre e continuamente minacciati e bisognosi di più sicurezza (perché accontentarsi quando la promessa è di sicurezza assoluta?), ecco il "soluzionismo tecnologico" bussare alla porta con le sue scintillanti bugie algoritmiche. Che si tratti di diminuire il crimine in una zona residenziale, sveltire le file in aeroporto o sventare il prossimo attentato terroristico poco importa: c'è sempre uno strumento di facial recognition in più a risolvere ogni problema.

È un trucco retorico, da televendita più che da partnership pubblico-privato, ma funziona. In Italia, c'è il sistema SARI, su cui attivisti ed esperti di privacy, oltre a un'interrogazione parlamentare, cercano inutilmente di fare chiarezza, mentre già il facial recognition aiuta la polizia a compiere arresti. L'Australia, è notizia di queste ore, sta predisponendo un "imponente" sistema di riconoscimento facciale che dovrebbe passare al vaglio anche patente di guida e passaporto di tutti i cittadini.

Anni di polemiche per il sistema di identificazione biometrico Adhaar, poi, non pare stiano impedendo all'India di Narendra Modi di progettare la realizzazione del "sistema di riconoscimento facciale per le forze dell'ordine più vasto del mondo", che mira a creare un sistema centralizzato che sia collegato anche a passaporti, impronte digitali e altre banche dati.

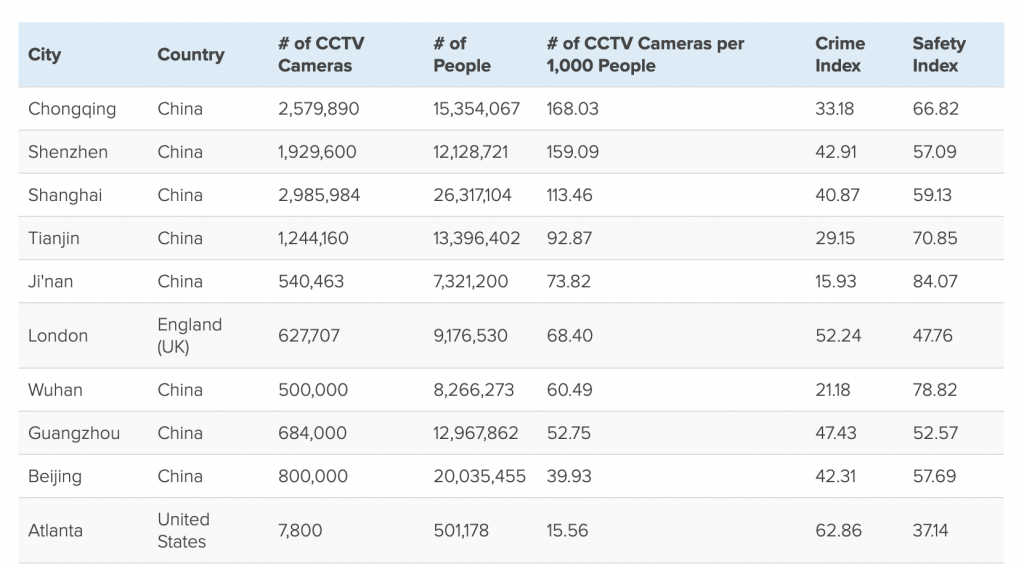

Per l'India significherebbe inseguire la Cina sul modello della schedatura biometrica totale. Dati alla mano, sono infatti città cinesi a occupare otto delle prime dieci posizioni tra le più videosorvegliate al mondo, dicono i recenti dati di Comparitech, con una telecamera di sorveglianza ogni due abitanti nel 2022 secondo le stesse stime. E se nella top ten rientrano le sole Londra e Atlanta (per l'Italia la più sorvegliata è Roma, 50esima), l'India già oggi occupa il ventesimo posto con New Delhi, 179.000 videocamere di sorveglianza, poco meno di una per ogni cento abitanti.

Ma è nel cuore dell'Occidente che si sta consumando lo scontro politico e, finalmente, ideologico più duro, negli Stati Uniti, e in Gran Bretagna soprattutto. Qui le notizie in materia di riconoscimento facciale assumono i contorni dei bollettini di guerra: attivisti, società civile, accademia uniti e determinati nel promuovere un ban, o quantomeno una moratoria, sugli usi governativi, amministrativi e per le forze dell'ordine; corti impegnate a dibattere la legalità di progetti pilota e non; colossi privati golosi di chiudere contratti con le istituzioni a ogni livello, che assicurerebbero ulteriori masse sterminate di dati con cui sviluppare nuovi e più precisi algoritmi. Nel mezzo il pubblico, che segue le cronache con apprensione, se i dati del sondaggio pubblicato a inizio settembre dall'Ada Lovelace Institute non mentono: il 55% degli interpellati negli UK chiede infatti leggi per l'uso di riconoscimento facciale da parte della polizia.

Non solo. Nemmeno gli usi descritti in precedenza sembrano particolarmente popolari, almeno tra il pubblico britannico. Solo il 17% ne approva l'uso per verificare l'età nei supermercati, percentuale che scende addirittura al 7% per il tracciamento degli acquirenti e al 4 per l'uso all'interno del processo di assunzione. Quanto all'impiego sugli studenti, il verdetto è impietoso: "Una larga maggioranza degli interpellati, il 70%, ci ha detto che le aziende 'produttrici' dovrebbero decidere volontariamente di non vendere tecnologia di riconoscimento facciale nelle scuole", e insieme promuovere uno stop alle vendite anche alle forze di polizia.

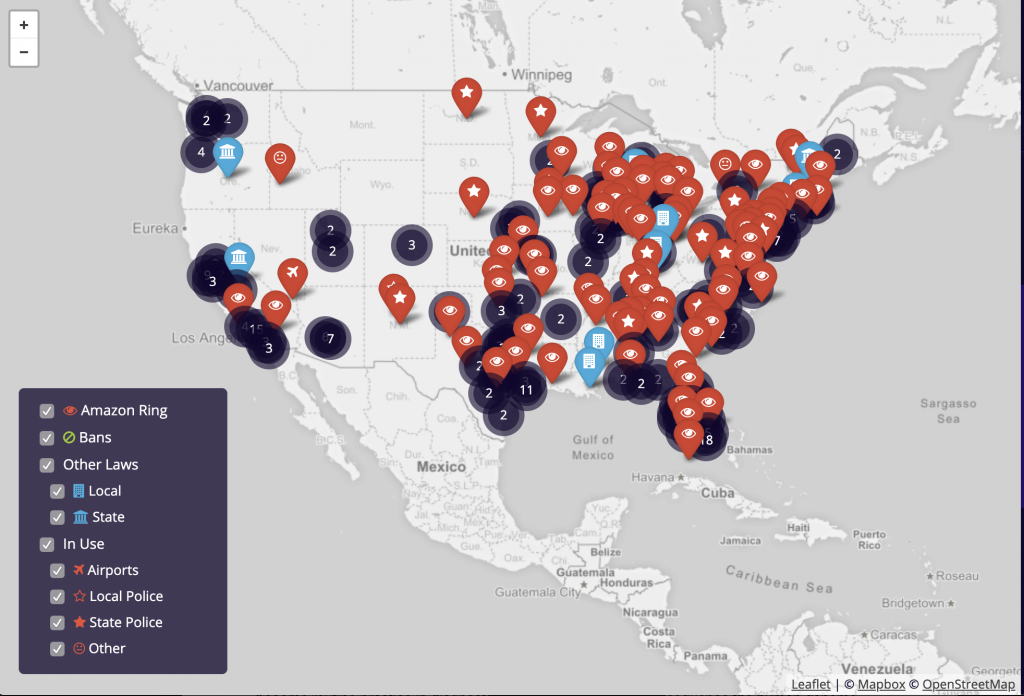

Eppure basta guardare la mappa dei sistemi di riconoscimento facciale attualmente in uso negli Stati Uniti, compilata dagli attivisti di Fight for the Future, per rendersi conto che la battaglia è lunga e insidiosa.

Come sia possibile è presto detto: Ring. Come scoperto dal Washington Post a fine agosto, l'azienda che produce campanelli intelligenti ha stretto accordi con 400 dipartimenti di polizia in tutti gli Stati Uniti affinché le forze dell’ordine possano avere accesso ai feed delle telecamere inserite nei campanelli per renderli, appunto, "smart". E trasformare ogni vicinato nel "new neighbourhood watch” d’America. Come?

Scrive Drew Harwell:"Gli accordi consentono alla polizia di richiedere automaticamente i video registrati dalle videocamere dei padroni di casa all'interno di una certa area e di un certo lasso temporale, aiutando gli ufficiali ad accedere al materiale prodotto dai milioni di videocamere connesse a Internet installate dall'azienda in tutto il mondo. Gli ufficiali non ricevono accesso a video in diretta, e i padroni di casa possono declinare le richieste, che Ring invia via email ringraziandoli per 'rendere il vicinato un posto più sicuro'"

E il riconoscimento facciale? Ring, di proprietà di Amazon, ha registrato almeno due brevetti che ne prevedono l'utilizzo, per consentire ai suoi device di riconoscere persone "sospette" nel vicinato e "allertare automaticamente le forze dell'ordine", scrive CNET. Certo, l'azienda ha dovuto incassare una pioggia di critiche, a partire dall'ACLU (American Civil Liberties Union): "Amazon sta sognando un futuro pericoloso". Ma la tecnologia c'è, e le condizioni per metterla in campo in molti casi pure. Niente impedisce di pensare che l'intenzione sia di farlo comunque davvero. Inevitabilismo, no?

"More than 10 million Ring doorbells have been installed worldwide, and BuzzFeed News found evidence that the company is working to develop facial recognition technology for its devices in Ukraine." https://t.co/7KlT6GH39Y

— Stephanie Hare (@hare_brain) August 31, 2019

E qui bisogna fermarsi un attimo.

Perché la critica dell'ACLU consente di andare oltre la descrizione del singolo caso di applicazione della tecnologia, e provare a immaginare che tipo di società avremmo se il mondo funzionasse davvero come "sognano" i produttori di facial recognition. Pensate a una tranquilla strada residenziale di Los Angeles, come quella a sud di Ventura Boulevard descritta dal Los Angeles Times di recente. Palme, insegne, strade larghe a più corsie hanno ceduto il posto alle vie strette circondate di giardini e verande, vegetazione curata e selvaggia fino ad abbracciare la strada come attraversandola in volo. Pensate se ciascuna di quelle case disponesse di un campanello-videocamera capace di riconoscere il volto di chi si presenta alla porta e comunicarlo istantaneamente alla polizia. Tutto registrato, ogni visita.

Se poi non bastasse, nel quartiere sarebbe in uso anche il sistema di lettura automatica delle targhe realizzato da Flock, capace secondo il LA Times di registrare in video chiunque attraversi quelle magnifiche strade circondate di verde, trasmettendo anche immediatamente il materiale alle forze dell'ordine.

A coronamento del tutto, gli abitanti del vicinato potrebbero condividere e discutere i rispettivi sospetti su un social network apposito, Neighbors, che sembra talmente uscito dalla penna di J. G. Ballard da risultare troppo vero per essere vero. Filmati di personaggi "sospetti" secondo il vicino, domande del tipo "perché questo sconosciuto è passato di qui tre volte con la sua macchina in meno di un'ora?" e segnalazioni di perfetti innocenti alla polizia compongono questa sorta di Facebook della delazione, in cui invece dei like si scambiano e condividono stigma sociali.

Questo è il messaggio culturale sotteso a chi propaganda l'adozione, indiscriminata o meno, del riconoscimento facciale come strumento di sicurezza e armonia sociale: paranoia by default.

E sta già accadendo, non è ipotesi di scuola. "Lo scorso Halloween nel sud del Maryland", ha scritto il LA Times, "un utente di Ring che vive nei pressi di una scuola media ha pubblicato un video di due ragazzi che suonano il campanello con il titolo: "Dolcetto o scherzetto prematuro, o hanno in mente qualcosa di losco?" Risultato: 5.700 visualizzazioni su Neighbors, e una ridda di commenti, tra cui naturalmente alcuni sospettosi sulle loro intenzioni.

E no, non è nemmeno un caso isolato: è il modello di business. "Il feed di Neighbors", scrive il Washington Post, "funziona come un flusso infinito di sospetti locali, che combinano rapporti ufficiali della polizia compilati dal "News Team" di Neighbors con ciò che Ring chiama post "iperlocali" fatti da padroni di casa nelle vicinanze che segnalano un furto di pacchi, rumori misteriosi, visitatori dubbi e gatti mancanti". L'azienda stessa ammette, e anzi vanta, che un terzo di tutti i post sulla piattaforma riguardano "attività sospette" o "visitatori sconosciuti". Un altro quarto ha a che vedere con "crimini". Il sospetto è ovunque, e la viralità lo nutre con la stessa naturalezza con cui si alimenta un flame sul post controverso del momento. La differenza è che qui, su Neirhbors, le segnalazioni non finiscono ai moderatori o agli algoritmi di Facebook, ma direttamente alla polizia.

Elizabeth Joh ha parlato, su Slate, di "ascesa del modello della Sorveglianza del Vigilante Connesso", ovvero quel che accade quando si fondono insieme, a forza tecnologica, "cultura delle startup, intelligenza artificiale e vicini impauriti". Per L. M. Sacasas questo slancio cooperativo nella delazione è segnale di un vero e proprio "divertimento partecipativo", anche se di un genere decisamente dark. A dire: avevano ragione Neil Postman e Aldous Huxley a scrivere che la distopia ce la saremmo costruita da noi stessi, non perché qualcuno ci avrebbe costretto, ma perché la desideriamo tanto, e non riusciamo a farne a meno.

Come quando Apple ce la infila in tasca, con Face ID, e d'istinto sospiriamo: finalmente.

#NeilPostmanWasRight, Huxley was the better prophet of our age. We will willing, gleefully even, build the dystopia ourselves given the tools, especially if it gives us dark new forms of participatory entertainment, which is how I'd characterize the Nextdoor experience. https://t.co/pbZLcMFzqx

— LM Sacasas (@LMSacasas) September 13, 2019

La nascita dei movimenti di protesta

Salvo che poi, invece, riusciamo a farne a meno eccome. E in molti cominciano a chiedere si debba farne a meno, interpellando la legge, mobilitando l'opinione pubblica, chiedendo di immaginare alternative di sistema.

È un movimento ancora nascente e multiforme, ma i segni della sua presa sull'immaginario collettivo si moltiplicano. Non ci sono solo i manifestanti di Hong Kong e la loro lotta al volto come arma, a dimostrarlo. C'è il successo virale e inaspettato del progetto-denuncia ImageNet Roulette ("i server ce la fanno a malapena", ha scritto Crawford). C'è l'inversione di rotta di Facebook, che ha deciso di declassare il riconoscimento facciale da opt-out (l'utente deve intervenire attivamente per sottrarvisi) a opt-in (l'utente deve scegliere di esserne sottoposto). E, tra i fenomeni di costume, c'è sicuramente la paranoia FaceApp, l'app-fenomeno del momento qualche mese fa, con il sospetto, infondato ma diffusissimo, che si trattasse semplicemente di un'operazione russa sotto falso nome per immagazzinare selfie di cittadini qualunque e, chissà, addestrarci gli algoritmi di riconoscimento facciale del Cremlino.

Il livello di contestazione sociale al facial recognition in ogni cosa è tale che perfino chi la usa per accelerare l'ingresso agli eventi, come Ticketmaster, rischia di trovarsi contro sia il pubblico che artisti del calibro di Tom Morello, celeberrimo ex chitarrista dei, nomen omen, Rage Against the Machine. L'idea della campagna coordinata dal gruppo Fight for the Future è evitare che uscite estemporanee come quella di Taylor Swift, che nel 2018 fece ricorso al riconoscimento facciale per setacciare gli spettatori a caccia di suoi stalker, diventino la norma.

Il che porta alle iniziative più propriamente dettate da azioni coordinate di attivismo. Già lo scorso anno una campagna contro Amazon aveva portato a una petizione da 150 mila firme, e a una lettera firmata da 70 organizzazioni, inclusa una degli azionisti dello stesso colosso di Jeff Bezos, per chiedere che l’azienda non fornisse il suo servizio di riconoscimento facciale Rekognition ad agenzie governative e forze dell'ordine. Come invece stava facendo, secondo documenti visti dall'ACLU. Che ha reagito, di nuovo, contestando le ambizioni di Amazon nella forma quanto nella sostanza:

"Storicamente, i dipartimenti di polizia hanno fatto ricorso a nuove tecnologie di sorveglianza senza attendere il giudizio della comunità o perfino che ci fossero leggi a governarne l'uso. Ciò è intollerabile con una tecnologia come Rekognition, che consente alle forze dell'ordine di esercitare una forma autoritaria di controllo, per giunta al buio. Non possiamo procedere ciecamente verso uno stato di sorveglianza a base di intelligenza artificiale, governato da corporation interessate a espandere i propri margini di profitto e da dipartimenti di polizia dediti a esercitare un potere senza limiti. La vera sicurezza pubblica, specialmente per persone di colore, musulmani, immigrati e dissidenti, richiede che si fermi la diffusione di sorveglianza facciale prima che sia troppo tardi"

In Gran Bretagna sono oltre 60 tra attivisti, studiosi, politici e legali a chiedere lo stop immediato del riconoscimento facciale per le forze dell’ordine e anche per gli usi commerciali. Ma è solo l'ultimo sviluppo di una battaglia lunga e complessa, che ha già visto vittorie di entrambi i contendenti.

Gli attivisti, impegnati in molteplici campagne di denuncia (per esempio contro "l'epidemia" di riconoscimento facciale in centri commerciali, musei e centri conferenze), hanno registrato con favore il rapporto con cui la Commissione per Scienza e Tecnologia della Camera britannica ha chiesto lo scorso luglio di sospenderne l'uso "fino a che le preoccupazioni inerenti l'inefficacia e i potenziali bias della tecnologia non siano state interamente risolte". Le parole del commissario Tony Porter riassumono perfettamente il senso di urgenza che la Commissione cerca di trasmettere: "Stiamo andando verso una società distopica in cui non si crede alle persone".

Dall'altro lato, sono i sostenitori del riconoscimento facciale a uscire vincitori dal verdetto emesso a inizio settembre dall'Alta Corte britannica, secondo cui l'uso da parte della polizia è legittimo: "Sufficienti controlli legali" consentirebbero agli utenti di vedere la loro privacy protetta anche se i loro volti vengono passati al setaccio in massa all'ingresso di una partita di rugby, o durante una passeggiata nel centro cittadino.

Nel mezzo, ci sono le indagini aperte dall'ICO, il Garante per la protezione dei dati personali inglese. A ferragosto ne era stata lanciata una per l'uso di riconoscimento facciale a King's Cross, nel centro di Londra; una sperimentazione su cui lo stesso sindaco, Sadiq Khan, aveva chiesto delucidazioni. La zona, come sanno perfino i turisti, è una delle più trafficate della metropoli, con un passaggio di migliaia di persone ogni giorno. Possibile nessuna debba essere informata che il proprio volto sta venendo analizzato dalla polizia?

La commissaria Elizabeth Denham dice che l'ICO è "gravemente preoccupato dal crescente uso di tecnologie di riconoscimento facciale in luoghi pubblici", ma di nuovo, siamo in guerra, e questo non ha impedito alla polizia londinese di annunciare il prossimo lancio della "rete di riconoscimento facciale più sofisticata al mondo".

L'intenzione, rivelata dal Daily Mail, è integrare le centinaia di migliaia di volti passati in rassegna già oggi tramite i sistemi in dotazione alle forze dell'ordine con la rete sterminata di videocamere di sorveglianza private disseminate in tutta la capitale britannica. Non dimentichiamo che, secondo i già citati dati di Comparitech, Londra è la sesta città più sorvegliata al mondo, con oltre 627.000 telecamere attive: 68 ogni 1000 abitanti. E ciononostante, la polizia vede il bisogno di compiere un "salto quantico" nel livello di sorveglianza della popolazione.

Anche questa bulimia di dati – che per quanti siano, non sono mai abbastanza – è tipica dell'approccio securitario a mezzo riconoscimento facciale. Una costante che ne rivela, di passaggio, gli istinti profondamente antidemocratici.

Il rischio, accettando l'inevitabile diffondersi di occhi digitali che ci guardano e analizzano in ogni dove, è normalizzarli. Rendere la sorveglianza totale parte integrante e naturale del panorama della democrazia contemporanea. Riconoscimento facciale ogni volta che si debba sbloccare lo smartphone. Riconoscimento facciale per entrare allo stadio, al museo, al supermercato o in ufficio. Riconoscimento facciale per autorizzare i pagamenti. Riconoscimento facciale in ogni aeroporto, come vorrebbe il ministero degli Interni UK, per sveltire il controllo passaporti. Ancora, riconoscimento facciale durante i colloqui di lavoro: un primo utilizzo è stato segnalato a Unilever, grazie a un software che "analizza linguaggio, tono ed espressioni facciali dei candidati", così da paragonarli con quelle di chi è stato assunto in passato. Dopo quanto equiparare la propria identità e i propri diritti al proprio volto cessa di essere un'anomalia da guardare con sospetto, e diventa, molto semplicemente, un'abitudine a cui rassegnarsi?

Senza una opposizione politica, ideologica, cedere è questione di giorni. Fortunatamente, anche da questo punto di vista le cose stanno rapidamente cambiando. Candidati progressisti e popolari tra le nuove generazioni, come Bernie Sanders e Alexandria Ocasio-Cortez, hanno espresso posizioni molto chiare in materia di riconoscimento facciale, riassumibili in un franco e diretto no, grazie. "Vietare l'uso di riconoscimento facciale per la polizia", si legge nella piattaforma per la candidatura alle presidenziali 2020 del senatore del Vermont. Non ci sono "ma": si vieta e basta. Ocasio-Cortez è andata perfino oltre, dicendosi non solo “assolutamente preoccupata” dal riconoscimento facciale, ma anche che potrebbe essere "legato alla realtà politica dell'ascesa di nuovi autoritarismi e fascismi".

Il tema però non è unicamente per socialisti. Al contrario, scrive Davey Alba su BuzzFeed News che potrebbe essere addirittura un tema su cui vedere per una volta convergere Democratici e Repubblicani, dato che entrambi gli schieramenti hanno chiesto ulteriori approfondimenti al termine dell’audizione dell’Oversight House Committee, tenutasi lo scorso maggio, sull'“impatto sui nostri diritti e libertà civili" proprio del facial recognition. Del resto,

"Non c'è un quadro normativo che limiti le applicazioni di questa tecnologia per le forze dell'ordine. Non c'è una casistica sviluppata né precedenti costituzionali che autorizzino l'uso di riconoscimento facciale da parte della polizia senza un mandato. E quando gli arresti vengono fatti sulla base di questa tecnologia, chi è arrestato non ne viene informato".

Difficile sostenere non ci sia nulla da rivedere.

Ciò che rende insieme più ambizioso e affascinante lo slancio politico contro il riconoscimento facciale è che, contrariamente ad altre tecnologie, non se ne chiede la regolamentazione: si chiede sia vietato, almeno fino a nuovo (e meglio informato) ordine. Per Evan Greer, a capo della rivolta degli attivisti, il punto infatti non è avere sistemi accurati. Se anche funzionassero perfettamente, sostiene, sarebbero comunque troppo pericolosi. Come si legge nei documenti della campagna banfacialrecognition.com, "la regolamentazione non è abbastanza": "come per le armi nucleari o biologiche, il riconoscimento facciale reca minacce alla società umana e ai diritti fondamentali che ne superano di gran lunga i benefici".

Parole forti, che comportano una rivoluzione. La notizia sorprendente è che esattamente quanto sta accadendo.

"Possiamo vivere senza essere uno Stato di sicurezza"

Se quella contro il riconoscimento facciale è una rivoluzione, il suo manifesto è l'ordinanza con cui, a maggio 2019, la città di San Francisco l'ha messo al bando per le agenzie governative.

Nel testo, scritto dal City Supervisor, Aaron Peskin, insieme a cinque colleghi, si leggono infatti principi generalizzabili a qualunque amministrazione intenda valutare l'adozione non di tecnologie di facial recognition, che viene proibita, ma di ogni forma di sorveglianza digitale:

"(a) È essenziale dare vita il prima possibile a un dibattito pubblico informato circa le decisioni legate alle tecnologie di sorveglianza.

(b) Ogni qual volta sia possibile, le decisioni riguardanti tecnologie di sorveglianza dovrebbero essere prese dando attenta considerazione all'impatto che quelle tecnologie possono avere su diritti e libertà civili.

(c) Fermo restando che le tecnologie di sorveglianza possono mettere a repentaglio la privacy di tutti noi, le iniziative di sorveglianza, storicamente, sono state impiegate per intimidire e opprimere alcuni precisi gruppi e alcune precise comunità più di altre, incluse quelle che sono definite da una comune razza, etnia, religione, paese d'origine, livello di reddito, orientamento sessuale o visione politica.

(d) La propensione delle tecnologie di riconoscimento facciale a mettere a repentaglio diritti civili e libertà civili va ben oltre i suoi presunti benefici, e la tecnologia non farà che aumentare l'ingiustizia razziale e minacciare la possibilità di vivere liberi da un controllo governativo costante.

(e) Ogni qual volta sia possibile, le decisioni concernenti se e come tecnologie di sorveglianza debbano essere finanziate, acquisite, o utilizzate, e se i dati derivanti da quelle tecnologie debbano essere condivisi, dovrebbero essere prese solo dopo siano stati sollecitati, e attentamente valutatati, contributi significativi da parte del pubblico.

(f) Devono esistere tutele di legge a protezione dei diritti e delle libertà civili, incluse una significativa trasparenza e misure di accountability, prima che qualunque tecnologia di sorveglianza venga adottata."

Sono tutti principi di elementare ragionevolezza, per coniugare, differentemente da quanto fatto finora, sorveglianza e democrazia. Ed eliminarla, se il compito dovesse rivelarsi impossibile.

Le prescrizioni sono individualmente valide, ma è l'insieme a essere davvero degno di nota. Suggerisce che ciò che deve cambiare, prima di ogni singola decisione di policy, è l'atteggiamento culturale e politico verso la sorveglianza digitale, ciò che include il riconoscimento facciale come sottoinsieme. Occuparsene ne diviene una conseguenza naturale: se i criteri sono quelli, è evidente che nessuno degli esempi di sperimentazione raccontati qui li rispetta, e che di conseguenza vanno fermati.

Per questo Peskin dice bene quando racconta il significato profondo di quanto avvenuto a San Francisco: "Il messaggio è dire che possiamo avere sicurezza senza essere uno Stato di sicurezza. Che possiamo avere buona polizia senza essere uno Stato di polizia". Perché certo, il ban non impedirà l'uso del riconoscimento facciale all'aeroporto, né vieterà a soggetti e aziende private di continuare ad adottare e sviluppare soluzioni di riconoscimento facciale.

Ma lo smottamento potrebbe produrre una valanga. Subito dopo San Francisco, anche città come Somerville, nel Massachusetts, e Oakland hanno prodotti divieti per il facial recognition. In Ohio, una sperimentazione per le forze dell'ordine è stata interrotta. E leggi per dare alle amministrazioni locali più poteri per regolare i sistemi di sorveglianza sono state passate, scrive Recode, "in poco meno di una dozzina di città negli Stati Uniti", tra cui Nashville, Seattle e Cambridge.

A parlare per tutti è la presidente del Consiglio cittadino di Oakland, Rebecca Kaplan. Commentando la decisione, unanime, di mettere al bando il riconoscimento facciale per tutti i dipartimenti pubblici della città, e di vietare inoltre l’uso di informazioni comunque ottenute tramite quei software, ha espresso quella che potrebbe essere una splendida lezione di realismo per troppi politici e consulenti facilmente sedotti dalle spire ammalianti dell'automazione pubblica:

"Sono felice che i miei colleghi abbiano chiaramente compreso i difetti della tecnologia di riconoscimento facciale, questa volta. Io accolgo con favore le tecnologie che migliorano le nostre vite e semplificano il governo della città, ma quando svariati studi descrivono una tecnologia fallace, erronea, che sta arrecando effetti restrittivi senza precedenti alla nostra libertà di parola e religione, dobbiamo prendere una posizione".

Perché sì, la scienza oggi disponibile dice che il riconoscimento facciale non è solo una scelta insostenibile dal punto di vista dei diritti dei cittadini. È anche una cattiva scelta politica, economica e amministrativa: la scelta di affidarsi a un pessimo decisore, tra i cui tratti caratteriali emerge una chiara predisposizione a misoginia, islamofobia e razzismo.

Riconoscimento facciale e discriminazioni

Gli algoritmi e la questione di genere. Gli algoritmi e la razza. Gli algoritmi e la religione. Non dovrebbero c'entrare nulla: il riconoscimento facciale, lo abbiamo visto, viene venduto come una soluzione efficiente ma soprattutto neutrale. Identifica, senza giudicare; prevede, ma sulla base del passato e della statistica. Nessuna qualità morale dovrebbe competere al facial recognition.

E invece non appena si intacchi la superficie illibata dei comunicati stampa e dei grandiosi, utopici proclami di sicurezza, ecco apparire le asperità della politica. Dietro il giudizio, è apparso il pregiudizio. E a rivelarlo è stata la scienza.

Ormai non ci sono dubbi: il riconoscimento facciale discrimina. Qualche esempio? Uno studio del MIT del 2018 mostra che mentre l'identificazione avviene correttamente nel 99% dei casi per un maschio bianco, il tasso di errore sale fino al 35% per le donne di colore (titolo del New York Times: "Il riconoscimento facciale è accurato, se sei un uomo bianco"). Un altro, raccontato in anteprima dal Guardian e Sky News, secondo cui negli UK quattro su cinque dei sospetti identificati come tali dal riconoscimento facciale in dotazione alla polizia metropolitana sono in realtà innocenti: dei 42 "match" proposti dal software, solo otto si sono rivelati corretti.

L'esempio più ingegnoso per mostrare quanto problematici siano in realtà i risultati prodotti dai sistemi di riconoscimento facciale viene però forse, ancora una volta, dall'ACLU. Per dimostrare che quello che Amazon offre alle forze dell'ordine, Rekognition, non è affidabile come vorrebbe il colosso tecnologico, ACLU ha deciso di metterlo alla prova rispetto alle foto identificative dei membri del Congresso degli Stati Uniti. Risultato? Ventotto sono stati identificati come altre persone, per giunta tutte già responsabili di un qualche crimine in passato.

Ma non è tutto. Anche in questo caso, vittima in modo sproporzionato degli errori del sistema sono stati i membri del Congresso di colore: anche se rappresentano il 20% del totale, sono stati coinvolti nel 40% degli errori.

Terribile, ma non sorprendente, se si pensa che Reuters ha scoperto che Amazon era già stata costretta a scartare un sistema di AI che assegnava automaticamente un punteggio a ogni candidato per offerte di lavoro ("un po' come chi fa shopping vota i prodotti su Amazon", nota perfidamente l'articolo) perché aveva dato risultati “sessisti”, sbilanciati a sfavore delle donne. Non intenzionalmente, certo: è il risultato di addestrare gli algoritmi sulla base di un decennio di dominio incontrastato degli uomini nelle assunzioni. A questo modo, scrive Reuters, "il sistema di Amazon si era auto-insegnato a considerare preferibili i candidati di sesso maschile".

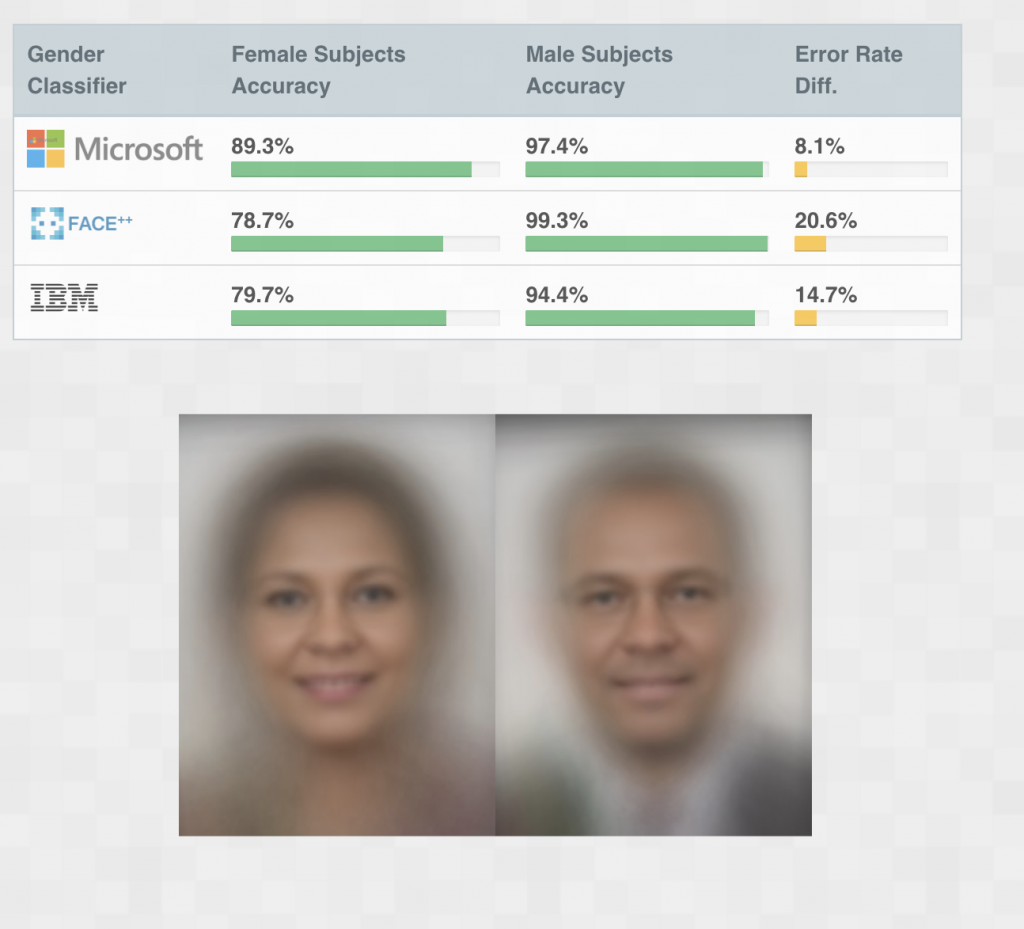

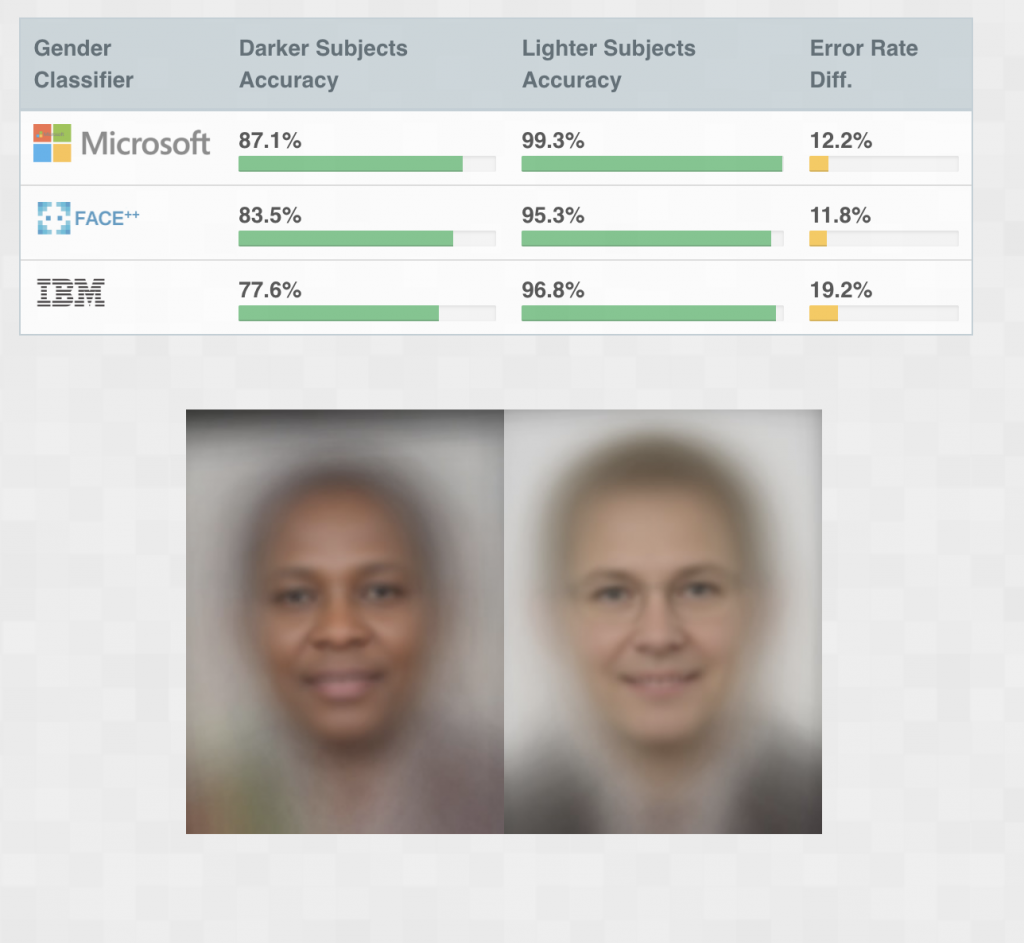

E non è un problema che riguarda la sola Amazon, ma l'intero settore. Risultati peggiori in termini di accuratezza nel riconoscimento si ottengono infatti, rivela il progetto "Gender Shades", anche per Microsoft, Face++ e IBM. "Mentre tutte le aziende sembrano mostrare un grado relativamente alto di accuratezza complessiva (Microsoft 93,7%, Face++ 90% e IBM 87,9%)", si legge, "tutte forniscono prestazioni migliori per i maschi rispetto alle femmine, con una differenza tra l'8,1 e il 20,6% nel tasso di errori". Lo stesso si verifica con i soggetti dalla pelle più chiara rispetto a quelli dalla pelle più scura, anche qui con un differenziale massimo intorno al 20% (19,2%).

Le aziende hanno reagito immediatamente, correggendo gli algoritmi. Ma oltre al fatto che anche un tasso dello 0,1% può significare problemi reali e ingiustificati per centinaia di persone, resta un problema, enorme, di trasparenza, dato che nessuna delle aziende studiate fornisce stime accurate sull'accuratezza dei propri algoritmi, dicono i ricercatori del progetto.

Il monito che ne ricavano sembra uscire, ancora una volta, dai bollettini di una guerra, da un fronte in cui il nemico c'è e avanza:

"I sistemi automatizzati non sono intrinsecamente neutrali. Riflettono le priorità, le preferenze e i pregiudizi - lo sguardo fatto codice - di chi dispone del potere di dare forma a una intelligenza artificiale. Rischiamo di perdere i progressi compiuti con il movimento per i diritti civili e il movimento femminista per ubbidire al falso assunto della neutralità delle macchine. Dobbiamo esigere più trasparenza e responsabilità".

Invece i colossi del digitale che fanno? Preferiscono richiamarsi a un vago bisogno di "regolare" il settore. O scriversi direttamente le leggi da soli.

Cosa dovrebbero fare le grandi aziende della Silicon Valley

In uno splendido saggio sul Daily Beast, Zoè Samudzi racconta che gli effetti discriminatori e razzisti degli algoritmi di riconoscimento facciale sugli afroamericani erano abbondantemente prevedibili. "Come fotografa", argomenta, "vedo il facial recognition come un'estensione della storica sparizione delle persone di colore dalla pellicola a colori".

Allora, ricorda l'articolo tramite le parole dell'icona di generazioni, Steve McQueen, serviva più luce per illuminare Sidney Poitier che Rod Steiger, altrimenti Poitier, di pelle scura, non sarebbe risultato ben visibile. Oggi serve più attenzione per categorizzare correttamente un uomo nero che bianco: chiedere all'algoritmo di Google che metteva per sbaglio i neri nella categoria "gorilla" (tre anni dopo, l'azienda ha "risolto" il problema rimuovendo la parola "gorilla" dal sistema di categorizzazione).

I tempi e gli strumenti sono diversi, ma il concetto è chiaro. Se oggi abbiamo il problema di algoritmi ottimizzati per la pelle bianca, dice in sostanza Samudzi, in passato fotografia e cinema hanno prodotto pellicole ottimizzate per la pelle bianca. E chi gioca con l'identità delle persone dovrebbe saperlo. E agire di conseguenza, se proprio non è in grado di prevenire.

Invece i produttori di riconoscimento facciale si sono per lo più ammantati, al solito, di buone intenzioni, per poi continuare a premere il più possibile per un'adozione incondizionata. Oggi è in voga dichiararsi in favore di "regole" per il riconoscimento facciale, e i giornali traboccano di bei gesti e belle dichiarazioni. Microsoft ha dato il suo appoggio a una proposta con qualche moderata tutela dal riconoscimento facciale, solo per opporsi, scrive il New York Times, a una con protezioni ben più sostanziali. Allo stesso modo Zuckerberg dice che Facebook è attento ad avere il consenso degli utenti per il riconoscimento facciale, ma poi si oppone a una norma che richiederebbe di ottenerlo esplicitamente.

Poi c'è Bezos, che riesce insieme a dire che il settore richiede regole, e poi dare mandato al suo team legale di stendere una proposta di legge per realizzarlo. Amazon regola i device di Amazon che Amazon contratta in segreto con le forze dell'ordine: è proprio vero che, come recita il nuovo motto del quotidiano di cui Bezos è proprietario, "democracy dies in darkness".

E dire che i colossi digitali avrebbero un altro esempio storico da cui trarre insegnamenti, in termini di comportamenti realmente etici e responsabili. Viene da un settore diverso: quello assicurativo. Ma se le aziende sono fatte per il profitto, si potrebbe immediatamente obiettare, che c'entrano gli "insegnamenti", gli "esempi", la moralità? Come scrive Carly Kind, direttrice dell'Ada Lovelace Institute, sul Financial Times, c'entrano eccome: "Quando consideriamo le tecnologie di riconoscimento facciale, non dobbiamo discutere solo ciò che è legale, ma anche ciò che è morale. Per poter fare quel dibattito, dobbiamo però mettere in pausa qualunque ulteriore sperimentazione della tecnologia". E le aziende, e qui sta il punto cruciale, "dovrebbero adottare una moratoria volontaria sul suo utilizzo".

Vero per qualunque azienda delle dimensioni di Amazon e degli altri colossi del digitale. Ma per aziende che proclamano ideologicamente di "non fare del male", "unire le persone" e salvare il mondo connettendolo e disintermediandolo, beh, è il minimo sindacale.

E non sarebbe nemmeno un gesto senza precedenti. Scrive Kind che quando a fine anni '90 i test genetici sono diventati abbastanza economici da diventare routine, le compagnie assicurative avrebbero potuto richiedere ai clienti di rivelarne gli esiti, modulando il premio a seconda di cosa dicessero delle prospettive vitali del proprietario della polizza. Avrebbero potuto, in assenza di regole. Ma non l'hanno fatto.

Quello che hanno fatto, al contrario, è stato auto-imporsi una moratoria di due anni, poi di volta in volta rinnovata, in accordo con circa il 98% dei rappresentanti del settore, fino a diventare un codice volontario e condiviso per l'utilizzo dei dati genetici nel sistema assicurativo.

Kind conclude sostenendo che i governi sono oggi troppo deboli per intervenire con una moratoria, e dunque invita le aziende ad avere uno scatto deontologico e auto-imporselo, così che si possa avere tutti una seria e informata discussione democratica sul ruolo del riconoscimento facciale nella società. Altri invece confidano nei propositi legislativi dell'Unione Europea a guida Ursula Von Der Leyen, o nel successo delle iniziative degli attivisti per ottenerne il bando.

Ma il presupposto è che, nel frattempo, la giostra si fermi. In un modo o nell'altro, ma si fermi.

E va fermata, che in Silicon Valley piaccia o meno.

Immagine in anteprima via Cnet