La diffusione di foto senza consenso e le accuse a Meta di non proteggere i minori sulle sue piattaforme

7 min letturaLa Motion Picture Association (MPA) ha diffidato Meta dall’utilizzo della classificazione PG-13 per indicare i contenuti di Instagram vietati ai minori di 13 anni. Il PG-13 è un sistema di classificazione certificato dalla MPA che definisce i contenuti adatti a un pubblico dai 13 anni in su. Lo scorso ottobre l’azienda di Menlo Park – che possiede e gestisce diverse piattaforme di social media e servizi di comunicazione di rilievo, tra cui Facebook, WhatsApp, Messenger e Threads – aveva annunciato l’introduzione di un sistema che si ispirava al PG-13 per proteggere i minori da contenuti adatti a un pubblico adulto.

“Ci siamo ispirati a un linguaggio che i genitori conoscono bene, quello della classificazione dei film. Il PG-13 rappresenta un equilibrio: consente alcune espressioni più forti o temi complessi, ma esclude tutto ciò che sarebbe inappropriato per un adolescente”, aveva dichiarato all’epoca Max Eulenstein, responsabile del product management di Instagram.

Con le nuove linee guida Instagram dichiarava di nascondere e non suggerire più contenuti che contenessero nudità, linguaggio esplicito o violenza eccessiva, e di ridurre la visibilità di profili che trattano temi come la sessualità o l’uso di sostanze. Il nuovo sistema ostacolerebbe più difficile anche la ricerca attiva di materiale per adulti: gli algoritmi che regolano i suggerimenti e le esplorazioni sarebbero aggiornati per filtrare automaticamente ciò che non rientra nei limiti del PG-13.

Ora è arrivata la diffida da MPA che già in passato aveva affermato di non essere stata contattata da Meta prima dell’annuncio del suo nuovo strumento di moderazione dei contenuti per gli account Instagram per adolescenti. MPA ha chiesto a Meta di eliminare ogni riferimento alla classificazione PG-13 perché la classificazione usata su Instagram è falsa e ingannevole. Le restrizioni dei contenuti non sono paragonabili a quelle per i film, perché si basano sull’intelligenza artificiale.

“La MPA ha lavorato decenni per guadagnarsi la fiducia del pubblico nel suo sistema di classificazione. Qualsiasi insoddisfazione nei confronti della classificazione automatizzata di Meta porterà inevitabilmente il pubblico a mettere in discussione l’integrità del sistema di classificazione della MPA”, spiega MPA.

Un portavoce di Meta ha dichiarato che la classificazione PG-13 verrà usata solo come riferimento e non verrà affermato da nessuna parte che le restrizioni su Instagram sono certificate dalla MPA.

Non è la prima volta che Meta è criticata per non tutelare i minori. Genitori, associazioni e legislatori hanno accusato spesso l’azienda di esporre i minori a contenuti dannosi e rendere difficile per le famiglie controllare la vita digitale dei figli.

A settembre un ex ingegnere di Meta, Arturo Béjar, ha pubblicato una ricerca che mostrava l’inefficacia di gran parte dei nuovi strumenti di sicurezza introdotti su Instagram, soprattutto nei confronti dei minori al di sotto dei 13 anni. Béjar ha testimoniato contro l'azienda davanti al Congresso degli Stati Uniti, agli accademici della New York University e della Northeastern University, alla Molly Rose Foundation del Regno Unito e ad altri gruppi.

Sebbene Meta “faccia costantemente promesse” su come i suoi account per adolescenti proteggano i bambini da “contenuti sensibili o dannosi, contatti inappropriati, interazioni dannose”, questi strumenti di sicurezza sono per lo più “inefficaci, modificati silenziosamente o rimossi”, ha dichiarato Béjar: “A causa della mancanza di trasparenza di Meta, chissà da quanto tempo è così e quanti adolescenti hanno subito danni per mano di Instagram a causa della negligenza di Meta e delle promesse fuorvianti di sicurezza, che creano un falso e pericoloso senso di sicurezza”.

“Non si tratta di contenuti dannosi su Internet, ma di una progettazione del prodotto poco accurata”, ha precisato Béjar. “Le scelte consapevoli di Meta in materia di progettazione e implementazione dei prodotti selezionano, promuovono e portano ogni giorno ai bambini contenuti inappropriati, contatti e un uso compulsivo“.

Meta ha respinto i risultati del rapporto.

Sempre a settembre, nel Regno Unito, un uomo di 37 anni di Londra ha dichiarato al Guardian, a condizione di restare anonimo, di aver ricevuto sul suo feed Instagram post che lo invitavano a scaricare Threads, con immagini di minorenni in uniforme al rientro a scuola col volto visibile e, nella maggior parte dei casi, anche il nome.

Le immagini delle minorenni sono state utilizzate da Meta dopo che i loro genitori le avevano pubblicate su Instagram per raccontare il loro ritorno a scuola. I genitori non sapevano che le impostazioni di Meta consentivano questo utilizzo. Una madre ha affermato che il suo account era impostato come privato, ma i post venivano automaticamente pubblicati anche su Threads, dove erano visibili. Un'altra ha detto di aver pubblicato la foto su un account Instagram pubblico.

I post delle loro figlie messi in evidenza all’utente di Instagram come “thread suggeriti”. L’uomo ha raccontato al Guardian che i post sembravano “deliberatamente provocatori e, in definitiva, sfruttatori dei bambini e delle famiglie coinvolte. Come padre, trovo profondamente inappropriato che Meta riutilizzi questi post in promozioni mirate agli adulti”, precisando di non aver pubblicato né messo “mi piace” a immagini simili prima di ricevere le foto delle studentesse. Le immagini erano tutte di studentesse in gonne corte con gambe nude o calze.

“Quando ho scoperto che un'immagine di mia figlia era stata sfruttata in modo sessualizzato da una grande azienda come quella per commercializzare il proprio prodotto, mi sono sentito piuttosto disgustato”, ha detto il padre di una bambina.

La madre di una quindicenne la cui foto è stata utilizzata in un post promozionale con un grande pulsante “Get Threads” ha dichiarato: "Per me era una foto di mia figlia che andava a scuola. Non avevo idea che Instagram l'avesse presa e la stesse usando come promozione. È assolutamente disgustoso. È minorenne“. Ha poi aggiunto che avrebbe rifiutato di dare il consenso e che “per nessuna cifra al mondo avrei permesso loro di usare una ragazza in uniforme scolastica per attirare persone sulla [loro piattaforma]”.

Con 267 follower, il suo account Instagram aveva solitamente una portata modesta, ma il post di sua figlia ha attirato quasi 7.000 visualizzazioni, il 90% delle quali da non follower, metà dei quali di età superiore ai 44 anni e il 90% dei quali uomini.

Un'altra madre, il cui post della figlia tredicenne è stato utilizzato in un post promozionale, ha dichiarato: “Meta ha fatto tutto questo di proposito, senza informarci, perché vuole generare contenuti. È spregevole. E chi è responsabile della creazione di quell'annuncio su Threads che utilizza le foto dei bambini per promuovere la piattaforma per uomini più grandi?”.

Meta, l'azienda da 2.000 miliardi di dollari con sede a Menlo Park, in California, ha affermato che le immagini e il suo utilizzo non violano le sue politiche perché si trattava di post pubblicati da account di adulti impostati per consentire la visualizzazione pubblica.

“Le immagini condivise non violano le nostre politiche e sono foto di ritorno a scuola pubblicate dai genitori. Abbiamo sistemi in atto per garantire che non vengano raccomandati Threads condivisi da adolescenti o che violino le nostre linee guida di raccomandazione, e gli utenti possono controllare se Meta suggerisce i loro post pubblici su Instagram”, ha dichiarato un portavoce dell'azienda.

Beeban Kidron, membro indipendente della Camera dei Lord e attivista per i diritti dei minori online, ha dichiarato: “Utilizzare ragazze in età scolare come esca per pubblicizzare un servizio commerciale è un nuovo minimo storico anche per Meta. In ogni occasione Meta privilegia il profitto rispetto alla sicurezza e la crescita dell'azienda rispetto al diritto alla privacy dei minori”.

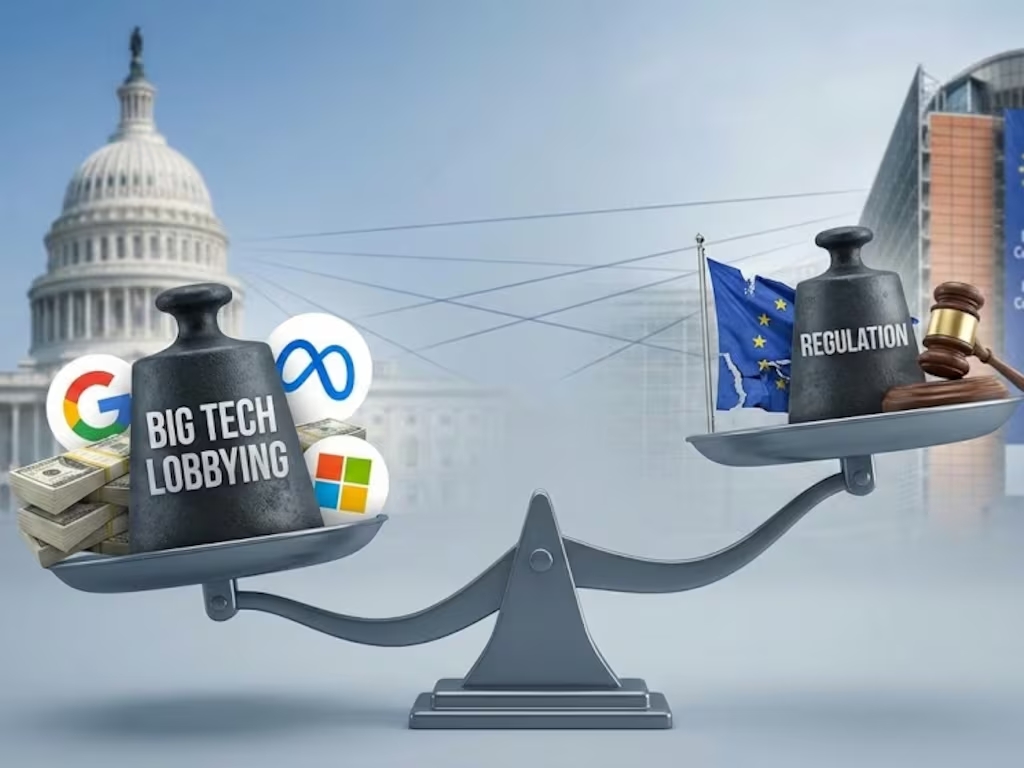

Lo scorso ottobre è arrivato un rapporto preliminare della Commissione Europea secondo il quale Instagram e Facebook violano la normative UE non offrendo agli utenti modalità facilmente accessibili per segnalare contenuti illegali, tra cui materiale pedopornografico e contenuti terroristici.

Entrambe le piattaforme sembrano utilizzare un design ingannevole nel meccanismo di segnalazione, al punto da risultare “confuso e dissuasivo” per gli utenti, spiega la Commissione. In altri termini, il meccanismo è così farraginoso e complicato da dissuadere gli utenti dal portare a termine il processo di segnalazione dei contenuti illegali. E ciò costituisce una violazione degli obblighi dell'azienda ai sensi del Digital Services Act (DSA).

La questione non si limita alla segnalazione dei soli contenuti illegali, ma riguarda anche la libertà di espressione e una “moderazione che è andata troppo oltre”, ha affermato un alto funzionario UE. In passato, Facebook è stato accusato di “shadow banning” (oscuramento) degli utenti su alcuni temi, come ad esempio la Palestina, il che significa che i loro contenuti vengono declassati dall'algoritmo.

È infine difficile fare ricorso per gli utenti i cui contenuti sono stati bloccati o i cui account sono stati sospesi. La Commissione ha riscontrato che “il meccanismo di ricorso contro le decisioni non sembra consentire agli utenti di spiegare o fornire prove a sostegno dei loro ricorsi, limitandone l’efficacia.

Inoltre, Meta (e TikTok) non avrebbe consentito ai ricercatori un accesso adeguato ai dati delle piattaforme per poter verificare in che misura i minori sono esposti a contenuti illegali o dannosi, dando loro fonti parziali o inaffidabili. “Consentire ai ricercatori di accedere ai dati delle piattaforme è un obbligo di trasparenza essenziale ai sensi del DSA, in quanto fornisce un controllo pubblico sul potenziale impatto delle piattaforme sulla nostra salute fisica e mentale”, ha affermato la Commissione.

Nel caso in cui Meta non si conformi alle richiesta della Commissione, sarà soggetta a una sanzione pecuniaria fino al 6% del fatturato annuo totale a livello mondiale.

“Le nostre democrazie dipendono dalla fiducia. Ciò significa che le piattaforme devono responsabilizzare gli utenti, rispettare i loro diritti e aprire i loro sistemi al controllo. Stiamo facendo in modo che le piattaforme siano responsabili dei loro servizi, come garantito dal diritto dell'UE, nei confronti degli utenti e della società”, ha affermato Henna Virkkunen, vicepresidente esecutivo della Commissione per la sovranità tecnologica, la sicurezza e la democrazia.

Meta ha negato di aver violato la legge: “Nell'Unione Europea, abbiamo introdotto modifiche alle nostre opzioni di segnalazione dei contenuti, al processo di ricorso e agli strumenti di accesso ai dati da quando il DSA è entrato in vigore e siamo certi che queste soluzioni siano conformi a quanto richiesto dalla legge dell'UE”.

Immagine in anteprima: Foto di Julio Lopez via Pexels